En los últimos años, la inteligencia artificial ha avanzado a pasos agigantados, y uno de los desarrollos más innovadores ha sido la creación y expansión de los modelos de lenguaje a gran escala, conocidos como LLMs (Large Language Models). Estos modelos, como ChatGPT, han irrumpido con fuerza en el mercado tecnológico, integrándose en múltiples herramientas, aplicaciones y servicios que prometen transformar la manera en que interactuamos con la información y resuelvemos problemas cotidianos. Sin embargo, pese a la popularidad y el entusiasmo que rodea a estos sistemas, es vital hacer una pausa para reflexionar sobre lo que realmente pueden hacer y los límites inherentes a su arquitectura. La inteligencia artificial no es una solución única y universal, y comprender esta realidad es fundamental para evitar expectativas irreales y desilusiones futuras. Los modelos de lenguaje son máquinas asombrosas para tratar con información no estructurada.

Su fortaleza radica en la capacidad para sintetizar, resumir y asistir en razonamientos que abarcan vastas bases de datos, textos o diálogos. Pueden generar contenido coherente, crear traducciones, responder preguntas complejas y ofrecer soporte a través del lenguaje natural, acercándonos cada vez más a la experiencia de conversar con un ser humano. Aun así, es importante destacar que estos modelos están diseñados para predecir secuencias de palabras basándose en el contexto, lo que los hace excepcionales en tareas lingüísticas, pero limitados para procesos que requieren un control riguroso o sistemas con objetivos claros y específicos. Cuando hablamos de automatización empresarial o de sistemas críticos que demandan un comportamiento determinista, el exceso de confianza en los LLMs puede convertirse en un problema. Estos modelos no tienen memoria persistente ni bases de conocimiento estructuradas que les permitan seguir lógicas de pasos múltiples de manera infalible.

Así, en entornos donde una falla pequeña pueda generar consecuencias significativas, confiar únicamente en predicciones lingüísticas puede ser riesgoso y poco eficiente. Por ejemplo, en procesos de reservas automáticas, gestión de bases de datos o diagnóstico de sistemas, los errores y las desviaciones se manifiestan con frecuencia, evidenciando la fragilidad de los agentes basados exclusivamente en modelos de lenguaje. Para comprender mejor esta cuestión, es útil comparar los LLMs con otras paradigmas clásicos de inteligencia artificial. Los sistemas simbólicos o máquinas de estado operan con lógica rígida, ideales para flujos de trabajo estructurados donde cada acción debe seguir reglas específicas y predefinidas. Aunque estos enfoques carecen de flexibilidad frente a la ambigüedad o la información incierta, son indispensables cuando se necesita precisión y confiabilidad.

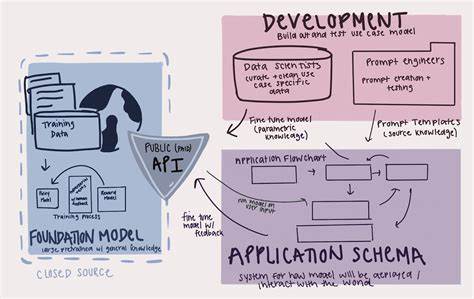

Por otra parte, el aprendizaje por refuerzo aporta una metodología para optimizar comportamientos a partir de la retroalimentación continuada, siendo especialmente apto para tareas de planificación y adaptación en entornos dinámicos, aunque su entrenamiento y escalabilidad presentan desafíos técnicos considerables. El gran error en la actualidad es tratar a los modelos de lenguaje como si fueran agentes generales capaces de reemplazar cualquier tipo de sistema lógico o de control. Esta tendencia se ha visto impulsada no solo por la fascinación tecnológica, sino también por intereses comerciales y narrativas de marketing que venden un futuro en el que las máquinas de lenguaje ejecutan tareas complejas sin supervisión ni fallos. Para intentar superar estas limitaciones, han surgido marcos de trabajo basados en agentes múltiples donde diferentes modelos de lenguaje asumen roles específicos, como planificador, ejecutor o supervisor. Sin embargo, esta solución, lejos de ser definitiva, en ocasiones simplemente enmascara problemas fundamentales de coordinación y orquestación, trasladando los cuellos de botella a escalas mayores y aumentando la complejidad del sistema.

Esta configuración crea un efecto de «comité» en el que las unidades autónomas pueden perder coherencia, cometer errores y generar información imprecisa, especialmente si no existe una memoria compartida o un sistema de estado persistente que unifique sus acciones. Además, la dificultad para supervisar un número creciente de agentes es exponencial, lo que limita la escalabilidad de las soluciones basadas únicamente en modelos lingüísticos. Frente a este escenario, la realidad es que el lenguaje predictivo no puede ser la columna vertebral de procesos deterministas complejos ni sustituir a motores especializados de ejecución o flujos de trabajo diseñados con rigor. Otro fenómeno que debe ser analizado con cuidado es el llamado «trampa de las demostraciones». En conferencias, lanzamientos y eventos de producto es común presenciar demostraciones impresionantes en las que agentes de inteligencia artificial realizan reservas de viaje, gestionan sistemas de atención al cliente o diagnostican problemas técnicos en tiempo real.

Estas pruebas generan entusiasmo y expectativas altas, pero frecuentemente no reflejan la robustez necesaria para trabajos en producción. Las fallas en el manejo de excepciones, el uso inadecuado de herramientas complementarias o la imposibilidad de adaptarse a casos límite muestran que, detrás del brillo, todavía existen agujeros sustanciales que impiden la implementación masiva confiable. Vale la pena recalcar que esta limitación no denota una falta de capacidad intrínseca de los modelos de lenguaje, sino que revela la diferencia entre predicción de lenguaje y ejecución de procesos automatizados. Mientras que los humanos también enfrentan dificultades al tratar de administrar tareas complejas con múltiples condiciones y excepciones, poner toda la carga sobre inteligencia artificial basada en texto sin soporte adicional puede llevar a resultados inconsistentes y frustrantes. Un aspecto inquietante del debate actual es la aparente falta de voces críticas provenientes de los expertos que conocen las verdaderas restricciones de los LLMs.

Investigadores de renombre, fundadores de laboratorios y ejecutivos con acceso a información privilegiada a menudo optan por mantener un discurso alineado con la narrativa optimista del progreso hacia una inteligencia artificial general. Este silencio o complacencia levanta preguntas sobre la ética en la comunicación científica y empresarial, especialmente cuando el mercado presiona por resultados y la expectativa de crecimiento constante opaca los mensajes de prudencia. Es comprensible que factores como la competencia global, los intereses de los inversores y la dinámica del ecosistema tecnológico influyan en esta postura. No obstante, adoptar una visión realista y transparente puede ofrecer beneficios a largo plazo, encaminando los esfuerzos hacia desarrollos más sostenibles y significativos en lugar de perpetuar ilusiones poco viables. En este sentido, algunas iniciativas buscan tender puentes entre el poder de los modelos de lenguaje y la necesidad de estructuras sólidas de memoria y estado.

Proyectos que integran infraestructuras externas para almacenamiento persistente y gestión de contexto avanzado pretenden convertir a los LLMs en participantes contextuales dentro de sistemas más amplios, mejorando su capacidad para mantener coherencia y ejecutar tareas multifase con mayor eficiencia. Esta mezcla podría representar el futuro de la IA aplicada, donde la sinergia entre tecnologías permite superar las barreras que cada paradigma enfrenta por separado. En definitiva, la inteligencia artificial basada en modelos de lenguaje continúa transformando el panorama tecnológico, pero no debe ser vista como la panacea absoluta para todos los problemas relacionados con automatización y toma de decisiones. Reconocer sus fortalezas, pero también sus limitaciones, es crucial para diseñar sistemas inteligentes realmente efectivos. Los avances vendrán de la combinación inteligente de distintas técnicas, un compromiso ético con la divulgación honesta y una planificación que contemple las complejidades reales del mundo empresarial y social.

Solo así se podrá construir una inteligencia artificial inclusiva, robusta y verdaderamente útil para la humanidad.