Common Crawl es una iniciativa que ha revolucionado la manera en la que investigadores, desarrolladores y analistas acceden al vasto universo de datos disponibles en la web. Ofreciendo un enorme archivo de datos recopilados a través de rastreadores web, Common Crawl pone a disposición un recurso invaluable para múltiples propósitos, desde la inteligencia artificial hasta estudios de mercado. Sin embargo, dada la magnitud y complejidad de los datos, muchos usuarios buscan métodos más accesibles para interactuar con estos archivos, específicamente a través de API que simplifiquen el acceso y análisis. En este contexto, surge la pregunta recurrente: ¿existe algún servicio que ofrezca Common Crawl como API? Una interrogante que no solo refleja una necesidad técnica sino también una demanda creciente en el ecosistema digital actual. La filosofía de Common Crawl se basa en la apertura y accesibilidad, liberando un volumen ingente de datos brutos que permiten análisis profundos y la creación de aplicaciones basadas en la información web.

No obstante, el tamaño y formato de los archivos pueden convertirse en una barrera para usuarios que no cuentan con infraestructura técnica para procesar grandes cantidades de datos. Frente a este desafío, la comunidad tecnológica ha empezado a ofrecer soluciones intermedias que funcionan como puentes entre los datos en bruto y el usuario final. Uno de los recursos más recomendados dentro de la comunidad de desarrolladores es index.commoncrawl.org, un servicio que permite realizar búsquedas por dominio utilizando comodines.

Esta herramienta funciona como una especie de índice accesible mediante consultas que facilitan obtener listas de URLs y páginas específicas asociadas a un dominio. De esta forma, el usuario puede acceder a la información que necesita sin descargar y procesar todo el conjunto de datos. Sin embargo, aunque index.commoncrawl.org es útil, no cubre del todo las necesidades de quienes desean un API de acceso flexible y que devuelva no solo URLs sino su contenido HTML.

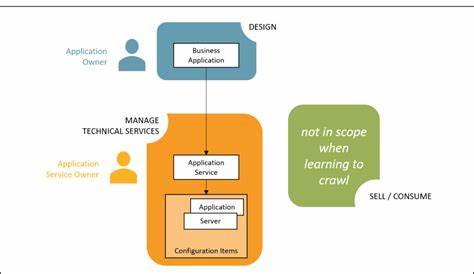

Este nivel de acceso es esencial para muchas aplicaciones que requieren análisis del contenido real de las páginas web para tareas como minería de texto, extracción de datos o entrenamientos de modelos de lenguaje. Para aquellos que buscan alternativas o herramientas que complementen o amplíen las posibilidades de acceso a Common Crawl, existen proyectos interesantes como Wayurls. Esta herramienta disponible en GitHub provee funcionalidades que permiten trabajar con datos de Common Crawl de manera más directa y en entornos localizados, ofreciendo métodos para extraer URLs y otros metadatos. Si bien aún no es una API de acceso completo con todas las funcionalidades, es un recurso valioso para quienes tienen conocimiento técnico y pueden adaptar estas herramientas a sus requerimientos específicos. Más allá de estas opciones, el ecosistema de Common Crawl está evolucionando lentamente hacia soluciones más automatizadas y accesibles, con diferentes empresas y desarrolladores experimentando con varias implementaciones de API que abstraen el trabajo pesado del procesamiento de datos.

Algunas plataformas de análisis de datos y proveedores de servicios en la nube están comenzando a integrar extractores y conectores que facilitan la consulta eficiente de Common Crawl sin tener que manejar los datos directamente. En este sentido, la externalización del procesamiento a través de servicios API puede ser un cambio significativo, permitiendo a investigadores y empresas usar grandes datos web sin grandes inversiones en infraestructura. Otra dimensión relevante a considerar es la necesidad de filtrar y estructurar los datos correctamente para que puedan ser útiles en el análisis. Common Crawl ofrece datos en formatos específicos que requieren conocimiento y herramientas especiales para su manipulación, lo que puede ser una barrera para usuarios sin experiencia en procesamiento de datos a gran escala. Por ello, contar con una API que ofrezca respuestas estructuradas, buscando solo la información necesaria como hostnames, URLs y contenido HTML, es un valor agregado considerable.

Es importante también resaltar que la comunidad de Common Crawl es abierta y participativa, por lo que existen foros, repositorios y grupos donde se discuten constantemente avances relacionados con este tópico, además de compartir desarrollos que ponen a disposición APIs o interfaces más amigables. En definitiva, aunque en la actualidad no existe un servicio de API oficial que entregue Common Crawl en su totalidad de manera sencilla, las herramientas y recursos disponibles acercan a los usuarios a este objetivo. El interés creciente por contar con APIs accesibles y eficientes para trabajar con Common Crawl seguirá impulsando el desarrollo de nuevas soluciones. Para aquellos interesados en el análisis de datos web que no desean navegar el complejo proceso de descarga y procesamiento de archivos masivos, explorar index.commoncrawl.

org o herramientas como Wayurls puede ser un buen punto de partida. La evolución de este panorama seguramente traerá en el corto plazo servicios más especializados y fáciles de utilizar, optimizando la interacción con uno de los recursos de datos online más valiosos y revolucionarios de la actualidad. Hasta entonces, combinar soluciones existentes con conocimientos técnicos específicos permitirá aprovechar al máximo el potencial de Common Crawl para análisis, desarrollo y generación de valor a partir de la información disponible en la web.