En el vasto panorama de las redes sociales, Reddit destaca como uno de los foros más activos que reúne a usuarios con intereses diversos, desde temáticas casuales hasta comunidades con ideologías extremas. En este contexto, la irrupción de comunidades misóginas y misándricas ha generado preocupación por sus impactos sociales y culturales, planteando interrogantes sobre cómo se expresan estas formas de odio de género en el espacio digital y si existen diferencias significativas entre ellas. La comprensión de estas dinámicas es esencial para diseñar estrategias efectivas que promuevan un ambiente digital inclusivo y seguro para todos. La misoginia, definida como el odio o prejuicio contra las mujeres, ha sido objeto de numerosos estudios, los cuales evidencian cómo esta actitud se traduce en mensajes discriminatorios, violencia simbólica, y normalización de la desigualdad. Por otro lado, la misandria —conceptualizada como la aversión hacia los hombres— a pesar de ser igualmente dañina, ha recibido escasa atención académica y social, quedando infraexplorada en la mayoría de las investigaciones relacionadas con la violencia y el discurso de odio en línea.

A partir de esta brecha se origina la importancia de analizar ambas perspectivas para entender si las expresiones extremas de odio de género varían según el sexo del perpetrador o si, por el contrario, comparten características comunes. En un estudio reciente que toma como base cuatro comunidades extremistas de Reddit, dos con un enfoque misógino y dos con un tono misándrico, se realizó un análisis exhaustivo que abarcó tres dimensiones principales: las características lingüísticas, las emociones transmitidas y las estructuras de interacción entre los usuarios. Reddit, con su formato basado en subforos temáticos denominados “subreddits”, permite la participación activa de múltiples usuarios en discusiones públicas y anónimas. Esta cualidad lo convierte en un microcosmos ideal para evaluar cómo se construyen las narrativas de odio y cómo estas inciden en el comportamiento colectivo. Las comunidades investigadas han sido seleccionadas por su relevancia e impacto, entre ellas están r/Incels y r/MensRights, representativas de posturas misóginas, y r/Feminism y r/GenderCritical, reconocidas por adoptar una perspectiva misándrica radical en algunos de sus discursos.

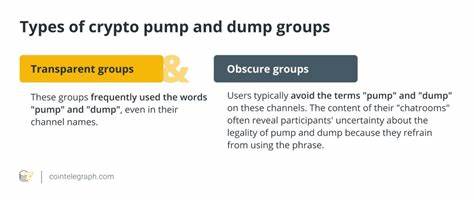

El análisis de las palabras más empleadas en estas comunidades revela que, a pesar de ciertas palabras clave específicas de cada grupo, como “violación” en algunos espacios misóginos o “trans” en foros feministas radicales, existe una notable coincidencia en el vocabulario más frecuente. Tanto hombres como mujeres expresan rechazo, odio y resentimiento a través de términos comunes, lo que indica que, en el fondo, estas comunidades extremistas comparten patrones lingüísticos semejantes que refuerzan discursos dañinos. En cuanto a la toxicidad del contenido, evaluada con un modelo avanzado de inteligencia artificial que detecta discursos de odio, se encontró que las comunidades misóginas presentan niveles más elevados en promedio. Sin embargo, la distribución general de toxicidad en todos los grupos muestra una polarización: la mayoría de los mensajes son no tóxicos o altamente tóxicos, con poca presencia de mensajes moderados. Esto sugiere un ambiente discursivo extremado, donde la neutralidad o el debate constructivo pocos espacios encuentran.

Las emociones predominantes en los textos de estas comunidades abarcan sentimientos negativos como odio, ira, miedo y tristeza. Cuando se evalúan las emociones a nivel de contenido individual, las comunidades feministas y pro-derechos masculinos exhiben patrones emocionales próximos, destacando el odio y la ira. Aunque a nivel de usuario el panorama se modifica, con los colectivos misándricos demostrando mayor expresión de odio, especialmente en comunidades radicales, lo que evidencia que ciertos individuos perpetúan emociones negativas más intensas y persistentes. La estructura relacional entre los usuarios, evaluada mediante análisis de grafos que representan sus interacciones, no mostró diferencias significativas entre los diferentes subreddits. Todos manifestaron la formación de comunidades con comportamientos colectivos similares, como presencia de subgrupos cerrados y varios niveles jerárquicos, lo que sugiere que la lógica de interacción dentro de espacios extremistas es comparable independientemente de la dirección del odio de género.

Este hallazgo es relevante porque indica que los mecanismos de radicalización, difusión y retroalimentación de mensajes hostiles no dependen tanto del género objetivo, sino que son producto de dinámicas internas de los grupos extremistas que podrían estar vinculadas a factores psicológicos, sociales y tecnológicos comunes. Asimismo, al constatar que tanto misóginos como misándricos utilizan estrategias discursivas semejantes para mantener la cohesión grupal y la polarización, se plantea la necesidad de adoptar enfoques de intervención integral y neutral al género para combatir eficazmente el discurso de odio en línea. La investigación también destaca algunos desafíos y limitaciones inherentes a la utilización de datos abiertos de plataformas públicas, entre resultados expuestos la presencia de ruido en los datos y la necesidad de depuración constante. Además, advierte sobre el riesgo de generalizar las conclusiones a otras redes sociales, dado que Reddit posee características específicas como permitir discusiones amplias y colectivas que lo diferencian de plataformas donde la comunicación es más fragmentada y personal. Los resultados obtenidos con esta aproximación multidimensional invitan a reflexionar desde distintas aristas.

A nivel social, se visibiliza que el odio de género no es un fenómeno unilateral, sino bidireccional, lo que puede ayudar a desmontar narrativas simplificadas que ignoran experiencias y expresiones de violencia dirigidas hacia ambos géneros. Por ende, es fundamental fomentar políticas y prácticas en plataformas digitales que reconozcan esta complejidad y promuevan la equidad y el respeto mutuo. Desde la perspectiva técnica, mejorar los sistemas automáticos de detección de contenido nocivo incorporando el reconocimiento de ambas vertientes del discurso de odio posibilita un monitoreo más justo y efectivo. Además, se sugiere que las plataformas implementen mecanismos que combinen medidas punitivas con intervenciones proactivas, por ejemplo, facilitando el acceso a recursos de apoyo emocional y psicológico para usuarios expuestos a este tipo de comunidades. En el ámbito académico, estos estudios inaugurales sobre la misandria en ambientes digitales abren camino a investigaciones futuras que analicen otros factores como la influencia de bots o cuentas automatizadas en la propagación del ruido tóxico, o la formación de subgrupos con radicalización diferenciada dentro de las mismas comunidades.

También plantea oportunidades para explorar cómo cambian estas dinámicas en diferentes contextos culturales y tecnológicos. En definitiva, el análisis comparativo de comunidades extremistas en Reddit muestra que, pese a algunas diferencias superficiales, las fuerzas que impulsan el odio de género en línea operan bajo principios estructurales y emocionales comunes, independientemente del género al que se dirigen. Para contribuir a una convivencia digital más saludable, es imprescindible reconocer y abordar ambas caras de esta realidad con igual compromiso y profundidad. El reconocimiento de este fenómeno es un paso fundamental hacia el desarrollo de estrategias integrales que permitan mitigar el discurso de odio digital y promover espacios donde la diversidad de género se respete y valore, contribuyendo así a sociedades más justas e inclusivas tanto en el mundo real como en el virtual.