En la era digital actual, la eficiencia y la rapidez en el manejo de información son elementos clave para cualquier desarrollador o empresa que maneje grandes volúmenes de datos provenientes de enlaces web. Obtener una vista previa del contenido y datos relacionados con el editor de un enlace sin tener que realizar scraping directo se ha convertido en una necesidad creciente. Esta práctica no solo optimiza el uso de recursos sino que también mejora la experiencia del usuario y facilita la integración de servicios web. En este contexto, surge el interés por alternativas que extraigan metadatos o información relevante sin recurrir a técnicas invasivas o complejas de scraping que pueden ser costosas y problemáticas debido a diferentes restricciones legales o técnicas. El scraping tradicional implica la descarga y análisis del código HTML de una página web para extraer información visible o no visible directamente para el usuario.

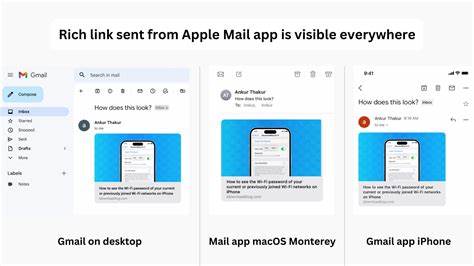

Aunque es una práctica común, tiene varios inconvenientes, entre ellos la alta demanda computacional, el riesgo de ser bloqueado por el servidor objetivo y posibles problemas legales por incumplimiento de términos de servicio. Por lo tanto, muchas empresas y desarrolladores buscan métodos complementarios o alternativos que permitan obtener datos útiles de un vínculo sin necesidad de acceder al contenido completo de la página. Una de las técnicas más utilizadas para obtener una vista previa sin scraping es la extracción de metadatos mediante el análisis de etiquetas específicas presentes en el código fuente. Es común que los sitios web implementen etiquetas Open Graph o Twitter Cards que contienen información predefinida para compartir contenido en redes sociales. Estas etiquetas proporcionan datos como el título, descripción, imagen principal y nombre del editor o autor, entre otros.

Al acceder exclusivamente a estas etiquetas, es posible mostrar una vista previa atractiva sin descargar ni procesar todo el contenido del sitio. Sin embargo, incluso obtener estas etiquetas requiere consultar la página lo que puede ser costoso en términos de tiempo de procesamiento y ancho de banda, especialmente cuando se manejan múltiples enlaces de manera simultánea. En respuesta a esta limitación, servicios especializados han desarrollado APIs y plataformas que centralizan este tipo de información, brindando resultados rápidos con solo enviar una URL como parámetro. Estas soluciones permiten integrar la generación de vistas previas y la extracción de información del editor en aplicaciones y sitios web de forma sencilla y eficiente. Una de las ventajas destacadas al usar estos servicios es la capacidad de escalar operaciones sin complicaciones, ya que la carga de procesamiento recae en la plataforma externa.

Además, la información suele venir acompañada de datos adicionales, como puntuaciones de relevancia, análisis de contenido e incluso datos estructurados relacionados con la empresa o entidad responsable del enlace, lo que enriquece la experiencia tanto para desarrolladores como para usuarios finales. Un enfoque novedoso es el desarrollo de bases de datos internas que mantienen actualizados metadatos y perfiles de editores basados en el histórico de enlaces procesados. Al contar con este respaldo, la extracción de información puede realizarse sin necesidad de consultar el sitio web en cada ocasión, reduciendo considerablemente la latencia y optimizando la experiencia del usuario en aplicaciones que requieren respuestas instantáneas, como motores de búsqueda, tableros de noticias o plataformas de agregación de contenido. Dentro de las consideraciones técnicas para implementar estas soluciones, es crucial manejar correctamente los aspectos relacionados con la privacidad y la legalidad. Algunas páginas web pueden no permitir la extracción o reutilización de sus datos, por lo que es fundamental conocer y respetar los términos de servicio, así como las normativas vigentes sobre protección de datos y derechos de propiedad intelectual.

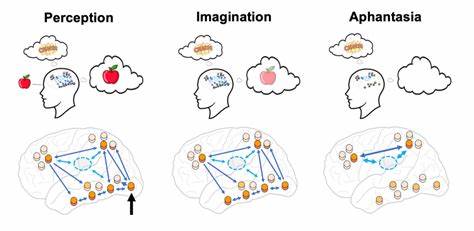

Asimismo, la calidad de los datos extraídos depende en gran medida del estándar y consistencia con que los sitios implementen sus metadatos. En muchos casos, la información puede estar incompleta o no seguir un formato común, lo que obliga a diseñar sistemas robustos capaces de manejar excepciones y diferentes escenarios. La inteligencia artificial y el aprendizaje automático juegan un papel importante en la mejora progresiva de estos sistemas, adaptándose a la diversidad de estructuras presentes en la web. En el mercado existen diversas herramientas y APIs que proporcionan funcionalidades para obtener vistas previas y datos del editor sin scraping tradicional. Al evaluar estas opciones, es recomendable considerar aspectos como la precisión en la extracción, velocidad de respuesta, escalabilidad, seguridad, soporte técnico y precios, para elegir la que mejor se adapte a las necesidades de cada proyecto.

En conclusión, la obtención de vistas previas y datos del editor sin necesidad de scraping es una tendencia que responde a la creciente demanda de eficiencia y cumplimiento legal en el manejo de información web. La implementación de soluciones basadas en la extracción de metadatos, APIs especializadas y bases de datos internas representa una estrategia efectiva para desarrolladores y empresas que buscan integrar contenido externo de manera ágil, segura y respetuosa con las normativas actuales.