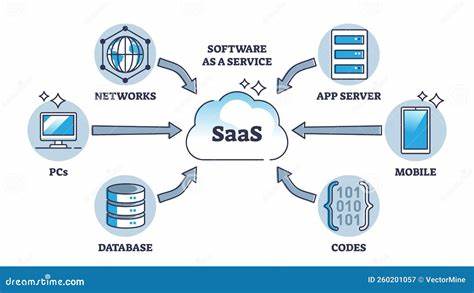

En la evolución constante de las aplicaciones de inteligencia artificial, uno de los retos más significativos que enfrentan los desarrolladores es la capacidad de los modelos para recordar información relevante entre sesiones. Los grandes modelos de lenguaje (LLMs), como GPT, han revolucionado la forma en que interactuamos con la tecnología, ofreciendo respuestas inteligentes y conversacionales. Sin embargo, una limitación considerable es que estos modelos carecen de una memoria persistente integrada, lo que significa que olvidan todo lo discutido una vez que finaliza la sesión a menos que se implemente una capa de memoria personalizada robusta. Esta necesidad ha impulsado la innovación en torno a soluciones de memoria para IA, especialmente en las aplicaciones SaaS (Software como Servicio), donde la experiencia del usuario y la personalización son clave. Una propuesta que está ganando atención es la memoria plug-and-play con alcance específico, una tecnología que permite a los desarrolladores integrar una memoria lista para usar que puede recordar datos segmentados por usuario, agente o proyecto sin los dolores de cabeza asociados con la construcción de una infraestructura propia.

La memoria plug-and-play ofrece un conjunto de beneficios claros. En primer lugar, simplifica el proceso para los equipos de desarrollo, eliminando la necesidad de diseñar y mantener complejos sistemas de almacenamiento de datos y lógica de recuperación. Esto es particularmente atractivo para startups o empresas que buscan agilizar su lanzamiento al mercado sin sacrificar la calidad de la experiencia del usuario. Además, el hecho de que esta memoria pueda escalar y segmentarse según necesidades específicas aumenta su flexibilidad y utilidad. Pero, ¿por qué es crucial la segmentación o el alcance específico? En una aplicación SaaS, no todos los datos deben ser accesibles de la misma manera ni para todos los usuarios.

Por ejemplo, la información sensible de un cliente debe estar aislada, y las interacciones de proyectos distintos deben mantenerse separadas para evitar confusiones y problemas de privacidad. Tener una memoria que pueda limitar el acceso a información según el contexto permite que los modelos de IA funcionen con mayor precisión, seguridad y relevancia. Además, una característica destacada es la posibilidad de establecer tiempos de vida (TTL), que permiten que ciertos datos expiren automáticamente después de un periodo determinado. Esto es vital para cumplir con regulaciones de privacidad, mantener la base de datos limpia y asegurar que la información obsoleta no afecte las decisiones del modelo. La capacidad de exportar datos en cualquier momento añade otra capa de control para los usuarios, fomentando una relación de confianza y evitando el encierro tecnológico.

Asimismo, la integración mediante APIs limpias y simples significa que estas soluciones pueden adaptarse a diversos ecosistemas tecnológicos sin requerir una curva de aprendizaje pronunciada. Los desarrolladores pueden escribir y recuperar datos instantáneamente, agregando un componente crucial de memoria a sus agentes o sistemas de IA sin añadir latencia significativa ni complejidad técnica. No obstante, no todo es un camino libre de desafíos. Algunas voces en la comunidad técnica cuestionan la verdadera innovación que presenta esta memoria plug-and-play, apuntando a la falta de detalles tecnológicos sobre cómo se resuelve el problema a nivel de rendimiento y eficiencia. En entornos donde la rapidez y precisión son vitales, la latencia y la gestión de datos pueden convertirse en cuellos de botella, y delegar esta función a un servicio externo se considera un riesgo por algunos desarrolladores.

A esto se suma la dificultad de medir y cuantificar el valor real aportado por la memoria persistente en aplicaciones fuera del ámbito académico, lo que puede hacer que su adopción sea más lenta. Sin embargo, la tendencia hacia herramientas que abstraen y simplifican componentes complejos, como la memoria en IA, sigue creciendo. La clave está en encontrar el equilibrio entre el control y la facilidad de uso, así como en garantizar que los servicios ofrezcan transparencia y desempeño comprobable. Esto incluye ofrecer información clara sobre tiempos de respuesta, escalabilidad y seguridad para reducir el escepticismo. Desde una perspectiva práctica, la memoria con alcance específico facilita nuevos casos de uso en aplicaciones SaaS impulsadas por inteligencia artificial.

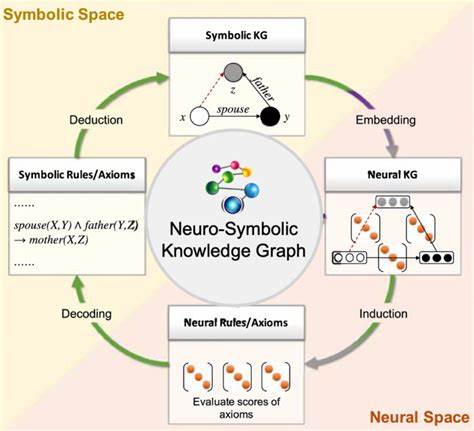

Por ejemplo, en plataformas de atención al cliente automática, esta memoria permite que el agente virtual recuerde interacciones pasadas y contexto relevante para ofrecer respuestas más naturales y coherentes. En aplicaciones de productividad, puede registrar preferencias y datos de proyecto para asistir mejor al usuario sin requerir constantes reingresos de información. En sectores sensibles como el financiero o el médico, asegurar que la información se maneje con alcance restringido y con expiración automática es esencial para proteger la privacidad y cumplir normativas. El futuro de esta tecnología apunta a una integración más profunda con sistemas de bases de datos vectoriales como Pinecone o Faiss, que especializan la búsqueda y recuperación eficiente de información mediante técnicas avanzadas de representación de datos. Sin embargo, todavía existe espacio para soluciones independientes y API-first que simplifiquen su uso para desarrolladores con distintos grados de experiencia técnica.

En suma, la memoria plug-and-play con alcance específico representa una pieza fundamental para la próxima generación de aplicaciones SaaS basadas en inteligencia artificial. Al ofrecer una funcionalidad crítica de retención y manejo de datos con flexibilidad, seguridad y simplicidad, estas soluciones pueden mejorar significativamente la interacción con el usuario y abrir la puerta a experiencias más personalizadas y eficientes. Como en cualquier innovación emergente, es importante que los interesados evalúen críticamente las opciones disponibles, soliciten transparencia sobre aspectos técnicos y de rendimiento, y consideren cómo estas herramientas pueden integrarse en sus flujos de trabajo sin comprometer la velocidad ni la seguridad. La evolución de la memoria para IA es un viaje que apenas comienza, pero promete transformar el panorama de las aplicaciones inteligentes en los años venideros.