En el floreciente mundo de la inteligencia artificial, los modelos de lenguaje grande (LLM) como GPT-4 han revolucionado la forma en que interactuamos con la tecnología y resolvemos problemas complejos. Una de sus capacidades más impresionantes es la programación automatizada o la asistencia en la codificación, funciones que admiten desde desarrolladores novatos hasta expertos en la creación de código eficiente y funcional. Sin embargo, surge una pregunta fundamental para quienes estudian el origen y el alcance de las habilidades de estos LLM: ¿qué porcentaje de su talento para la codificación proviene específicamente de los contenidos presentes en Stack Overflow? Esta plataforma, considerada el mayor repositorio de preguntas y respuestas sobre programación en el mundo, parece ser una fuente invaluable para el entrenamiento de los modelos, pero ¿qué tan decisiva es realmente para sus destrezas? Para comprender esta relación es necesario primero reconocer el papel que juega Stack Overflow en la comunidad tecnológica. Fundada en 2008, esta web se ha convertido en un punto de referencia indispensable para desarrolladores que enfrentan problemas específicos, buscan mejores prácticas y encuentran soluciones prácticas para lenguajes y herramientas variadas. Cada día millones de preguntas y respuestas contribuyen a formar un acervo de conocimiento técnico accesible para cualquier programador con conexión a internet.

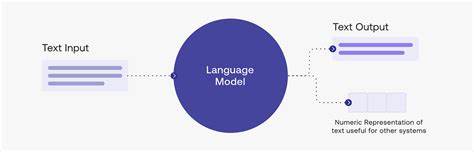

Los LLM se entrenan con voluminosos conjuntos de datos que incluyen, entre otras fuentes, repositorios de código abierto, documentación técnica, artículos, foros y por supuesto, plataformas como Stack Overflow. Este entrenamiento masivo les permite aprender patrones de lenguaje, lógica de programación, y sumar experiencias implícitas recogidas en los textos. Dado que muchas preguntas y respuestas en Stack Overflow son detalladas, contienen fragmentos de código bien explicados y soluciones a problemas comunes, forman un material valioso para que el modelo aprenda a resolver problemas concretos de programación. Aunque es difícil cuantificar con precisión qué porcentaje de las habilidades de un LLM provienen exclusivamente de Stack Overflow, muchos desarrolladores y expertos en inteligencia artificial coinciden en que es una fuente sustancial. Algunos usuarios han notado que las respuestas generadas por los LLM suelen ser muy similares a las que podrían encontrarse buscando en Stack Overflow, lo que indica que el modelo ha asimilado patrones y soluciones típicas presentes en esa comunidad.

Además, el estilo de explicación, la estructura del código y las recomendaciones específicas suelen reflejar el nivel y el rigor característicos de las mejores aportaciones en dicho sitio. La naturaleza colaborativa y actualizada de Stack Overflow también contribuye a que los LLM tengan acceso a soluciones modernas y probadas. A diferencia de los libros o documentación estática, esta plataforma reporta preguntas emergentes, errores comunes y soluciones novedosas que abarcan desde lenguajes tradicionales como Java o Python hasta tecnologías emergentes y frameworks recientes. Por ello, un modelo que ha sido entrenado en un conjunto de datos donde Stack Overflow es prominente está en capacidad de ofrecer respuestas que no solo son correctas sino también adaptadas a las tendencias y prácticas actuales. Por otro lado, aunque Stack Overflow tiene un peso importante, no es la única fuente crucial para que un LLM desarrolle sus habilidades en programación.

Los modelos también se nutren de repositorios públicos como GitHub, documentación oficial de lenguajes y herramientas, tutoriales, blogs especializados y otras plataformas de preguntas y respuestas. Esta variedad de fuentes permite que el modelo tenga un conocimiento amplio y diverso, capaz de generar código más robusto y resolver problemas más complejos. Surge además la cuestión de la calidad y el contexto de la información que se extrae de Stack Overflow. No todas las respuestas en la plataforma tienen la misma calidad o aplicabilidad, por lo que durante el proceso de entrenamiento, los modelos deben aprender a discernir entre soluciones óptimas y aquellas menos recomendables o desactualizadas. Este filtrado es complicado y a menudo depende del proceso de aprendizaje supervisado y ajustes realizados por los desarrolladores de la inteligencia artificial para mejorar la precisión y utilidad de las respuestas.

Este fenómeno tiene también implicaciones éticas y legales sobre el uso del contenido de Stack Overflow en entrenamiento de modelos de lenguaje. Algunos miembros de la comunidad han expresado preocupaciones acerca de los derechos de autor y el reconocimiento adecuado de los contribuyentes originales del código y las respuestas. Por ello, empresas dedicadas a la creación de LLM buscan cada vez más garantizar la transparencia, el cumplimiento de licencias y la atribución correcta de las fuentes. A nivel usuario, el impacto de la influencia de Stack Overflow en la codificación realizada por modelos de lenguaje es notable. La rapidez para recibir soluciones claras y probadas reduce grandes cantidades de tiempo en la búsqueda manual, fomenta el aprendizaje automático y facilita la integración de mejores prácticas.

En muchos casos, el LLM puede ofrecer sugerencias adicionales, correcciones o incluso explicar el código, imitando la experiencia de consultar a un desarrollador experimentado a través de la plataforma. Sin embargo, es importante que los desarrolladores que utilizan inteligencias artificiales para codificar mantengan una postura crítica y verifiquen las recomendaciones, dado que el modelo puede cometer errores o no capturar el contexto completo del problema. La contribución de Stack Overflow es significativa para el entrenamiento de estos modelos, pero la intervención humana sigue siendo esencial para asegurar la calidad y funcionalidad del código final. En conclusión, aunque no existe una cifra exacta que determine cuánto del coding skill de los modelos de lenguaje grande proviene específicamente de Stack Overflow, se puede asegurar que es una fuente fundamental dentro del vasto panorama de datos empleado para su entrenamiento. La riqueza, diversidad y actualización constante del contenido de esta plataforma tecnológica potencian la capacidad de los LLM para generar código útil y contextualizado.

Sin embargo, esta destreza se complementa con múltiples fuentes y un complejo proceso de aprendizaje que va más allá de un solo recurso. Así, Stack Overflow representa un pilar crucial en la consolidación de las habilidades de programación de la inteligencia artificial, contribuyendo a transformar la forma en que desarrollamos software y accedemos a soluciones técnicas en la era digital.