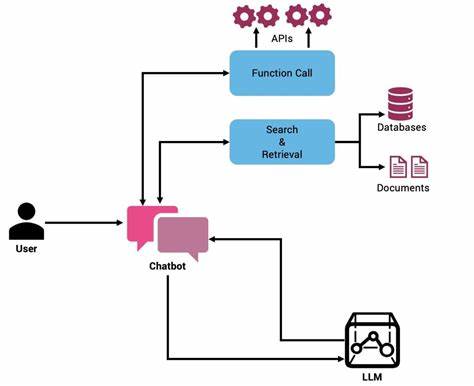

En el universo creciente de la inteligencia artificial, las capacidades de los Modelos de Lenguaje Grande (LLMs) como GPT han transformado la manera en que las aplicaciones entienden y procesan el lenguaje natural. Más allá de solo generar texto coherente, los LLMs ahora tienen la habilidad de interactuar con sistemas externos a través de un mecanismo llamado llamadas a funciones. Este avance abre un abanico inmenso de oportunidades para desarrollar agentes inteligentes capaces de ejecutar tareas complejas y personalizadas, mejorando así la experiencia del usuario y la eficiencia de los procesos tecnológicos. Las llamadas a funciones constituyen un puente entre la interpretación lingüística que realiza un LLM y la ejecución efectiva de procesos en aplicaciones externas. A diferencia de una simple generación textual, el modelo identifica la función precisa a invocar y los parámetros necesarios, que posteriormente son traducidos en una llamada estructurada y ejecutada por un sistema separado.

Esta separación garantiza que el LLM mantenga su papel de intérprete y orquestador, mientras que la ejecución real es manejada por componentes especializados del software, lo que incrementa la seguridad y control sobre las operaciones. Un ejemplo práctico para ilustrar esta metodología es el desarrollo de un agente de compras basado en inteligencia artificial capaz de ayudar a los usuarios a buscar productos y obtener detalles específicos. Cuando un usuario formula una consulta como “Estoy buscando una camisa azul” o “Muéstrame detalles del producto con ID p123”, el agente utiliza las llamadas a funciones para interpretar la solicitud, seleccionar la función adecuada y pasar los parámetros correctos. De esta forma, el agente puede realizar búsquedas, mostrar resultados o solicitar aclaraciones en caso de dudas, incrementando la precisión y relevancia del servicio que ofrece. La implementación técnica de este tipo de agentes se basa en definir un sistema estructurado de posibles acciones que el modelo puede realizar.

Estas acciones están representadas por clases que contienen métodos para ejecutar funcionalidades específicas, como buscar productos, obtener detalles o clarificar solicitudes. El núcleo del proceso consiste en que el modelo LLM, a partir del mensaje del usuario y el historial de conversación, decide la acción más adecuada y genera la estructura de la función a llamar en formato JSON. De esta manera, el programa deserializa esta estructura para instanciar la correspondiente clase y ejecutar la función. Un factor clave para el éxito en el uso de llamadas a funciones es diseñar prompts del sistema que guíen apropiadamente al LLM. Estos prompts deben definir con claridad el rol del agente, las funciones disponibles, cuándo utilizarlas y cuáles parámetros se esperan.

Esta orientación asegura que el modelo genere respuestas que no solo sean coherentes en lenguaje natural, sino también estructuradas para facilitar la ejecución automática de funciones. Técnicas como el one-shot o few-shot prompting, donde se incluyen ejemplos previos de interacción, pueden aumentar significativamente la precisión y relevancia en la identificación de intenciones y selección de funciones. La seguridad es un aspecto fundamental al desarrollar agentes que interactúan con usuarios mediante lenguaje natural. Existe el riesgo de que usuarios malintencionados intenten manipular el sistema con ataques de inyección de prompts para realizar acciones no autorizadas o acceder a información sensible. Por ello, es imprescindible implementar guardas como validaciones basadas en listas de patrones sospechosos o incluso utilizar otros modelos especializados para detectar intenciones maliciosas.

Además, restringir el espacio de acciones disponibles y evitar la ejecución dinámica de código mediante eval u otras funciones similares es crucial para preservar la integridad y estabilidad del sistema. Un elemento innovador en la integración de llamadas a funciones es el uso del Protocolo de Contexto del Modelo (MCP, por sus siglas en inglés). MCP propone un framework estandarizado para que las aplicaciones basadas en LLMs descubran y empleen herramientas de manera dinámica. Esto elimina la limitación de un conjunto fijo de funciones codificadas y permite que el agente consulte un servidor MCP para conocer las capacidades disponibles en tiempo de ejecución. Así, los agentes pueden adaptarse rápidamente a nuevas funcionalidades, mejorando su versatilidad y escalabilidad.

La arquitectura MCP se compone de tres componentes principales: el servidor MCP que expone las herramientas mediante API, el cliente MCP que gestiona la comunicación con el servidor y el host MCP que es la aplicación LLM que usa estas herramientas. Esta estructura modular potencia la extensión dinámica de capacidades sin necesidad de alterar el agente directamente, facilitando el mantenimiento y actualización en entornos productivos. En cuanto a la experiencia de desarrollo, refactorizar el código para minimizar duplicidades y mejorar la mantenibilidad es vital. Adoptar bibliotecas y marcos que permitan describir las acciones y sus parámetros como objetos Pydantic, por ejemplo, reduce el boilerplate y garantiza que las definiciones de las funciones estén sincronizadas con su implementación real. Esto además simplifica la serialización y deserialización de las llamadas a funciones, facilitando el manejo de la respuesta del modelo y la ejecución subsecuente.

Esta forma de trabajo supera algunos de los retos que presentan los motores de reglas tradicionales, que suelen ser complejos de mantener y propensos a interacciones imprevistas entre reglas. Los LLMs aportan una capa cognitiva que interpreta el contexto y modula sus respuestas de manera adaptativa, acercando la lógica empresarial a expresiones en lenguaje natural que pueden ser más comprensibles y manejables para expertos en dominio no técnicos. Los agentes basados en llamadas a funciones tienen un potencial significativo para diversas aplicaciones más allá de los asistentes de compras, incluyendo asistentes en entornos médicos, sistemas de soporte técnico, gestión de operaciones empresariales, y más. La capacidad de entender la intención del usuario y actuar sobre sistemas externos de forma segura y eficiente es una pieza clave para crear soluciones que potencien la productividad y mejoren la interacción humano-máquina. Finalmente, es importante destacar que aunque las llamadas a funciones con LLMs presentan beneficios claros, también demandan un enfoque cuidadoso en el diseño y la seguridad.

Implementar mecanismos robustos de control, monitoreo y validación asegurará que estas soluciones no solo sean innovadoras, sino también confiables y seguras para el uso masivo. La evolución de las tecnologías de inteligencia artificial hacia agentes cada vez más capaces y seguros marca un cambio paradigmático en el desarrollo de software. Las llamadas a funciones habilitan una colaboración más profunda entre humanos y máquinas, cimentando las bases para sistemas inteligentes que entienden contextos complejos y trabajan en sinergia con otras aplicaciones. En este camino, las empresas y desarrolladores que adopten estas metodologías se posicionarán a la vanguardia de la innovación tecnológica, proporcionando experiencias de usuario enriquecidas y soluciones adaptativas que responden al dinamismo del mercado y las necesidades de los usuarios.