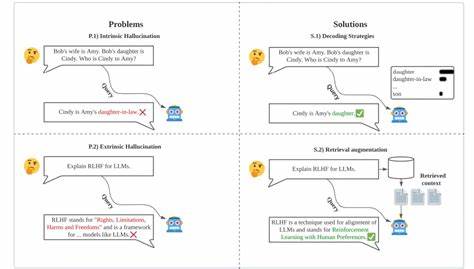

En el ámbito de la inteligencia artificial y el procesamiento del lenguaje natural, la eficiencia, precisión y escalabilidad de los modelos son aspectos cruciales que marcan diferencias notables en la experiencia y resultados. Recientemente, la versión Qwen3 ha irrumpido en el mercado con innovaciones significativas que mejoran el razonamiento, la capacidad de seguir instrucciones, funcionalidades de agente y, por supuesto, el soporte multilingüe. En este contexto, es fundamental comprender cómo ejecutar y afinar, o fine-tune, Qwen3 con el fin de optimizar su rendimiento y adaptabilidad a distintas aplicaciones. Qwen3 presenta una evolución destacada respecto a sus predecesores gracias a la integración de avanzadas metodologías de entrenamiento y optimización que permiten mantener la precisión aún en versiones cuantizadas del modelo. Esto significa que aunque se reduzca la precisión numérica para disminuir el tamaño y los requerimientos computacionales del modelo, no se sacrifica la calidad en las respuestas y predicciones generadas.

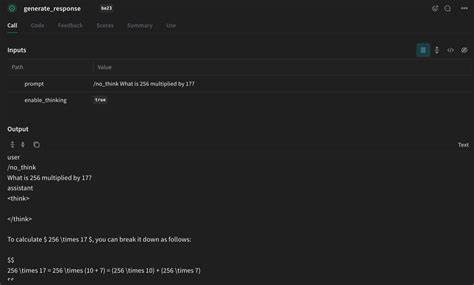

Una de las tecnologías clave que hace esto posible es la metodología Unsloth Dynamic 2.0. Unsloth ha aportado un valor revolucionario al ecosistema de modelos de inteligencia artificial con su tecnología Dynamic 2.0. Gracias a esta innovación, cualquier versión de Qwen3 puede ser ejecutada y afinada con un impacto mínimo en la precisión, incluso bajo configuraciones con sólo 4 bits para la representación de datos.

Esto asegura que los desarrolladores e investigadores puedan manejar modelos complejos sin requerir infraestructuras excesivamente costosas o inaccesibles. Uno de los hitos tecnológicos que más llama la atención es la capacidad para extender el contexto original de 40,000 tokens a un impresionante límite de 128,000 tokens mediante la implementación de YaRN. Esto implica que Qwen3 puede procesar entradas mucho más largas y complejas, lo cual es esencial para tareas que involucran documentos extensos, análisis detallados y contextos profundos sin perder coherencia ni detalle. La importancia de este salto en la longitud del contexto es relevante en multitud de sectores. Por ejemplo, en la investigación científica, en el análisis jurídico o en cualquier campo en el que se requiera manejar grandes volúmenes de texto acompañado de relaciones semánticas complejas.

Este aumento en el contexto abre un abanico notable de oportunidades para el desarrollo de soluciones más inteligentes y adaptativas. La capacidad para afinar Qwen3 ha sido otro foco central en la reciente actualización. A través de notebooks de Colab especialmente diseñados, los usuarios pueden llevar a cabo fine-tuning de versiones como Qwen3 (14B) y Qwen3 (8B) de manera más accesible. El entorno Unsloth facilita esta tarea de afinación no sólo acelerando el proceso hasta en dos veces, sino que también reduce el consumo de VRAM hasta en un 70%. Esto es crucial para hacer viable este proceso incluso en hardware con recursos limitados, amplificando su accesibilidad en comunidades y empresas pequeñas o medianas.

Además, la tecnología Flash Attention 2 incorpora mejoras en la gestión de memoria y velocidad durante el entrenamiento y la inferencia, permitiendo que los modelos trabajen con contextos 8 veces más largos que en ambientes tradicionales. En conjunto, estos avances ofrecen una solución que combina eficiencia, escalabilidad y alta precisión. Entender cómo interactuar con la librería UnsloTh es un prerrequisito para sacar el máximo provecho de estos beneficios. Esta herramienta soporta un espectro extremadamente amplio de modelos transformadores, incluyendo modelos orientados al razonamiento como Phi-4, Mixtral, y modelos de expertos múltiples (MOE) como Qwen3-30B-A3B y Qwen3-235B-A22B. Asimismo, permite la implementación de algoritmos de entrenamiento avanzados como GRPO y el uso con modelos de lenguaje visuales (VLMs), ampliando la versatilidad aplicada.

Es importante recalcar que cualquier usuario interesado en afinar Qwen3 debe asegurarse de contar con la última versión de UnsloTh para evitar problemas de compatibilidad y garantizar el mejor rendimiento. La instalación y actualización se puede realizar fácilmente con commandes de pip que aseguran un entorno limpio y actualizado. La implementación práctica y demostrativa de fine-tuning con datasets ampliamente reconocidos, como Alpaca, asegura que las pruebas de rendimiento y capacidad del modelo estén alineadas con los estándares actuales en la comunidad de inteligencia artificial. El uso de técnicas como QLoRA en todas las capas lineales del transformador optimiza el ajuste, permitiendo un balance ideal entre memoria, velocidad y precisión. En la práctica, Qwen3 ha demostrado poder operar sin dificultades en GPUs con VRAM moderadas, por ejemplo, el modelo Qwen3-30B puede funcionar perfectamente en 24 GB de memoria, haciéndolo accesible para muchos laboratorios de investigación e incluso empresas medianas que no cuentan con infraestructura de última generación.

Este avance es especialmente relevante porque anteriormente grandes modelos de esta escala requerían dispositivos con capacidades mucho mayores, dificultando su adopción masiva y ralentizando el desarrollo de nuevas aplicaciones basadas en lenguaje natural. Otra ventaja clara se encuentra en la comunidad de desarrollo e investigación que sostiene a Qwen3 y UnsloTh. La colaboración directa con el equipo original de Qwen ha permitido que la implementación sea robusta, confiable y esté acompañada de una documentación clara y efectiva, que favorece la curva de aprendizaje para nuevos usuarios. La presencia activa en redes sociales, canales de Discord, Reddit y newsletters mantiene informado a los usuarios sobre las novedades, mejores prácticas y nuevos desarrollos, generando un entorno de apoyo constante y crecimiento colectivo. Por último, para quienes desean experimentar con Qwen3 de forma gratuita o sin grandes compromisos, existen opciones accesibles que permiten la ejecución y afinación del modelo con recursos limitados, facilitando la exploración de capacidades y la integración en proyectos específicos o entornos experimentales.

En resumen, la combinación entre el modelo Qwen3 y la tecnología Unsloth Dynamic 2.0 representa un salto importante en la evolución de modelos de lenguaje. Su capacidad de manejar contextos extensos, eficiencia en la gestión de memoria, rapidez en la afinación y soporte a una amplia gama de arquitecturas y algoritmos colocan a esta solución a la vanguardia del procesamiento de lenguaje natural. De esta forma, se abren puertas para innovaciones en múltiples sectores que demandan inteligencia artificial más poderosa, flexible y eficiente. A medida que la comunidad continúa explorando estos avances, es probable que veamos una proliferación de aplicaciones sorprendentes, desde asistentes virtuales más conversacionales y contextualmente conscientes hasta sistemas avanzados de análisis de datos y generación de contenido.

La clave para aprovechar todo este potencial será dominar las herramientas adecuadas, y Unsloth junto a Qwen3 ofrecen precisamente este camino accesible y potente para investigadores, desarrolladores y empresas.