En la era digital actual, el uso de teléfonos inteligentes entre los niños se ha convertido en un fenómeno prácticamente universal. Para muchos padres y educadores, la preocupación principal ha sido durante mucho tiempo la cantidad de tiempo que los niños pasan frente a las pantallas. Sin embargo, esta visión, aunque importante, deja de lado un aspecto mucho más crítico y menos visible: la influencia de los algoritmos que gobiernan estas plataformas y cómo impactan en el bienestar de los menores. Los teléfonos inteligentes, en sí mismos, son herramientas neutrales que ofrecen múltiples beneficios. A través de ellos, los niños pueden acceder a recursos educativos, cultivar habilidades creativas, comunicarse con sus seres queridos y explorar nuevas formas de entretenimiento.

La preocupación con respecto a un uso excesivo de hardware o la duración frente a la pantalla tiene su lugar, pero no es la amenaza más profunda ni urgente. Lo que realmente pone en riesgo a los niños no es el dispositivo, sino el software que utilizan, especialmente las redes sociales y las aplicaciones diseñadas para captar y mantener su atención a través de algoritmos complejos y sofisticados. Estos algoritmos están diseñados para maximizar el tiempo de interacción del usuario, alimentando contenido que provoca emociones intensas, fomenta la adicción y, en casos alarmantes, puede fomentar conductas tóxicas como el acoso, la ansiedad o la depresión. Estudios recientes, incluyendo los de investigadores destacados como Jonathan Haidt, evidencian que las plataformas como TikTok, Instagram, Facebook y Twitter representan riesgos significativos para los jóvenes; no existe un nivel seguro de uso para ellos. Estas plataformas no solo muestran contenido adecuado o inofensivo, sino que su funcionamiento mismo prioriza la difusión de material que genera respuestas emocionales fuertes, lo que puede empujar a los niños hacia dinámicas perjudiciales para su salud mental y desarrollo social.

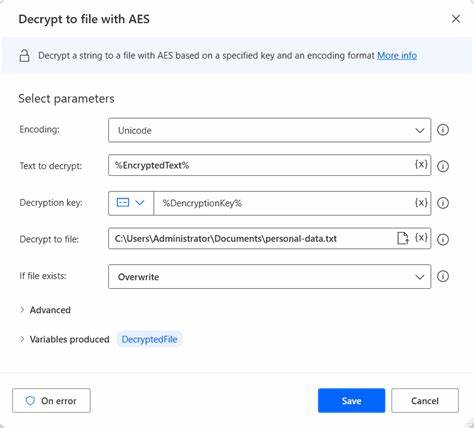

Lo paradójico es que las mismas empresas que desarrollan estas plataformas cuentan con tecnologías de inteligencia artificial avanzadas capaces de determinar con precisión quiénes son los usuarios, sus edades y sus patrones de comportamiento. Sin embargo, a pesar de poseer el conocimiento y los recursos técnicos para proteger a los usuarios más vulnerables, el interés principal permanece en aumentar el número de usuarios activos y maximizar la participación, impulsados por la necesidad de generar ingresos publicitarios. Este modelo de negocio ha llevado a una situación donde se minimizan o ignoran las soluciones tecnológicas que podrían limitar el acceso de menores a contenido dañino o evitar la propagación de comportamientos abusivos. La consecuencia es un ambiente digital donde los niños quedan expuestos a riesgos que, en el mundo físico, serían inaceptables y sujetos a posibles acciones legales. Una solución concreta y prometedora a este problema consiste en implementar sistemas de verificación de identidad y edad en las redes sociales, similares a los procedimientos conocidos como KYC (Conozca a su Cliente) y AML (Anti-Lavado de Dinero), utilizados en el sector financiero.

Este método no requiere que los usuarios divulguen su identidad públicamente, sino que las plataformas puedan confirmar con certeza que sus usuarios son quienes dicen ser y que cumplen con los requisitos de edad establecidos. La incorporación de un servicio independiente de verificación de identidad con un fuerte marco de protección criptográfica podría equilibrar la necesidad de privacidad con la responsabilidad. De esta forma, las plataformas podrían restringir el acceso a aquellos que estén legalmente autorizados, responsabilizar a quienes generen contenido tóxico o ilegal y combatir eficazmente el uso de bots anónimos que manipulan la opinión pública y generan desinformación. Además, esta estrategia permitiría una regulación proporcional, aplicada solo a las plataformas que superen ciertos umbrales de usuarios activos, evitando así asfixiar la innovación en sitios más pequeños y promoviendo la diversidad en el ecosistema digital. Una supervisión adecuada también garantizaría que las conductas ilegales en línea puedan ser perseguidas con la misma firmeza que en el mundo real, cerrando la brecha entre la conducta online y las responsabilidades civiles y penales offline.

Más allá de la implementación técnica, el verdadero reto que enfrentamos es la voluntad política y social para exigir responsabilidad a las empresas tecnológicas. Mientras estas compañías antepongan sus beneficios económicos a la protección de los usuarios más jóvenes, seguiremos viendo un aumento en los daños colaterales que afectan a niños y adolescentes. No se trata solo de limitar el tiempo que los niños pasan con sus teléfonos inteligentes, sino de establecer un entorno digital saludable, seguro y transparente. Solo así podremos garantizar que la tecnología sea una aliada en el desarrollo y bienestar de las nuevas generaciones, y no una fuente de peligro invisible e insidioso. En conclusión, el debate sobre niños y teléfonos inteligentes debe cambiar de enfoque.

El verdadero problema no es cuánto tiempo pasan los menores frente a una pantalla, sino cómo los algoritmos dentro de las plataformas sociales controlan y manipulan sus experiencias digitales. Para proteger a nuestros niños, es necesario exigir regulaciones que obliguen a las empresas a implementar sistemas de verificación que permitan un uso responsable y seguro, combinados con una vigilancia legal que asegure consecuencias para los comportamientos tóxicos. Solo con voluntad política y compromiso social se podrá revertir el daño y construir un futuro digital más sano para todos.