En la era digital actual, los Modelos de Lenguaje Grandes, conocidos como LLMs por sus siglas en inglés, han capturado una atención significativa en el ámbito tecnológico y más allá. Estos modelos, como GPT de OpenAI, han revolucionado la forma en que interactuamos con las máquinas, desafiando percepciones antiguas sobre lo que significa la inteligencia artificial. Sin embargo, una pregunta recurrente en debates técnicos y populares es si realmente estos modelos son más que simples sistemas de autocompletado avanzados. ¿Son meras herramientas que predicen la siguiente palabra por probabilidad, o están evolucionando hacia capacidades de comprensión y razonamiento más profundas? Este tema no solo despierta interés en la comunidad científica, sino que también plantea implicaciones trascendentales para aplicaciones futuras, ética y la relación humano-máquina. Para entender este debate, primero es crucial comprender qué son los LLMs y cómo funcionan.

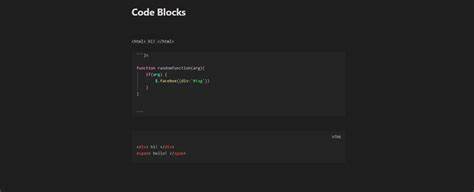

En esencia, estos modelos se entrenan usando vastos conjuntos de datos textuales, desde libros y artículos hasta conversaciones y programas de código. A través de técnicas avanzadas de aprendizaje automático y modelos neuronales, aprenden patrones, contextos y relaciones lingüísticas extremadamente complejas. Cuando se les solicita generar texto, el modelo calcula cuál es la palabra o secuencia más probable que siga a partir del contexto dado. Esta habilidad es la base para compararlos con sistemas de autocompletado que vemos en teléfonos o procesadores de texto. Sin embargo, a diferencia de estos sistemas más simples, los LLMs manejan una enorme cantidad de variables y matices, pudiendo generar respuestas coherentes, creativas y hasta emotivas.

Un argumento frecuente de quienes consideran que los LLMs son solo un autocompletado sofisticado se basa en la idea de que no poseen verdadera comprensión. Para ellos, el modelo no «entiende» el contenido, sino que simplemente replica patrones aprendidos sin conexión a una realidad o experiencia. Desde esta perspectiva, todo lo que genera es, en última instancia, un cálculo estadístico de cuál es la palabra o frase probable sin un conocimiento genuino o intención detrás. Esto abre preocupación sobre la autenticidad de la información generada, ya que pueden ocurrir errores, sesgos y malinterpretaciones, además de generar contenido convincente pero falso. Sin embargo, otro grupo dentro del debate sostiene que este punto de vista subestima la complejidad y el impacto funcional de los LLMs.

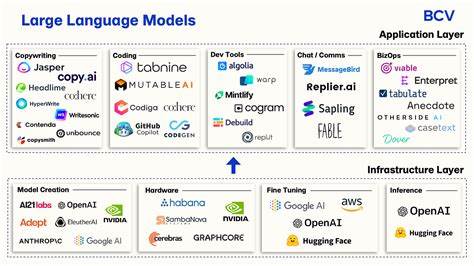

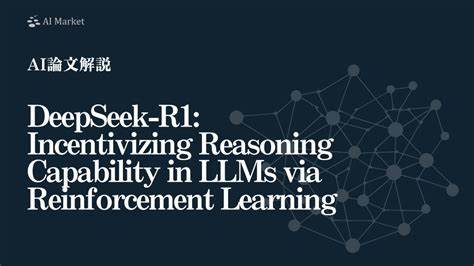

Aunque no poseen conciencia ni entendimiento humano, la capacidad de procesar contextos extensos, inferir relaciones complejas entre conceptos y responder a preguntas específicas los posiciona mucho más allá de una simple función de autocompletado. Su habilidad para redactar textos detallados y coherentes, resolver problemas, traducir lenguas e incluso participar en conversaciones naturales los acerca a una forma emergente de inteligencia artificial. Además, su uso en ámbitos profesionales desde la medicina hasta la educación demuestra que no son solo herramientas para completar frases, sino asistentes cognitivos potentes que impulsan la productividad y creatividad. Esta dicotomía también abre una reflexión importante sobre cómo definimos la inteligencia artificial. Si entendemos la inteligencia como la capacidad de realizar tareas que requieren razonamiento, aprendizaje, adaptación y comunicación, los LLMs cumplen un rol destacado.

No obstante, si la inteligencia se liga exclusivamente a la autoconciencia o a la comprensión profunda del mundo, entonces los LLMs aún no alcanzan ese nivel. La cuestión radica en que la evolución tecnológica actual desafía las categorías tradicionales, forzándonos a repensar nuestras definiciones para integrar nuevas formas de inteligencia emergente. Un aspecto central del debate es el impacto que tienen estos modelos en la sociedad y en el desarrollo de sistemas futuros. Su potencial para crear contenido original, asistir en investigaciones científicas y facilitar la comprensión multicultural es innegable. Sin embargo, la dependencia indiscriminada puede traer riesgos como la desinformación, la pérdida de habilidades humanas y cuestiones éticas relacionadas con la autoría y la responsabilidad.

Este equilibrio requiere un análisis prudente y la implementación de regulaciones y controles adecuados para que los beneficios superen los posibles perjuicios. Además, el diseño y entrenamiento de los LLMs continúa en rápida evolución, incorporando mejoras para reducir sesgos, aumentar la coherencia y perfeccionar la capacidad de contextualización. Investigaciones recientes exploran la integración de sistemas híbridos que combinan razonamiento simbólico con aprendizaje estadístico, buscando superar las limitaciones actuales y acercarse a una inteligencia artificial más robusta y precisa. En este sentido, los LLMs no son un punto final, sino una etapa avanzada en el desarrollo de tecnologías cognitivas. En conclusión, si bien puede ser tentador simplificar los Modelos de Lenguaje Grandes como sistemas de autocompletado avanzados, la realidad es mucho más compleja y matizada.

Presentan capacidades que van mucho más allá de la simple predicción estadística de palabras, tocando aspectos fundamentales de la comunicación, el conocimiento y la creatividad humana. El debate continúa abierto, impulsado por avances tecnológicos constantes y la necesidad de una comprensión más profunda de lo que implica la inteligencia artificial. En última instancia, reconocer tanto las potencialidades como las limitaciones de los LLMs es clave para aprovechar su valor y construir un futuro donde humanos y máquinas colaboren de manera ética y efectiva.