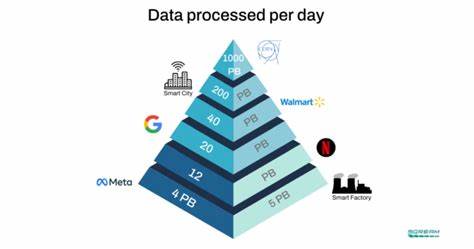

En el mundo del análisis de datos y del monitoreo de sistemas, el manejo eficiente de grandes volúmenes de logs es fundamental para mantener la integridad y el rendimiento de aplicaciones y plataformas digitales. Loki, un sistema de gestión de logs altamente escalable y eficiente desarrollado por Grafana Labs, ha ganado popularidad por su capacidad para indexar y consultar registros con un coste relativamente bajo. Sin embargo, a medida que las empresas y proyectos crecen, la demanda de consultas a nivel petabyte sobrellevó importantes desafíos que requerían una evolución significativa en la arquitectura y capacidad del sistema. En este sentido, una mejora innovadora que soportara consultas de logs a escala petabyte fue vital para cubrir las crecientes necesidades de almacenamiento y procesamiento. El proceso de mejora implicó una serie de pasos técnicos y conceptuales destinados a optimizar la rapidez, precisión y escalabilidad del sistema Loki sin sacrificar la facilidad de uso y los recursos computacionales.

Uno de los primeros aspectos abordados fue la integridad y eficiencia del almacenamiento. Trabajar con datos a tamaño petabyte requiere una estructura de almacenamiento distribuida y tolerante a fallos, capaz de manejar inserciones masivas sin generar cuellos de botella. Para esto, se implementaron mejoras en el backend que permitieron una distribución más inteligente de datos, aprovechando arquitecturas basadas en la fragmentación y replicación que aseguran alta disponibilidad y durabilidad. Paralelamente, la optimización de índices fue crucial. Dado que Loki originalmente utiliza un índice invertido limitado para etiquetas de logs, gestionar consultas en volúmenes extremadamente altos demandaba un re-dimensionamiento y una revisión profunda del sistema de indexación.

Se incorporaron técnicas avanzadas de compresión y almacenamiento en memoria, así como algoritmos de búsqueda adaptativos que pueden filtrar y acceder a datos relevantes sin la necesidad de recorrer extensos conjuntos completos. Además, con la finalidad de acelerar el tiempo de respuesta de las consultas, se emplearon mecanismos de caché inteligente que almacenan patrones frecuentes de consultas, permitiendo reducir los tiempos de procesamiento para solicitudes recurrentes y mejorar la experiencia del usuario en tiempo real. El manejo eficiente del paralelismo y la concurrencia fue otro foco central en la mejora de Loki. Se desarrollaron estrategias que permitieron dividir las queries en tareas independientes que se ejecutan simultáneamente en múltiples núcleos o clusters, generando un procesamiento paralelo que acorta significativamente los tiempos de respuesta incluso con cargas elevadas. Esta paralelización también ayuda en la mitigación de cuellos de botella que suelen ocurrir en sistemas centralizados cuando se enfrenta a extensas operaciones de lectura y escritura.

Por supuesto, la infraestructura subyacente también jugó un papel determinante. La adopción de soluciones de almacenamiento en la nube con escalabilidad dinámica garantizó que el sistema pueda crecer horizontalmente según la demanda, sin necesidad de interrupciones o migraciones costosas. Además, la integración con servicios de computación escalables y balanceadores de carga inteligentes permitió aprovechar recursos temporales para consultas específicas, aumentando la eficiencia y reduciendo costos operativos. En cuanto al aspecto de interoperabilidad, las mejoras aseguraron que Loki pueda integrarse fluidamente con las plataformas y herramientas existentes de monitoreo y análisis como Grafana, Prometheus y otros sistemas de alertas, manteniendo compatibilidad y seguridad, lo cual es vital para la adopción en entornos empresariales y de producción. También se implementaron protocolos de seguridad reforzados y auditorías en tiempo real para proteger los datos sensibles y cumplir con normativas vigentes, brindando a los administradores confianza ante posibles vulnerabilidades o accesos no autorizados.

Las optimizaciones no solo permitieron manejar grandes volúmenes de datos, sino que también facilitaron la visualización y análisis de patrones, anomalías y tendencias en tiempo real, aportando valor agregado para la toma de decisiones rápidas en entornos de alta complejidad y dinámicos. Finalmente, los resultados de estas mejoras fueron contundentes con una significativa reducción en el tiempo de las consultas a petabytes de logs y un consumo de recursos más eficiente, lo cual transformó a Loki en una herramienta más poderosa y adecuada para las necesidades actuales del ecosistema tecnológico. Este caso de éxito también abre la puerta para futuras innovaciones y la posibilidad de seguir escalando los sistemas de monitoreo a niveles aún mayores, impulsando la evolución del campo del análisis de datos en la era del Big Data.