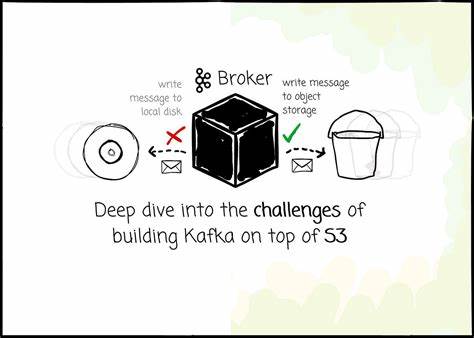

Apache Kafka ha revolucionado el mundo del procesamiento de datos en tiempo real, convirtiéndose en el estándar para sistemas de mensajería distribuida en múltiples industrias. Diseñado inicialmente para centros de datos locales, Kafka enfrenta diversos retos al migrar a entornos cloud modernos, especialmente cuando se intenta desacoplar el almacenamiento del cómputo. El almacenamiento en objeto, representado por servicios como Amazon S3, ofrece una alternativa económica y escalable, pero adaptar Kafka para funcionar sobre este tipo de almacenamiento presenta múltiples desafíos técnicos. Comprender estas dificultades y cómo algunas soluciones innovadoras, como AutoMQ, afrontan dichos retos es esencial para cualquier profesional que trabaje con arquitecturas distribuidas en la nube. El principal motivo para buscar almacenar los datos de Kafka en S3 es la eficiencia en costos y escalabilidad.

Kafka une de manera intrínseca el almacenamiento y el cómputo, por lo que ampliar la capacidad de almacenamiento requiere añadir más nodos, lo que a menudo deriva en infrautilización de recursos. Además, el diseño original de Kafka se basa en la replicación entre nodos para mantener la durabilidad y alta disponibilidad, lo que en un entorno multi-Availability Zone (AZ) en la nube puede disparar los costos relacionados con el tráfico entre zonas debido a la escritura de mensajes en el líder y su replicación a seguidores. Al alojar los datos en un almacenamiento de objetos como S3, es posible separar la escalabilidad del cómputo y almacenamiento, evitar duplicar datos entre nodos y aprovechar la durabilidad que ofrece el propio almacenamiento. Pero este enfoque requiere una reingeniería profunda de los mecanismos internos de Kafka, que fueron diseñados para operar sobre sistemas de archivos locales y almacenamiento persistente en disco. Uno de los mayores inconvenientes para construir Kafka sobre S3 es la latencia inherente del almacenamiento en objeto.

Mientras que el acceso a un almacenamiento de estado sólido local tiene tiempos de microsegundos, la latencia promedio de una operación GetObject en S3 se sitúa en el rango de decenas de milisegundos. Para aplicaciones que requieren alta velocidad de ingestión y baja latencia, esta diferencia representa un desafío considerable que debe ser mitigado para garantizar un rendimiento aceptable. Algunas soluciones apuestan por sacrificar la latencia a cambio de una reducción significativa en costos y una arquitectura simplificada. Por ejemplo, sistemas como WarpStream o Bufstream esperan a que los mensajes se persistan en S3 antes de confirmar la recepción al productor, lo que puede incrementar la latencia general. En cambio, AutoMQ introduce una arquitectura híbrida con un registro de escritura adelantada (write-ahead-log, WAL) en almacenamiento EBS o incluso S3 como WAL, que permite tener un compromiso entre latencia y costo.

Primero se escribe el mensaje en un WAL rápido y local para obtener baja latencia, y luego se replica de forma asíncrona a S3, logrando así mantener una latencia de escritura muy baja para el productor y una durabilidad a largo plazo en S3. El conteo alto de operaciones de IOPS (operaciones de entrada/salida por segundo) es otro reto, ya que S3 cobra por cada solicitud PUT realizada. Servicios con miles o decenas de miles de escrituras por segundo pueden incurrir en costos enormes si no se implementa un mecanismo eficiente de agrupación de datos. Para abordarlo, las soluciones acumulan mensajes en buffers de memoria antes de subirlos en bloques más grandes a S3, reduciendo el número total de solicitudes. No obstante, esta técnica introduce un trade-off entre latencia y costos: buffers más grandes reducen costos pero aumentan latencia, mientras que buffers reducidos disminuyen la latencia a costa de mayores costos.

Un efecto colateral de la agrupación de datos es el fraccionamiento de la información de una misma partición en múltiples objetos, lo que complica las lecturas secuenciales con alto rendimiento. Para enfrentar este problema, herramientas como AutoMQ implementan procesos de compactación en segundo plano que consolidan múltiples objetos pequeños en menos entidades grandes, permitiendo lecturas secuenciales más eficientes y mejorando la gestión de la metadata relacionada. La gestión de la caché es fundamental para mejorar el rendimiento sobre almacenamiento en objeto. Caching disminuye la cantidad de solicitudes GET a S3 y mejora la experiencia de lectura para datos recientes y antiguos. Por ejemplo, AutoMQ utiliza un sistema de doble caché: una caché para logs que contiene los datos recientes y otra de bloques que almacena datos históricos.

La combinación de técnicas como la precarga (prefetching) y la lectura en lotes maximiza las probabilidades de éxito al leer desde caché y minimiza las llamadas a S3, optimizando la latencia y los costos. La metadata también adquiere un papel más complejo al operar con almacenamiento en objetos. Kafka tradicionalmente usa el sistema de archivos y una estructura en ZooKeeper o Kraft para almacenar información sobre particiones, segmentos y estado del clúster. En S3, el uso de operaciones LIST resulta costoso y lento, por lo que las soluciones están obligadas a almacenar y mantener metadata adicional para saber qué objetos contienen qué datos y cómo asegurar el orden correcto de lectura. Compactar objetos contribuye a mantener esta metadata manejable y eficiente.

AutoMQ, por ejemplo, aprovecha Kraft para mantener la metadata del clúster replicada en los nodos y utiliza estructuras propias que mapean segmentos a streams en S3, para evitar operaciones LIST frecuentes. Mantener la compatibilidad total con Kafka es crucial para facilitar la adopción, permitiendo que los usuarios migren sin tener que cambiar sus clientes o dependencias. Esta compatibilidad se ve amenazada por la arquitectura fundamentalmente diferente del almacenamiento en objeto frente al almacenamiento en disco local al que Kafka está acostumbrado. Mientras algunas plataformas optan por reescribir completamente el protocolo Kafka para adaptarse a las características del almacenamiento en objeto, como WarpStream o Bufstream, AutoMQ opta por reutilizar el protocolo de Kafka y reimplementar únicamente la capa de almacenamiento. Este enfoque es más complejo, pero garantiza una compatibilidad del 100% y permite seguir integrando futuras actualizaciones del ecosistema Kafka.

La arquitectura interna de Kafka se basa en elementos como ReplicaManager para la gestión de particiones y mensajes, y en una granularidad de almacenamiento segmentado que facilita procesos como compactación, recuperación de logs y gestión de índices de transacciones y tiempos. AutoMQ conserva estas abstracciones mediante la creación de flujos de datos (streams) que representan objetos almacenados en S3, reproduciendo la funcionalidad de segmentos físicos pero adaptada a las particularidades del almacenamiento en objeto. Otra problemática relevante es el costo y la gestión eficiente del tráfico entre zonas de disponibilidad. Kafka tradicionalmente genera mucho tráfico interzonas porque los productores deben enviar mensajes al líder de partición, que puede estar en una zona diferente, y porque la replicación entre nodos de diferentes zonas implica transferencia de datos costosa. Al usar S3, el costo de replicación se elimina, ya que el almacenamiento se encarga de la durabilidad y replicación internamente.

Sin embargo, el problema persiste en la comunicación entre productores y líderes cuando estos están en diferentes zonas. Para minimizar este gasto, AutoMQ implementa un mecanismo innovador donde las solicitudes de productores se redirigen a un nodo broker ubicado en la misma zona que el productor. Este nodo actúa como intermediario, almacenando temporalmente los mensajes en un WAL ubicado en S3 o en un almacenamiento local de baja latencia, y luego comunica estos mensajes al nodo líder responsable de la partición. Esto reduce significativamente el tráfico interzona directo y, por ende, los costos asociados. La gestión del ancho de banda y la priorización de distintos tipos de tráfico (envío de mensajes, consuntes en tiempo real, lecturas históricas y procesos de compactación) es clave para mantener un rendimiento óptimo.

AutoMQ implementa un sistema avanzado de limitación y encolamiento basado en un algoritmo token bucket y colas de prioridad que aseguran que los mensajes en tiempo real tengan prioridad máxima, mientras que procesos intensivos como la compactación se regulan para no impactar negativamente la experiencia de los clientes. La convergencia entre arquitecturas compartidas pero independientes (shared nothing y shared disk) constituye un balance delicado. Kafka se diseñó siguiendo un modelo shared nothing que aprovecha la localización de datos para agilizar operaciones, pero almacenar los datos en S3 implica un modelo más cercano al shared disk con acceso global. AutoMQ intenta preservar la propiedad de localización de datos segmentando brokers y particiones, con efecto directo en la gestión de caché y la reducción de comunicaciones cruzadas. Finalmente, construir Kafka sobre un almacenamiento totalmente desacoplado como S3 abre una era prometedora para sistemas distribuidos en la nube, permitiendo disfrutar de los beneficios de escalabilidad y reducción de costos, siempre que se superen los retos de latencia, manejo de metadata, compatibilidad y patrones de tráfico.

Mientras distintas soluciones experimentan con diversas arquitecturas, AutoMQ representa un interesante enfoque que combina el respeto por el diseño original de Kafka con las posibilidades que generan los entornos cloud actuales. En conclusión, el futuro de las plataformas de streaming y mensajería en la nube estará marcado por estas adaptaciones profundas en el almacenamiento. Entender los desafíos y las estrategias para construir Kafka sobre S3 es vital para diseñar arquitecturas robustas, escalables y económicas que soporten las demandas masivas de datos en tiempo real que el mundo digital moderno exige. Al seguir desarrollos y proyectos como AutoMQ, la comunidad puede vislumbrar modelos híbridos y tecnologías cada vez más maduras que consolidarán la transición efectiva entre sistemas tradicionales y nativos en la nube.