Los sistemas de inteligencia artificial (IA) agentic representan una evolución significativa en la tecnología, dotando a las máquinas de capacidades para actuar y tomar decisiones autónomas con diversos grados de agenciamiento. Estos sistemas están diseñados para operar con un nivel considerable de independencia, ejecutando tareas complejas que antes dependían exclusivamente del juicio humano. Sin embargo, a medida que estas tecnologías avanzan, es crucial entender los diferentes modos de fallo que pueden afectar su rendimiento, seguridad y confiabilidad. Este entendimiento es esencial para garantizar que estos agentes de IA funcionen dentro de parámetros seguros y éticos, minimizando riesgos y maximizando beneficios. Los modos de fallo en sistemas IA agentic se manifiestan de múltiples formas y pueden surgir debido a distintas causas, incluidas vulnerabilidades inherentes a su arquitectura, ataques externos o limitaciones en el diseño y la capacidad del modelo de aprendizaje.

La complejidad intrínseca de estos sistemas deriva de la interacción entre módulos de toma de decisiones autónomas, aprendizaje continuo y adaptación a entornos dinámicos. Cualquier incongruencia, error o manipulación en estas fases puede disparar un fallo que comprometa la integridad del sistema. Una categoría fundamental dentro de esta clasificación son los modos de fallo de seguridad. Estos incluyen desde ataques intencionados hasta errores que permiten brechas de acceso no autorizadas o manipulaciones del sistema. Por ejemplo, un ataque de envenenamiento de memoria puede corromper la base de datos o el historial que utiliza la IA para tomar decisiones, generando resultados sesgados o inapropiados.

Tales ataques demuestran cómo la seguridad debe ser una prioridad absoluta en el diseño y mantenimiento de cualquier sistema agentic para evitar consecuencias potencialmente catastróficas. No menos importantes son los modos de fallo relacionados con la seguridad operacional y la integridad funcional. Estos pueden surgir por defectos en la programación, errores en la interpretación de objetivos o conflictos entre diferentes módulos del agente. La ausencia de una supervisión humana adecuada o mecanismos de contingencia puede permitir que un agente continúe operando bajo parámetros erróneos, creando riesgos para usuarios y sistemas colaterales. Además de los problemas de seguridad, la seguridad ética y la alineación de objetivos constituyen otra dimensión crítica en la taxonomía de fallos.

Cuando un agente de IA toma decisiones autónomas, es imprescindible que los objetivos perseguidos estén alineados con los valores humanos y las normativas éticas. Los malfuncionamientos en esta área pueden derivar en comportamiento inesperado, sesgos discriminatorios o impactos negativos sobre comunidades vulnerables. La implementación de protocolos de evaluación ética y auditorías continuas son esenciales para mitigar estos riesgos. El diseño de mitigaciones efectivas debe ser multidimensional, considerando tanto aspectos técnicos como sociales y éticos. Desde un enfoque técnico, es importante incorporar sistemas de monitoreo constantes que detecten anomalías o desviaciones respecto al comportamiento esperado del agente.

También se requiere el desarrollo de modelos de aprendizaje robustos ante manipulaciones externas y que puedan adaptarse de forma segura a cambios en el entorno operativo. Por otro lado, el factor humano sigue siendo una parte indispensable del ecosistema de la IA agentic. La colaboración entre expertos en IA, ingenieros de seguridad, reguladores y usuarios finales es clave para implementar barreras efectivas contra fallos y ataques. Además, las políticas regulatorias deben evolucionar para anticipar nuevas vulnerabilidades y garantizar transparencia en el desarrollo y despliegue de estos sistemas. Un caso paradigmático para ilustrar estos puntos es el ataque de envenenamiento de memoria en asistentes de correo electrónico basados en agentes IA.

En este escenario, la manipulación deliberada de la información almacenada por el asistente provoca que interprete mal las intenciones del usuario, genere mensajes inapropiados o filtre información confidencial. Las observaciones del ataque revelaron la necesidad de fortalecer las defensas contra modificaciones maliciosas del historial y mejorar la capacidad del sistema para detectar incoherencias. Este tipo de ataques también expone la importancia de un ciclo de vida del software bien gestionado, que incluye actualizaciones periódicas, validaciones de integridad y auditorías de comportamiento. Sin estos procesos, los sistemas agentic pueden quedar expuestos durante largos periodos a exploits que comprometan sus funcionalidades. En cuanto a las limitaciones del análisis actual de fallos en IA agentic, es necesario reconocer que la rápida evolución de la tecnología plantea desafíos constantes para la categorización exhaustiva de todos los posibles modos de fallo.

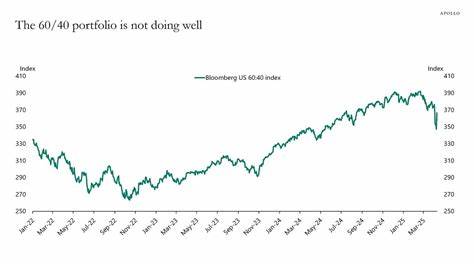

La adaptación de sistemas a nuevos contextos, la incorporación de modelos de aprendizaje más complejos y la interacción con entornos cada vez más dinámicos pueden originar fallos que aún no están documentados o comprendidos plenamente. Por esta razón, la comunidad de investigadores y profesionales debe mantener un enfoque proactivo en la actualización de taxonomías y la identificación temprana de nuevas vulnerabilidades. La transparencia en la divulgación de incidentes y el intercambio de conocimiento entre los distintos actores contribuirán a fortalecer la resiliencia de sistemas agentic en el largo plazo. Finalmente, la integración de sistemas agentic en sectores críticos como salud, finanzas, gobierno o seguridad pública subraya la urgencia por establecer marcos regulatorios sólidos que cubran todas las dimensiones de seguridad, ética y desempeño. La falta de estándares claros y protocolos universales puede conducir a un panorama fragmentado y aumentar el riesgo de fallos catastróficos a gran escala.

En conclusión, la taxonomía de modos de fallo en sistemas de IA agentic es un campo fundamental para entender y mejorar la seguridad, funcionalidad y confianza en tecnologías autónomas avanzadas. Abordar este conocimiento con un enfoque integral permitirá anticipar riesgos, diseñar estrategias de mitigación efectivas y promover un desarrollo responsable e innovador en la inteligencia artificial. La colaboración interdisciplinaria, la vigilancia constante y el compromiso ético serán pilares para alcanzar un futuro en que los agentes IA actúen como herramientas seguras y benéficas para la sociedad.

![Taxonomy of Failure Mode in Agentic AI Systems [pdf]](/images/4D8BA991-B374-4261-822B-FF549B156D14)