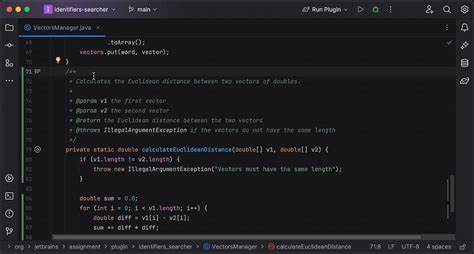

En el mundo actual del desarrollo de software, la inteligencia artificial se ha convertido en una herramienta indispensable para potenciar la productividad y mejorar la calidad del código. JetBrains AI Assistant, un complemento popular en la suite de entornos de desarrollo integrados (IDE) de JetBrains, ofrece capacidades inteligentes para asistir a los programadores. Sin embargo, aunque es una plataforma poderosa, sus planes gratuitos presentan limitaciones significativas en cuanto a la cantidad de accesos y funciones. Esta circunstancia ha impulsado la innovación en la manera de integrar otros servicios de inteligencia artificial a través de APIs de modelos de lenguaje grandes (LLM, por sus siglas en inglés) de terceros, ampliando así las posibilidades dentro del ecosistema JetBrains. Uno de los desarrollos más interesantes en este campo es un proyecto llamado ProxyAsLocalModel, que funciona como un servidor proxy adaptando APIs de terceros para que sean consumidas por JetBrains AI Assistant como si fueran modelos locales.

Esta idea surge como respuesta directa a las restricciones del servicio nativo de JetBrains, y además a la ausencia de soporte nativo para muchos servicios propios de terceros, lo que limitaba la flexibilidad de los usuarios que querían utilizar APIs como las de OpenAI, Gemini, Claude, Qwen, entre otros. ProxyAsLocalModel se destaca por estar construido en Kotlin, aprovechando tecnologías como Ktor y kotlinx.serialization. Estas herramientas contribuyen a que el servidor proxy sea eficiente, con un enfoque funcional y sin uso excesivo de reflexión, lo que es especialmente importante para optimizar el rendimiento y la compatibilidad con GraalVM, una máquina virtual que permite generar imágenes nativas ultrarrápidas y ligeras. Esta elección tecnológica facilita que ProxyAsLocalModel sea multiplataforma, con un arranque rápido y bajo consumo de memoria, ideales para integrarse en entornos de desarrollo profesionales.

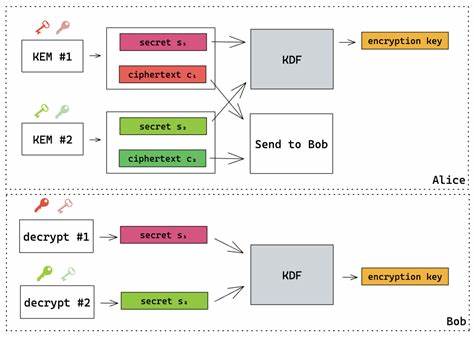

El funcionamiento básico consiste en interceptar las llamadas que JetBrains AI Assistant realiza a modelos locales, y redirigir estas solicitudes hacia APIs remotas de terceros, retornando las respuestas en un formato compatible. El proxy emula las interfaces de LM Studio y Ollama, dos populares plataformas para modelos de lenguaje locales, actuando de puente para que el asistente de JetBrains no detecte la diferencia entre un modelo realmente local y uno remoto. Esta capacidad de proxy es especialmente útil para desarrolladores que quieren sacar ventaja de servicios de inteligencia artificial sin depender exclusivamente de la cuota limitada de JetBrains o sin quedarse confinados a las plataformas locales soportadas. El proyecto soporta múltiples proveedores líderes en la industria de inteligencia artificial, incluyendo OpenAI, Claude, Alibaba Qwen, Gemini, Deepseek, Mistral y SiliconFlow, entre otros. Se enfoca en las APIs de chat con respuesta continua, lo que mejora la experiencia de interacción en tiempo real con los asistentes de código.

Una ventaja destacable es la configuración dinámica y el hot-reload del archivo de configuración. Esto facilita a los usuarios modificar parámetros como puertos, hosts, rutas, tiempos de espera y detalles específicos de las APIs, sin necesidad de reiniciar el servidor proxy manualmente. El sistema detecta los cambios y los aplica de inmediato, manteniendo la productividad y evitando interrupciones. Desde la perspectiva de un desarrollador o equipo que usa JetBrains AI Assistant, contar con la capacidad de utilizar modelos personales o de terceros brinda oportunidades para ajustarse a modelos más económicos, especializados o con características exclusivas. Por ejemplo, un desarrollador que trabaja con modelos específicos de Gemini o Qwen puede integrar estas opciones sin tener que salir del mismo entorno de desarrollo, ni romper flujos de trabajo que serían más lentos al usar herramientas externas.

Este enfoque también contribuye a la privacidad y control, pues los datos pasan por un servidor proxy local, lo que permite a los usuarios auditar o monitorizar el tráfico de las llamadas a los modelos antes que estas lleguen a la nube de terceros. Además, al ser un proyecto open source, los usuarios pueden revisar, modificar y adaptar el código a sus necesidades específicas, fomentando una comunidad de colaboración que impulsa la mejora continua. En términos de instalación y uso, la aplicación está disponible en formatos como un archivo JAR ejecutable y una imagen nativa GraalVM para Windows x64, lo que facilita su despliegue en diversos entornos. Al ejecutarse, crea un archivo de configuración inicial con esquemas y anotaciones para facilitar la edición con autocompletado en editores compatibles, mejorando la experiencia del usuario al configurar los detalles. Algunos conceptos clave que impulsan la adopción de ProxyAsLocalModel incluyen el enfoque hacia la programación funcional y la reducción de resolución dinámica o reflexiva, lo que mejora el rendimiento y estabilidad.

Esto también refleja una tendencia creciente en el desarrollo de backends modernos, donde la simplicidad, la tipificación fuerte y la eficiencia son prioritarias. Además de aportar un puente para la utilización de una mayor variedad de APIs en el ambiente JetBrains, esta solución abre la puerta para que futuros desarrollos extiendan y personalicen las capacidades de inteligencia artificial en los IDEs. La posibilidad de enlazar con APIs externas de manera transparente crea un ecosistema flexible y adaptable a las rápidas innovaciones en modelos de inteligencia artificial. En conclusión, la integración de APIs de modelos de lenguaje de terceros en JetBrains AI Assistant mediante ProxyAsLocalModel representa una innovación práctica y estratégica que expande drásticamente el potencial del asistente inteligente dentro del entorno de desarrollo. Los aspectos técnicos del proyecto evidencian una implementación sólida, con tecnologías modernas y un diseño funcional, que responden a las necesidades reales de los desarrolladores que desean acceder a modelos más versátiles, eficientes y económicos sin dejar de usar sus herramientas favoritas.

Esta iniciativa es un excelente ejemplo de cómo la comunidad puede crear soluciones que superan las limitaciones de las plataformas comerciales, promoviendo una experiencia de desarrollo enriquecida con inteligencia artificial avanzada.

![Earth Is Rapidly Approaching Dangerous, Irreversible,Cascading Climate Tipping [video]](/images/3148CF75-5213-443A-AC44-A02B3D0F9EF6)