El avance del aprendizaje por refuerzo profundo ha revolucionado la forma en que las máquinas aprenden a tomar decisiones y resolver problemas complejos. Desde juegos hasta robótica, esta rama del aprendizaje automático ha demostrado una capacidad sin precedentes para crear agentes inteligentes capaces de aprender de la experiencia y adaptarse a entornos cambiantes. En este contexto, ToyRL emerge como una biblioteca pequeña pero poderosa que implementa de manera clara y didáctica los algoritmos clásicos más relevantes de esta disciplina. ToyRL es una biblioteca escrita en Python que se diferencia por su simplicidad, eficiencia y enfoque en la enseñanza. A pesar de su tamaño compacto, incluye implementaciones de algoritmos fundamentales del aprendizaje por refuerzo profundo tales como REINFORCE, SARSA, DQN y Double DQN, así como métodos más avanzados como A2C (Advantage Actor-Critic) y PPO (Proximal Policy Optimization).

Su estructura modular y accesible permite que tanto estudiantes como investigadores y desarrolladores puedan entender en detalle el funcionamiento de estos algoritmos y aplicarlos en proyectos reales. Una de las ventajas principales de ToyRL es que está inspirada en dos importantes referentes del aprendizaje por refuerzo: el libro "Foundations of Deep Reinforcement Learning" y las implementaciones del laboratorio SLM-Lab. Además, su código toma como referencia la implementación de PPO en el repositorio CleanRL, conocido por su limpieza y efectividad. Esto da a ToyRL una base sólida y confiable, combinando rigor académico con buenas prácticas de programación. La instalación de ToyRL es simple y rápida mediante pip, lo que facilita su incorporación en cualquier entorno de desarrollo.

Una vez instalado, los usuarios pueden acceder a ejemplos y documentación detallada que guía paso a paso la ejecución de diferentes algoritmos. Esta accesibilidad permite a los interesados en aprendizaje por refuerzo obtener resultados rápidamente y comprender en profundidad cada uno de los componentes que conforman una solución basada en inteligencia artificial. El aprendizaje por refuerzo se basa en una metáfora sencilla: un agente que interactúa con un entorno, recibe recompensas o penalizaciones y ajusta su comportamiento para maximizar la recompensa acumulada a largo plazo. ToyRL implementa esta interacción mediante simuladores y entornos compatibles, permitiendo experimentar con diversos escenarios y problemáticas. Desde ambientes simples para entender conceptos básicos hasta problemas más complejos para probar sistemas avanzados.

REINFORCE es uno de los algoritmos clásicos disponibles en ToyRL. Este método basado en políticas escribe una regla de actualización que ajusta directamente los parámetros del modelo utilizando gradientes de política. Aunque sencillo en teoría, puede resultar inestable en la práctica, lo que hace crucial que aprendices manejen bien sus características. ToyRL facilita esta exploración permitiendo experimentar con esta técnica y entender cómo la política mejora conforme aprende mediante pruebas y errores. Por otro lado, SARSA se destaca como un algoritmo de control basado en valores que actualiza su política y valores estimados simultáneamente, usando el concepto on-policy.

Esto significa que ajusta su comportamiento conforme distintas acciones se prueban dentro del propio proceso de toma de decisiones. Implementar SARSA en ToyRL muestra cómo la combinación de exploración y explotación es clave para el éxito del aprendizaje y ofrece un marco sólido para comparaciones con métodos off-policy. Deep Q-Network (DQN) y su versión mejorada Double DQN también forman parte del repertorio de ToyRL. DQN fue uno de los primeros métodos exitosos para aplicar aprendizaje profundo al aprendizaje por refuerzo, permitiendo aproximar funciones de valor en espacios de estados grandes mediante redes neuronales. Su variante Double DQN mejora la estimación del valor reduciendo el sesgo positivo que aparece en la versión original.

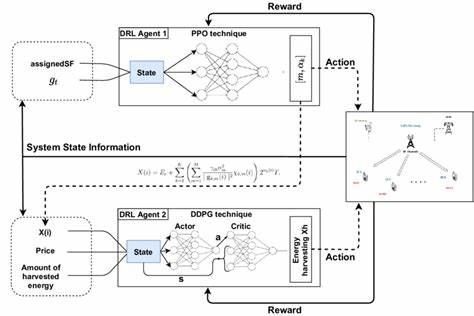

ToyRL ofrece implementaciones claras para estudiar estos avances, que han sido fundamentales para la evolución del campo. Para técnicas más sofisticadas, ToyRL incluye Advantage Actor-Critic (A2C) y Proximal Policy Optimization (PPO). A2C combina las ventajas de los métodos basados en valores y políticas para optimizar el aprendizaje, usando un actor que aprende una política y un crítico que evalúa las acciones. PPO, por su parte, es un algoritmo de optimización de políticas con estabilidad mejorada, utilizando técnicas para limitar cambios abruptos y asegurar que las actualizaciones se mantengan dentro de un rango saludable. Estas implementaciones en ToyRL permiten a los usuarios acceder a técnicas estado-del-arte con un código limpio y entendible.

El proyecto cuenta con ejemplos y pruebas que garantizan la funcionalidad y permiten a los usuarios experimentar con diferentes configuraciones. Esta característica es esencial para el aprendizaje efectivo, ya que promueve ensayo y error, una parte natural del desarrollo en inteligencia artificial. Además, la documentación en línea acompañada de tutoriales contribuye a que ToyRL sea una herramienta valiosa para estudiantes y profesionales que deseen profundizar en el aprendizaje por refuerzo. En resumen, ToyRL se presenta como una solución accesible y potente para aquellos interesados en el aprendizaje por refuerzo profundo. Su diseño enfocado en implementar algoritmos clásicos, apoyado por referencias académicas y repositorios consolidados, lo convierte en una herramienta ideal para el estudio y desarrollo de proyectos.

Al ser open source, también fomenta la colaboración y mejora continua por parte de la comunidad científica y tecnológica. El aprendizaje por refuerzo es un área en constante crecimiento y ToyRL representa una puerta de entrada ideal para comprender y aprovechar estos avances. Aplicando esta biblioteca, desarrolladores pueden construir agentes inteligentes que aprenden de su entorno, enfrentarse a problemas reales y participar activamente en la innovación tecnológica. Con ToyRL, el aprendizaje por refuerzo profundo se vuelve accesible, comprensible y aplicable, impulsando el futuro de la inteligencia artificial.

![Multi-Agent Systems in OpenAI's Agents SDK [video]](/images/96E2F85F-CB68-4F16-AB41-455E4E21A439)