En la actualidad, la inteligencia artificial se ha convertido en un pilar fundamental para múltiples industrias, destacando especialmente en el sector del desarrollo de software. Sin embargo, la rapidez con que evolucionan las herramientas de IA supera la capacidad humana para adaptarse, generando desafíos significativos para quienes buscan mantener el control y la eficiencia en sus proyectos. Gestionar agentes de IA en el mundo real puede parecer una misión imposible, pero con las técnicas y enfoques adecuados, es posible no solo mantener el control, sino también aprovechar al máximo su potencial. Las herramientas basadas en inteligencia artificial representan una revolución en la forma de abordar la programación y el manejo de código. Estos agentes actúan predeciblemente, generando respuestas basadas en enormes volúmenes de datos y modelos estadísticos que anticipan el siguiente texto más probable.

Por ello, entender que estas respuestas son predicciones, y no soluciones definitivas, es esencial para evitar errores y desalineaciones con los objetivos reales del proyecto. Un aspecto crucial para manejar estos agentes de manera exitosa es la calidad de los insumos que se le suministran. En este contexto, los insumos no son las herramientas per se, sino el código, diagramas, datos y prompts que se utilizan. La técnica está en cómo se combinan y presentan estos materiales al agente de IA. A diferencia de la programación tradicional, donde la calidad del código puede depender del desarrollo individual, la interacción con agentes de IA depende profundamente de la claridad, precisión y contexto bien definido presentes en los insumos.

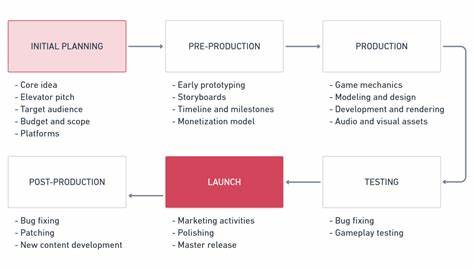

La selección del agente o modelo adecuado también juega un papel vital. Los modelos de IA varían en complejidad, capacidad de razonamiento y precio. Por lo general, existen modelos orientados a acciones directas que son más económicos y rápidos para ejecutar instrucciones específicas, modelos de planificación y depuración que realizan múltiples procesos internos y son un poco más costosos, y modelos de pensamiento profundo capaces de llevar a cabo tareas complejas y extensas, pero cuyo uso debe ser controlado para evitar sobrecostos y resultados inesperados. Planificar con detalle es probablemente la etapa más importante en la gestión de agentes de IA. La sobreconfianza en la que se podría simplemente decirle algo al agente y obtener resultados perfectos —lo que algunos llaman “vibe coding”— es un enfoque peligroso.

Aunque estos modelos tienen la capacidad de generar una gran variedad de resultados, la falta de una planificación estructurada generalmente conduce a prototipos poco robustos que no cumplen con los estándares de producción o mantenimiento a largo plazo. Una práctica recomendada es elaborar planes reutilizables y modulares, inclusive para tareas que solo se realizarán una vez. Esto puede parecer contraintuitivo, pero al crear planes que puedan ser ejecutados, revisados y ajustados múltiples veces, se mejora la eficiencia, se reduce la necesidad de explicar constantemente las tareas al agente y se facilita la revisión y expansión futura del proyecto. La manera de dividir el trabajo en partes pequeñas y manejables es fundamental. Esto permite que cada etapa se pueda completar con éxito y que, en caso de dudas sobre la viabilidad del plan, se vuelva a la fase de investigación para ajustar el enfoque.

Los agentes, en ausencia de un plan claro y confiable, tienden a improvisar soluciones que pueden funcionar en apariencia, pero que a menudo generan errores o fallos en la integración con el resto del software. Además de la planificación, es imperativo conocer el terreno donde el agente actuará. Esto implica entender las arquitecturas existentes, las limitaciones y la lógica propia del código y el sistema donde se integrará la solución. La IA no “sabe” cómo funciona el código ni las intenciones específicas del desarrollador, a menos que se le informe de manera clara y detallada. Con frecuencia, problemas estructurales o arquitectónicos en el código propio se evidencian al interactuar con agentes de IA, dado que estos rápidamente ponen en evidencia las debilidades o inconsistencias del sistema.

En lugar de tratar de saltarse o maquillar estos problemas, lo ideal es reconocerlos y utilizarlos como oportunidades para refactorizar, optimizar y simplificar el proyecto entero. Para facilitar este trabajo con agentes, se recomienda mantener una documentación viva dentro del repositorio de código, como planes y reglas escritas en formatos legibles y accesibles. Estos documentos actúan como contratos claros y programas ejecutables, que pueden ser invocados y actualizados continuamente mediante la interacción con el agente. Esta práctica también mejora la trazabilidad y permite un trabajo colaborativo más eficiente. Es importante destacar que confiar ciegamente en la IA para ejecutar pruebas o validar resultados puede ser contraproducente.

Los agentes, al actuar solo por modelos predictivos, pueden pasar por alto fallos visibles o intereses reales del proyecto, produciendo soluciones que parecen funcionar en el entorno controlado del prompt pero que fallan en la práctica. Por ello, el desarrollador debe realizar evaluaciones manuales, ejecutar pruebas locales, y llevar un control riguroso de los cambios y commits. Los costos asociados al uso intensivo de agentes de IA son otro factor que no se debe subestimar. Aunque es tentador dejar que el modelo “haga todo el trabajo”, es fundamental controlar el uso, establecer límites, y seleccionar con criterio cuándo y qué modelos utilizar para optimizar la relación costo-beneficio. Esto implica desactivar modelos caros o ineficientes, aprovechar promociones, y no dejar la elección del modelo en manos de la herramienta sin supervisión humana.

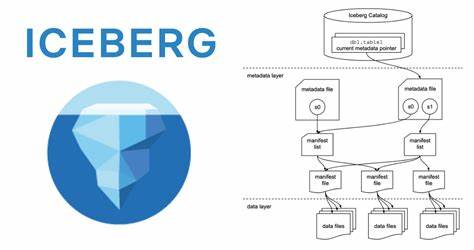

A medida que la interacción con agentes se vuelve más frecuente y profunda, se hacen evidentes las limitaciones del aprendizaje de las IA en contextos muy específicos. A diferencia de los seres humanos, los modelos de lenguaje no almacenan conocimiento experimental ni se adaptan dinámicamente a largo plazo; suelen ofrecer respuestas basadas en patrones vistos en sus datos de entrenamiento. Por lo tanto, es necesario repetir instrucciones clave, cuidar los contextos y suministrar reglas precisas que guíen el comportamiento del agente durante la sesión. El protocolo conocido como MCP (Model Context Protocol) busca estandarizar la comunicación entre agentes de IA y herramientas, definiendo un esquema para el intercambio de prompts y llamadas de API. A pesar de su aparente novedad y nombre evocador, MCP no incorpora magia ni autonomía real: solo codifica la manera de conectar modelos y herramientas, lo que ya se puede manejar con integraciones existentes.

Los desafíos persisten, pues el éxito depende de mantener un contexto adecuado y contenido válido para evitar errores derivativos. En definitiva, gestionar agentes de IA en proyectos reales exige un compromiso serio de planificación, estructuración, supervisión y documentación por parte del humano, más allá de las expectativas de automatización total. Es necesario repensar la relación tradicional entre desarrollador y código, aceptando que la inteligencia artificial es una herramienta poderosa, pero no un reemplazo del ingenio y el rigor profesional. Este enfoque renovado también implica una evolución en las competencias del programador. Ya no es suficiente escribir líneas de código; hay que dominar el arte de comunicarse con los agentes de IA, tener sensibilidad para detectar problemas arquitectónicos y preparar escenarios claros y estructurados para que la IA responda con eficiencia.

Quienes adopten esta mentalidad aprovecharán más rápido los beneficios de la inteligencia artificial en el desarrollo tecnológico. En resumen, aunque parece una misión imposible, controlar con éxito la interacción con agentes de IA en el mundo real es una tarea alcanzable mediante la combinación del conocimiento técnico, la paciencia para planificar y revisar, y el entendimiento profundo del código y del negocio. Este enfoque promete no solo mejorar la calidad y velocidad del desarrollo, sino también facilitar un trabajo colaborativo más limpio y sostenible con agentes de inteligencia artificial.