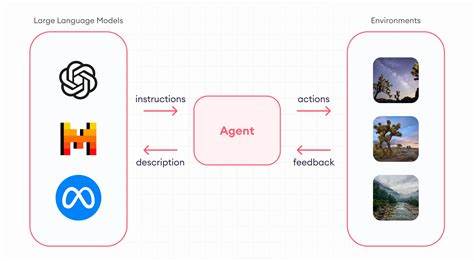

En el mundo actual, la inteligencia artificial ha avanzado a pasos agigantados, especialmente en el ámbito de los modelos que integran visión y lenguaje. Estos modelos fusionan la capacidad de comprender imágenes con el procesamiento del lenguaje natural para ofrecer respuestas inteligentes, realizar descripciones o incluso interactuar en entornos multimedia de forma dinámica. Recientemente, Apple ha dado un gran salto con el lanzamiento de FastVLM, un modelo de visión y lenguaje que destaca por su velocidad y eficiencia, posicionándose como una propuesta revolucionaria dentro de este campo. FastVLM se presenta como una solución innovadora en la interpretación de imágenes gracias a un nuevo enfoque en la codificación visual, llamado FastViTHD, desarrollado para disminuir la cantidad de tokens generados durante el procesamiento de imágenes. Esta reducción se traduce en una notable disminución del tiempo necesario para interpretar imágenes, especialmente aquellas de alta resolución, sin sacrificar la calidad o precisión de los resultados.

La importancia de mejorar la velocidad de los modelos de visión-lenguaje va más allá del ámbito académico, pues tiene un impacto directo en la usabilidad de estos sistemas en dispositivos con potencia limitada, como teléfonos inteligentes, tablets y computadoras portátiles. El principal mérito de FastVLM reside en su capacidad para ofrecer tiempos de respuesta extremadamente rápidos, conocidos en el sector como Time-to-First-Token (TTFT). En comparaciones realizadas con modelos contemporáneos, la versión más pequeña de FastVLM supera a referenciales como LLaVA-OneVision-0.5B al ser hasta 85 veces más rápida en TTFT y utilizar un codificador visual mucho más compacto, aproximadamente 3.4 veces menor en tamaño.

Esta optimización del tamaño no solo facilita la implementación en dispositivos Apple, sino que también mejora la eficiencia energética, un factor clave para la experiencia del usuario móvil. Además de la versión ligera, FastVLM cuenta con variantes más potentes que emplean modelos de lenguaje de gran tamaño (Large Language Models o LLM) como Qwen2-7B. Estas variantes no solo mejoran el rendimiento general en tareas complejas de visión y lenguaje, sino que también superan a modelos más grandes y tradicionales como Cambrian-1-8B. Sorprendentemente, mantienen un alto nivel de velocidad, con una mejora de 7.9 veces en TTFT, lo cual representa un equilibrio ejemplar entre rendimiento y rapidez.

Una de las ventajas más destacadas de FastVLM es su compatibilidad con la arquitectura Apple Silicon. Apple ha diseñado su propio hardware basado en chips dedicados que optimizan el rendimiento de aplicaciones de inteligencia artificial, y FastVLM aprovecha esta infraestructura para brindar un rendimiento impecable. Para facilitar su uso en dichos dispositivos, los desarrolladores pueden exportar los modelos en formatos compatibles, con opciones de cuantización que ajustan el balance entre precisión y consumo de recursos. Esto representa una puerta abierta para integrar FastVLM en aplicaciones móviles capaces de ofrecer respuestas visuales rápidas y precisas, incluso en condiciones de conectividad o potencia limitadas. La empresa también ha presentado un prototipo de aplicación para iOS, que permite demostrar las capacidades del modelo en un entorno real.

Esta aplicación sirve como plataforma de prueba para evaluar cómo FastVLM puede transformar la interacción de los usuarios con dispositivos Apple, brindando respuestas a consultas basadas en imágenes de forma instantánea. La fluidez y naturalidad con la que el modelo interpreta contenido visual y genera descripciones detalladas es un indicativo claro de la madurez tecnológica alcanzada. Desde el punto de vista técnico, el desarrollo de FastVLM está basado en el código abierto LLaVA, un modelo híbrido que combina distintas técnicas de aprendizaje profundo. Apple ha proporcionado acceso a los pesos del modelo y scripts que permiten ejecutar inferencias tanto en entornos estándar de PyTorch como en los más específicos de Apple Silicon. Este enfoque abierto facilita que investigadores y desarrolladores puedan experimentar, optimizar y adaptar el modelo a necesidades concretas, impulsando la innovación colaborativa en inteligencia artificial.

La importancia de FastVLM trasciende la simple mejora en la velocidad de procesamiento. En un contexto donde los modelos de inteligencia artificial demandan cada vez más recursos computacionales, la propuesta de Apple enfatiza la eficiencia como criterio fundamental. Al reducir radicalmente el tiempo hasta la primera generación de token, FastVLM permite aplicaciones más interactivas, con menos latencia y mayor ahorro energético, lo que es crucial para dispositivos portátiles. Otra dimensión clave a considerar es la calidad de la interpretación que ofrece FastVLM. Aunque la rapidez es esencial, no puede ir a costa de la precisión semántica o el nivel de detalle en las respuestas.

Los estudios y evaluaciones realizadas por los desarrolladores muestran que, a pesar de su menor tamaño y mayor velocidad, FastVLM mantiene una alta calidad en tareas como descripción automática de imágenes, comprensión de escenas complejas y generación de texto coherente relacionado con contenido visual. Esto es posible gracias al enfoque híbrido en la codificación que permite preservar la riqueza de la información relevante para lenguaje y visión. El potencial de FastVLM en la industria tecnológica es amplio. Desde aplicaciones en fotografía inteligente, asistentes virtuales mejorados, accesibilidad para personas con discapacidades visuales, hasta en el sector del entretenimiento y comercio electrónico, donde la interacción visual con el usuario es clave para ofrecer experiencias personalizadas. Al estar optimizado para dispositivos Apple, los desarrolladores tienen la posibilidad de crear soluciones que aprovechen esta tecnología para lograr interacciones más naturales y rápidas.

En términos de adopción, Apple facilita la integración de FastVLM a través de documentación técnica accesible, scripts de instalación sencillos y modelos preentrenados disponibles para descarga. El ecosistema móvil y de escritorio Apple potencia así el despliegue de aplicaciones IA con grandes beneficios para usuarios finales y empresas que buscan innovación en servicios interactivos. Económicamente, la eficiencia de FastVLM podría representar ahorros significativos en infraestructura para compañías que deseen incorporar capacidades avanzadas de comprensión visual y textual sin depender exclusivamente de la nube o servidores externos. La ejecución local en dispositivos reduce latencias y mejora la privacidad, aspectos cada vez más valorados en la era digital. En conclusión, FastVLM marca un hito en la convergencia entre visión artificial y procesamiento del lenguaje natural.

Apple ha demostrado que es posible mejorar notablemente la velocidad y eficiencia de estos modelos sin comprometer su calidad. Con compatibilidad directa para Apple Silicon y un enfoque pragmático hacia la usabilidad, FastVLM está listo para ser el motor detrás de la próxima generación de aplicaciones inteligentes que requieren una interacción visual rápida y precisa. Su impacto se prevé profundo, no solo en dispositivos Apple, sino en todo el ecosistema de inteligencia artificial que depende del procesamiento multimodal para transformar cómo las máquinas entienden y responden al mundo visual que las rodea.