En la era actual de la inteligencia artificial y el aprendizaje profundo, el modelado generativo ha emergido como una herramienta crucial para la creación de contenido multimedia, incluyendo imágenes, sonido y video. Sin embargo, la generación directa en dominios de entrada como píxeles o formas de onda ha demostrado ser un desafío debido a la enorme cantidad de datos y la complejidad inherente de estas señales. Para abordar estas dificultades, ha surgido un enfoque avanzado conocido como modelado generativo en espacio latente, el cual presenta una forma más eficiente y efectiva de capturar y generar señales perceptualmente relevantes a través de representaciones compactas. El espacio latente, en este contexto, se refiere a una representación de alto nivel y compacta que no está directamente observable en los datos de entrada, pero que captura las características esenciales de la señal original. A diferencia de los latentes en estadística clásica, que suelen concebirse como variables ocultas con naturaleza probabilística, en el modelado generativo moderno estas representaciones suelen ser determinísticas y no se corresponden con ninguna propiedad física específica del objeto o señal generada.

Son, en cambio, estructuras matemáticas cuidadosamente aprendidas por redes neuronales que resumen la información perceptual significativa de manera condensada. Este enfoque parte de un proceso de dos etapas en su formación. En primer lugar, se entrena un autoencoder compuesto por un codificador que transforma la entrada en su forma latente, y un decodificador que reconstruye la señal original a partir de dicha representación. La calidad de esta reconstrucción es vital, pues asegura que la representación latente preserve el contenido perceptual esencial. Para lograrlo, se emplean diversos tipos de funciones de pérdida que garantizan fidelidad, incluyendo pérdidas de regresión, que evalúan errores en el espacio original, pérdidas perceptuales que miden discrepancias en espacios de características aprendidos, y pérdidas adversariales que impulsan el realismo mediante mecanismos similares a los de las redes generativas antagónicas.

Una vez establecida esta representación latente robusta y eficiente, se fija el codificador para evitar que sus parámetros se modifiquen y se entrena un modelo generativo, como un modelo autoregresivo o un modelo de difusión, directamente en el espacio latente. Este modelo recibe como entrada las representaciones latentes y aprende a modelar su distribución para poder generar nuevas muestras. Al generar en un espacio mucho más compacto, la complejidad computacional se reduce drásticamente, lo que permite acelerar el entrenamiento y la inferencia sin sacrificar la calidad perceptual de los resultados. Este paradigma ha marcado un avance importante respecto a las primeras técnicas de generación directa, que abordaban píxeles y muestras de forma individual, como PixelRNN para imágenes o WaveNet para audio. Estos métodos resultaban extremadamente costosos y propensos a modelar ruido imperceptible, afectando la eficiencia y la calidad.

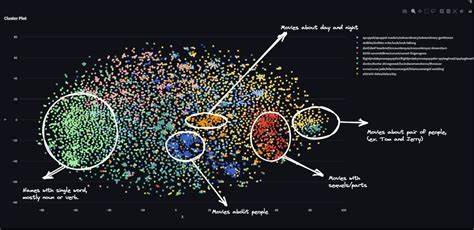

El modelado en espacio latente, al centrarse en la información perceptualmente relevante, aprovecha mejor la capacidad del modelo y evita gastar recursos en detalles insignificantes. En particular, los modelos autoregresivos en espacios latentes fueron impulsados por el éxito del VQ-VAE, una arquitectura que introdujo la cuantización vectorial para obtener representaciones discretas. Este método permitió reducir la resolución espacial de la representación hasta 16 veces y facilitó la adaptación de modelos autoregresivos de diseño originalmente pensado para píxeles a operar en estas representaciones compactas. Posteriormente, el desarrollo de VQGAN combinó estos conceptos con pérdidas adversariales, mejorando drásticamente la calidad visual y permitiendo escalabilidad a resolución mucho mayores. Paralelamente, los modelos de difusión, que introducen ruido gradual para aprender a generar señales desde ruido puro, también se beneficiaron del espacio latente para optimizar el proceso de generación.

Modelar la distribución latente con difusión permite trabajar con datos condensados, acelerando la generación y permitiendo el control sobre diferentes escalas perceptuales. Este enfoque fue popularizado por Stable Diffusion, que se convirtió en la piedra angular de numerosos modelos comerciales y de código abierto para generación de imágenes. Uno de los aspectos más interesantes del modelado en espacio latente es la distinción entre textura y estructura en señales visuales y auditivas. Texturas, como el césped en un campo, pueden variar en forma sutil sin afectar la percepción subjetiva, mientras que objetos estructurales, como los ojos de un perro, requieren una reconstrucción exacta para mantener la fidelidad. Los latentes bien diseñados abstraen la textura, permitiendo variabilidad en su reproducción, y preservan minuciosamente la estructura, lo que facilita que los modelos generativos se concentren en información relevante para la percepción humana.

La construcción del espacio latente implica también importantes decisiones sobre capacidad y forma. Por un lado, existen parámetros como el factor de reducción espacial y la cantidad de canales que determinan cuánta información puede almacenar la representación. Un compromiso fundamental aparece entre calidad de reconstrucción y facilidad para modelar la representación: una mayor capacidad mejora la reconstrucción, pero hace la distribución latente más compleja y difícil de modelar. Por otro lado, la topología del espacio latente, es decir, cómo se organizan y relacionan sus componentes, juega un papel crítico. Mantener estructuras similares a la malla regular de píxeles y muestras temporales ofrece ventajas al aprovechar la arquitectura de redes convolucionales o atencionales diseñadas para datos con estructura espacial o temporal uniforme.

Sin embargo, esta uniformidad implica también una ineficiencia, dado que diferentes regiones del dato original contienen niveles desiguales de información relevante, fenómeno que se denomina “la tiranía de la grilla”. En cuanto a los tipos de latentes, se distinguen principalmente dos grandes categorías: continuos y discretos. Los latentes continuos permiten representaciones más suaves y flexibles, generalmente reguladas con términos de pérdida que controlan su distribución, como la penalización KL. Los latentes discretos, por su parte, suelen usar técnicas de cuantización para limitar la capacidad y facilitar el modelado autoregresivo. Recientes avances buscan mejorar el equilibrio entre expresión y facilidad de aprendizaje, incluyendo nuevas formas de cuantización sin necesidad de códigos explícitos.

Un punto fundamental en la actualidad es la separación entre la tarea de aprendizaje de la representación y la tarea de reconstrucción. Tradicionalmente, estas se entrenan conjuntamente en el autoencoder, pero investigaciones recientes indican que separar estas responsabilidades puede mejorar tanto la calidad de la representación como la del generador posterior. Por ejemplo, usar decodificadores auxiliares con distintas funciones de pérdida puede permitir que la representación capture características más adecuadas para el modelado generativo, mientras que el principal decodificador se centra en la reconstrucción fiel. En cuanto a otras modalidades, aunque la mayoría de los avances han sido en la generación de imágenes, el modelado en espacio latente también se está aplicando con éxito a audio, video e incluso representaciones multiescalares. En audio, por ejemplo, se utiliza frecuentemente la reconversión a espectrogramas o representaciones mel para construir latentes que capturan las características audibles esenciales.

Sin embargo, la comprensión y desarrollo para video y audio no está tan avanzado como para imágenes, principalmente debido a la complejidad adicional de la dimensión temporal y las cualidades específicas de la percepción en tiempo. Respecto al futuro, una pregunta recurrente es si eventualmente se podrá prescindir del aprendizaje en dos etapas y entrenar modelos generativos completamente end-to-end. Aunque esta idea presenta ventajas teóricas en cuanto a optimización conjunta y simplicidad conceptual, las actuales limitaciones computacionales y la eficiencia conseguida con latentes hacen que esta transición no sea inminente. Los modelos generativos en espacio latente continúan ofreciendo una relación costo-beneficio favorable para aplicaciones prácticas a gran escala. En resumen, el modelado generativo en espacio latente representa un avance decisivo en la forma en que las máquinas generan contenido perceptual.

Al abstraer las señales en representaciones compactas y perceptualmente significativas, permite construir modelos más manejables, eficientes y efectivos. Esta revolución ha permitido la creación de imágenes de alta resolución, sonido de calidad y video con recursos computacionales mucho menores que los métodos anteriores, y sienta las bases para futuras innovaciones en múltiples dominios de la inteligencia artificial y el procesamiento de señales. Con la continua investigación en optimización de latentes, regulación de espacios, y eficiencia computacional, es probable que veamos aplicaciones aún más impresionantes y versátiles en los próximos años. Desde la generación artística hasta la compresión de datos y la realidad aumentada, el modelado en espacio latente está transformando la manera en que interactuamos con los sistemas generativos modernos, haciendo posible lo que antes parecía inalcanzable.