En las últimas décadas, la inteligencia artificial (IA) ha transformado profundamente múltiples aspectos de la sociedad, desde la salud hasta la comunicación y la educación. Uno de los avances más visibles es la capacidad de los sistemas de IA para generar contenido textual, visual y audiovisual a una escala y velocidad sin precedentes. Modelos de lenguaje como GPT y otros sistemas generativos están siendo usados para crear artículos, ensayos, reportajes y otro tipo de textos que muchas veces incluso superan a los redactados por humanos en cuanto a coherencia y fluidez. No obstante, este fenómeno trae consigo un riesgo creciente que está empezando a ser definido como el «Efecto Ouroboros». El término «Ouroboros» hace referencia a la imagen mítica de una serpiente que se muerde la cola, simbolizando ciclos infinitos o la idea de algo que se nutre a sí mismo de forma continua.

Aplicado al contexto de la IA, este concepto describe el ciclo en el que los modelos de inteligencia artificial generan contenido que luego se integra en los conjuntos de datos con los que se entrenan futuros modelos, generando un círculo vicioso que puede deteriorar la calidad y diversidad del contenido original. Con el auge de la generación automática de contenido, grandes cantidades de texto generado por IA se publican día a día en internet. Estos textos se vuelven parte de la base de datos disponible para entrenar nuevos modelos, ya sea en proyectos comerciales o de código abierto. Al absorber materiales creados artificialmente, los modelos de próxima generación corren el riesgo de aprender de una información cada vez menos fiable, menos variada y con posibles errores o sesgos amplificados. Este fenómeno amenaza con crear un estancamiento en la evolución de la calidad y el alcance de los sistemas de IA.

Uno de los ataques más notorios relacionados con esta dinámica es el deterioro gradual en el nivel de calidad del contenido generado. Así como en el juego del teléfono descompuesto la información se distorsiona en cada transmisión, la inteligencia artificial que entrena sus modelos con datos generados de manera automática puede provocar una espiral descendente en la calidad textual. Frases menos coherentes, errores semánticos y repeticiones innecesarias podrían proliferar, resultando en textos menos útiles y menos auténticos para usuarios finales. Además, otro punto crítico es la amplificación y propagación de sesgos y errores prejuzgados. Si una generación inicial de contenido de IA contiene interpretaciones parciales, prejuicios o incluso datos incorrectos, los modelos posteriores los absorberán y podrán exacerbar esas falencias.

Este efecto no solo reduce la fiabilidad de la información disponible, sino que también puede reforzar narrativas erróneas o incluso discriminatorias, dificultando la llegada a una interpretación neutral y precisa. La participación humana en la creación de contenido original disminuye proporcionalmente conforme se incrementa la cuota generada por máquinas. Esta pérdida tiene un impacto negativo en la riqueza creativa y la profundidad intuitiva que solo los autores humanos pueden aportar. La escritura humana contiene matices, emociones, referencias culturales y perspectivas únicas que enriquecen el panorama informativo. Su reducción constante en los datasets de entrenamiento puede llevar a la homogeneización y empobrecimiento del estilo y del contenido mismo.

Este fenómeno es particularmente preocupante debido a la dificultad para diferenciar contenido generado por IA de aquel hecho por personas. Las herramientas actuales de detección frecuentemente ofrecen resultados poco concluyentes, lo que dificulta la creación de filtros efectivos para excluir contenido artificial de los conjuntos de entrenamiento. Asimismo, el volumen masivo de datos que circula hace inviable la supervisión manual, aumentando la dependencia en soluciones automatizadas, que a su vez pueden no ser lo suficientemente precisas para evitar la contaminación del training data. La consecuencia de esta dinámica puede ser una internet cada vez más dominada por textos que se parecen mucho entre sí, carecen de profundidad y, en última instancia, no aportan avance real al conocimiento humano ni a la inteligencia artificial misma. A medida que los ciclos de entrenamiento se alimentan, sin una contramedida clara, el desarrollo de modelos robustos y creativos podría verse limitado y desacelerado, reduciendo la competitividad y la innovación del sector.

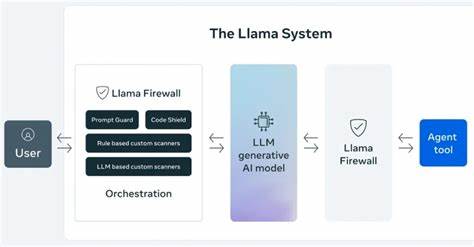

Frente a esta realidad, es fundamental implementar estrategias para mitigar el efecto pernicioso que genera el autoaprendizaje de contenido por parte de las IA. Entre las posibles soluciones, destaca el desarrollo de mecanismos avanzados para filtrar y evaluar la proveniencia y calidad de los datos empleados en el entrenamiento. Esto implica no solo detectar si un texto fue creado por un algoritmo, sino también juzgar su relevancia, exactitud y riqueza contextual. Otra aproximación consiste en diseñar conjuntos de datos híbridos que mantengan un balance saludable entre contenido generado por humanos y material producido por IA, privilegiando siempre la calidad y originalidad. La inclusión de datos sintéticos cuidadosamente elaborados puede representar una vía para enriquecer los modelos sin caer en la repetición o la autoalimentación nociva.

La transparencia es otro elemento clave. Etiquetar claramente los contenidos generados por inteligencia artificial permite a investigadores, desarrolladores y usuarios conocer las características de la información que se maneja, facilitando una curación más efectiva y fomentando mayor confianza en el ecosistema digital. Iniciativas como la de Meta en el etiquetado de imágenes y otros medios pueden servir de ejemplo para futuros esfuerzos en este sentido. Finalmente, la supervisión y el control humano continúan siendo indispensables. Los expertos en IA, lingüística, ética y otras disciplinas deben mantener un rol activo en la revisión, entrenamiento y mejora de los sistemas, asegurando que los algoritmos evolutivos no se desvíen hacia estados de baja calidad o riesgo.

El desafío que presenta el efecto Ouroboros en la generación y aprendizaje de contenido por IA es complejo y multifacético, implicando cuestiones técnicas, éticas y sociales. La comunidad global de desarrolladores, investigadores y reguladores debe colaborar para construir soluciones innovadoras y responsables. Al afrontar esta problemática, no solo se garantizará una evolución sostenible de las tecnologías de inteligencia artificial, sino que también se preservará la diversidad cultural, creativa y cognitiva del contenido digital que utilizamos y producimos a diario. Garantizar que el futuro de la IA sea un reflejo genuino de la inteligencia y creatividad humanas es vital para el avance tecnológico y el bienestar social. En conclusión, el Efecto Ouroboros nos recuerda que la innovación debe estar acompañada de vigilancia y medidas preventivas.

La dependencia indiscriminada del contenido generado por IA para retroalimentar nuevos sistemas puede convertir a la inteligencia artificial en una espiral regresiva que limite su propio progreso. Para evitar esta trampa, es esencial establecer estándares rigurosos, fortalecer la transparencia y mantener la constante participación humana en el núcleo del desarrollo tecnológico.