En un mundo cada vez más dependiente de la inteligencia artificial, la seguridad de los sistemas que la ejecutan se vuelve una prioridad fundamental. Meta, la reconocida empresa tecnológica, ha dado un paso importante al anunciar LlamaFirewall, un framework de código abierto que busca proteger las aplicaciones y agentes de inteligencia artificial ante diversas vulnerabilidades que han amenazado la integridad y confiabilidad de estos sistemas. LlamaFirewall surge en un momento donde la adopción de modelos de lenguaje grande (LLM) y agentes autónomos está creciendo exponencialmente. Sin embargo, también se incrementan los riesgos asociados, entre ellos los ataques conocidos como jailbreaks y las inyecciones de prompts, métodos mediante los cuales actores malintencionados intentan manipular el comportamiento del modelo para que éste ejecute instrucciones no autorizadas o inseguras. El problema de las jailbreaks en IA no solo compromete los sistemas, sino que puede ser la puerta de entrada para la generación de códigos inseguros que representan un riesgo directo para la ciberseguridad en general.

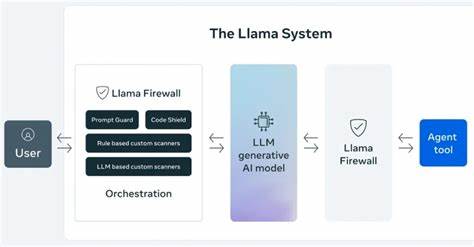

En ese contexto, la propuesta de Meta con LlamaFirewall es una solución integral que previene y mitiga esos ataques a través de una arquitectura modular y multifacética. LlamaFirewall está compuesto por tres guardias fundamentales que trabajan en conjunto para asegurar la operación confiable de la IA. El primero, PromptGuard 2, detecta en tiempo real intentos directos de jailbreak o inyección de prompt, bloqueando las manipulaciones maliciosas antes de que afecten el sistema. Esta vigilancia proactiva permite que las aplicaciones mantengan el control sobre las interacciones que el usuario o agentes externos intentan establecer con el modelo. El segundo componente, Agent Alignment Checks, se centra en la supervisión del razonamiento interno de los agentes autónomos, con el objetivo de identificar posibles desviaciones en sus metas o intenciones, lo que comúnmente se conoce como secuestro de objetivos.

Este control es clave para interceptar ataques indirectos, donde los comandos maliciosos pueden ocultarse en solicitudes aparentemente legítimas pero cuyo fin es alterar el comportamiento o los resultados del modelo. Finalmente, CodeShield funciona como un motor de análisis estático en línea que evalúa el código generado por los agentes IA para evitar la producción de scripts inseguros o peligrosos. Esta función es esencial para prevenir vulnerabilidades en el software que pueden ser explotadas posteriormente por atacantes. Uno de los grandes aciertos de LlamaFirewall es su diseño modular, que permite a desarrolladores y equipos de seguridad crear capas defensivas adaptadas a sus necesidades específicas, ya sea para modelos de conversación simples o agentes autónomos complejos. Esta flexibilidad facilita la integración en proyectos existentes y asegura una protección escalable conforme se amplía el uso de la IA.

Además de LlamaFirewall, Meta ha actualizado herramientas complementarias como LlamaGuard y CyberSecEval, mejorando la detección de contenido que infringe políticas y evaluando las capacidades de defensa cibernética de los sistemas AI respectivamente. Un avance relevante dentro de CyberSecEval 4 es la incorporación de AutoPatchBench, un benchmark que mide la capacidad de un modelo de lenguaje para reparar automáticamente vulnerabilidades en código C/C++ identificadas mediante fuzzing, una técnica avanzada de detección de errores. AutoPatchBench representa un paso innovador hacia la automatización de la corrección de fallos de seguridad, permitiendo entender mejor las fortalezas y limitaciones de los enfoques asistidos por IA en el parcheo de vulnerabilidades, un tema crucial dado el volumen creciente de código y la complejidad de los sistemas actuales. Complementando estas iniciativas, Meta ha puesto en marcha el programa Llama for Defenders, diseñado para ayudar a organizaciones asociadas y desarrolladores a obtener acceso temprano y cerrado a soluciones de inteligencia artificial enfocadas en seguridad. Este programa facilita la creación de herramientas capaces de identificar contenido generado por IA utilizado en estafas, fraudes y ataques de phishing, contribuyendo a un ecosistema más seguro y confiable.

Paralelamente, WhatsApp está introduciendo Private Processing, una tecnología que permite a los usuarios utilizar funciones de inteligencia artificial sin comprometer su privacidad, al procesar las solicitudes en entornos seguros y confidenciales. Esta apuesta por la privacidad refleja la visión integral de Meta para desarrollar soluciones tecnológicas responsables y centradas en el usuario. El compromiso de Meta con la colaboración abierta es evidente en su trabajo conjunto con la comunidad de seguridad, quienes están auditando y mejorando continuamente la arquitectura de LlamaFirewall y Private Processing. Esta transparencia y cooperación anticipan un desarrollo robusto y confiable que pueda responder a los desafíos actuales y futuros de la IA. En un contexto donde los ataques cibernéticos se sofisticar cada vez más y la inteligencia artificial se integra en múltiples sectores, contar con herramientas como LlamaFirewall representa un avance crucial para proteger datos, sistemas y usuarios.

La capacidad de detectar, analizar y mitigar amenazas en tiempo real, junto con la facilidad para integrar medidas adaptables y escalables, posiciona a Meta como un referente en la construcción de un ecosistema de IA más seguro. La irrupción de la IA en la industria tecnológica y en la sociedad demanda un foco constante en seguridad. La propuesta de Meta demuestra que es posible anticipar y enfrentar las amenazas emergentes con soluciones innovadoras, que no solo responden a los problemas conocidos, sino que también preparan el terreno para desafíos futuros. En conclusión, LlamaFirewall, junto con las herramientas añadidas y programas complementarios, establece un nuevo estándar para la protección de los sistemas inteligentes. Facilita a desarrolladores y equipos de seguridad la implementación de defensas robustas contra ataques complejos, reforzando la confianza en el uso de la inteligencia artificial a gran escala, sin sacrificar la seguridad ni la privacidad de los usuarios.

Con estas iniciativas, Meta fortalece la frontera entre innovación y seguridad, un equilibrio necesario para el avance tecnológico sostenible.