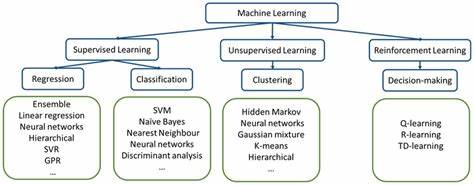

El campo del aprendizaje automático (ML) y, en particular, las arquitecturas transformer, ha experimentado un crecimiento explosivo en los últimos años. Este avance ha planteado una pregunta fundamental para investigadores y desarrolladores: ¿qué técnicas de ML pueden emerger de forma natural dentro de estas arquitecturas y cuáles deben ser diseñadas o ‘ingenierizadas’ para maximizar su potencial? La respuesta no es trivial y requiere un análisis cuidadoso desde diferentes perspectivas. Existen dos grandes corrientes de pensamiento que guían este debate. Por un lado, están los defensores del paradigma del escalamiento, quienes creen que ajustar incentivos adecuados (como políticas en el contexto del aprendizaje por refuerzo) y aumentar la cantidad de parámetros o el volumen de datos de entrenamiento es la clave principal para mejorar los modelos de IA. Dentro de esta línea, figuras destacadas como Geoffrey Hinton sostienen que la predicción de la siguiente palabra en un texto (técnicamente llamada pre-entrenamiento autoregresivo) podría ser suficiente para impulsar el avance del campo de forma imporante sin necesidad de modificaciones arquitectónicas profundas.

Por otro lado, los partidarios del paradigma ingenieril argumentan que se necesitan innovaciones arquitectónicas significativas y avances científicos para continuar progresando. Algunos proponentes importantes, como Yann Le Cun, impulsan la idea de modelos dedicados al entendimiento del mundo – los llamados “world models” – que encajen mejor con tareas cognitivas complejas, representando un nivel de especialización más allá de la simple escala. Frente a estas posturas, la propuesta de un enfoque basado en tres principios permite una guía más equilibrada sobre cuándo dejar que surjan soluciones y cuándo intervenir mediante el diseño específico. El primero es “no diseñar lo que puede emerger”. Esto significa que si una capacidad o comportamiento puede ser aprendido automáticamente por el modelo dada su estructura y datos, no se debería imponer mediante ingeniería.

Un ejemplo es la idea del equivalente en IA de un “connectoma”, la compleja red de conexiones neuronales, la cual puede emerger sin necesidad de diseñar hubs especializados o redes de conexión rígidas. El segundo principio sostiene que sí se debe diseñar aquello que no puede emerger naturalmente, pero siempre dejando la mayor libertad posible para que los comportamientos deseados se manifiesten de forma espontánea. Por ejemplo, para lograr una composibilidad confiable (la capacidad de combinar representaciones en formas más complejas), se necesita recurrencia en profundidad. Las arquitecturas modernas añaden recurrentes de forma rudimentaria permitiendo que las capas finales se retroalimenten a las primeras tras decodificar, aunque esta solución es estética y funcionalmente limitada, pues solo permite retroalimentación global tras una pasada completa, en lugar de conexiones finas y dinámicas. Un modelo más elegante podría ser aquel donde cada capa pueda seleccionar a cuál otra se conecta de manera dinámica y decidir cuándo salir, promoviendo la emergencia de subredes modulares especializadas, de manera similar a cómo las conexiones de retroalimentación dominan una gran parte de la estructura cerebral (alrededor del 60%).

Este enfoque respeta ambos primeros principios al permitir que la arquitectura establezca conexiones en un espacio latente más expresivo que el lenguaje explícito. El tercer principio sostiene que se deben implementar soluciones ingenierizadas cuando estas ofrecen una mejora significativa en rendimiento, como el mecanismo de auto-atención que revolucionó las redes transformer. Por ejemplo, la práctica corriente de apilar secuencialmente capas de atención seguidas de redes feed-forward para obtener representaciones crecientemente abstractas puede no ser estrictamente necesaria. Podría emerger el mismo efecto permitiendo una única red recurrente en profundidad que pueda acceder dinámicamente a las capas de atención según lo requiera, lo que reflejaría cómo los humanos suelen releer pasajes cuando esto ayuda al razonamiento, pero no de manera automática ni rígida. Otra arquitectura relevante para analizar bajo estos principios es la mezcla de expertos (Mixture of Experts, MoE).

En lugar de usar una única red densa, MoE combina varias redes más pequeñas (expertos) activadas de forma esparsa por una red enrutadora. Aunque conceptualmente poderosas, estas redes presentan algunas limitaciones. Por ejemplo, los expertos suelen activarse con mayor amplitud, lo que implica un costo computacional elevado y, además, generalmente solo se activan dos expertos por token, lo que podría limitar la especialización. Por ende, MoE no cumple con el primer principio, pues fuerza diseños que limitan la emergencia libre. Un aspecto crítico poco explorado en la comunidad es el impacto de la dimensionalidad de entrada en la capacidad de generalización cero disparo (zero-shot).

Estudios recientes sugieren una correlación negativa: a mayor dimensión del input, peor es esta habilidad. Técnicas como los autoencoders variacionales, que fuerzan la reducción dimensional, podrían potencialmente servir para mejorar el aprendizaje, aunque no está claro si su aplicación debería ser emergente o ingenierizada debido a que no han sido estudiadas específicamente para este propósito. La intuición señala que esto se asemeja a un diseño de conectoma y quizá es mejor permitirle surgir libremente. La memoria episódica, elemento crucial para la formación de conocimiento semántico en el cerebro y para una eficiencia de aprendizaje superior, es escasamente considerada fuera de algunos trabajos de investigación. Aún no está definido si debería implementarse mediante un componente dedicado que emule el papel del hipocampo o si podría surgir emergentemente; además, parece claro que formas de aprendizaje “activas”, más allá del simple ajuste mediante retropropagación basada en gradiente, necesitarían algoritmos y redes de retroalimentación especializadas, posiblemente incluyendo neuromodulación.

Esto apunta hacia la necesidad de diseño ingenieril para incorporar este tipo de funcionalidades. En cuanto a las técnicas de entrenamiento, el aprendizaje curricular sobresale como un caso particular. Aunque se sale del marco de principios dado que no es una modificación arquitectónica, mejora el rendimiento global e incluso podría facilitar la emergencia de ciertos comportamientos al ordenar el aprendizaje de tareas de forma gradual y estructurada. En resumen, el avance en las arquitecturas transformer y el aprendizaje automático requiere un balance cuidado entre dejar que las propiedades emergentes surjan de modelos con suficientes parámetros y datos y la intervención ingenieril para impulsar capacidades que no pueden nacer espontáneamente. La clave está en evaluar cuidadosamente cada técnica y solución a través de los principios de permitir la emergencia libre, diseñar cuando es necesario sin restringir la libertad inherente y aplicar ingeniería solamente ante ganancias de desempeño significativas.

La continua exploración de estos principios y su aplicación práctica podría ser la ruta hacia sistemas de inteligencia artificial más potentes, flexibles y cognoscitivamente ricos, capaces de superar las limitaciones actuales y acercarse cada vez más a la complejidad y plasticidad de los cerebros biológicos.