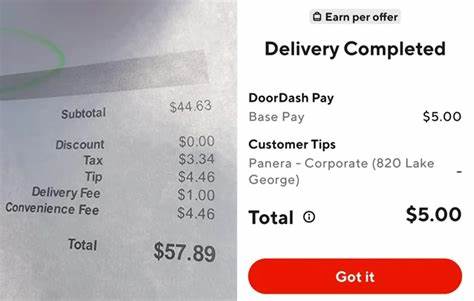

En la era digital actual, las aplicaciones web evolucionan constantemente para ofrecer experiencias fluidas, rápidas y eficientes a millones de usuarios en todo el mundo. DoorDash, una plataforma líder en entrega de alimentos, ha ejemplificado uno de los paradigmas más complejos y característicos del desarrollo de software moderno: el uso intensivo de microservicios. Sorprendentemente, una sola página de DoorDash puede realizar más de 1000 llamadas gRPC en una sola sesión. Este dato pone sobre la mesa una serie de reflexiones cruciales acerca de la arquitectura de software y los desafíos que enfrentan las empresas tecnológicas hoy en día para mantener la escalabilidad, velocidad y eficiencia en sus productos.Para entender la magnitud de estas más de mil llamadas gRPC, primero es importante contextualizar qué representa gRPC en el mundo del desarrollo.

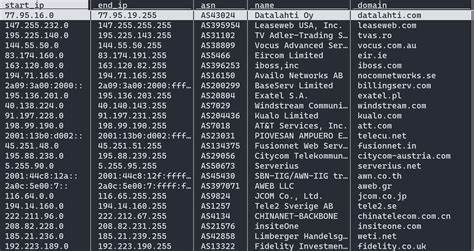

gRPC es un marco de trabajo open source creado por Google para la comunicación eficiente entre servicios, basado en el protocolo HTTP/2. Su diseño está orientado a mejorar la velocidad, reducir la latencia y facilitar el intercambio de datos en arquitecturas distribuidas, especialmente aquellas que utilizan microservicios. Esta tecnología permite que diferentes componentes o servicios dentro de una aplicación, ubicados en servidores remotos o incluso distintos continentes, se comuniquen casi como si fueran funciones locales, pero con el costo inherente de las llamadas en red.El uso extensivo de llamadas gRPC en DoorDash refleja una distribución altamente fragmentada de su aplicación, donde numerosos microservicios especializados cumplen funciones concretas, como manejar el catálogo de restaurantes, la gestión de pedidos, la personalización del usuario, la ubicación geográfica, las notificaciones y los sistemas de pago, entre otros. Cada uno de estos microservicios responde a un equipo dedicado a un área de negocio o funcionalidad, lo que permite una evolución más rápida y una mejor integración de nuevas características sin afectar la estabilidad general.

Sin embargo, esta granularidad también desencadena una complejidad significativa. Cuando una página simple requiere realizar más de 1000 llamadas gRPC, las preocupaciones sobre la latencia, el rendimiento y el consumo de recursos se vuelven inherentes. Cada llamada genera una cuota adicional de tiempo de espera, potencialmente incrementando el tiempo total de carga percibido por el usuario. Además, multiplicar las llamadas de red eleva la probabilidad de errores relacionados con la conectividad, interrupciones o problemas transitorios en alguno de los microservicios intermedios. Esto puede traducirse en fallos visibles, retrasos inesperados o experiencias degradadas que afectan la satisfacción del cliente.

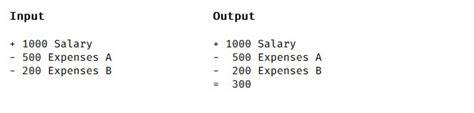

A pesar de estas desventajas aparentes, existen razones fundamentales por las cuales DoorDash y otras compañías líderes optan por una estrategia basada en microservicios y comunicación intensiva por red. En primer lugar, la escalabilidad: en lugar de escalar toda la aplicación monolítica, es posible asignar recursos estratégicamente según las demandas de cada servicio. Esto facilita gestionar picos específicos, como incrementos súbitos en la demanda de pedidos, sin necesidad de sobredimensionar la infraestructura completa. Además, la división en equipos especializados permite acelerar el desarrollo y despliegue, ya que cada grupo puede trabajar de manera independiente, sin bloquear el progreso de otros.La evolución tecnológica y la reducción constante de costes en cómputo, almacenamiento y transferencia de datos han hecho que las preocupaciones por la eficiencia en las llamadas de red sean menos limitantes que en el pasado.

El caching efectivo, la optimización de consultas y algoritmos de compresión contribuyen a minimizar el impacto del alto número de llamadas gRPC, haciendo factible la operación de este tipo de arquitecturas complejas sin sacrificar una experiencia de usuario competitiva.Una dimensión crítica que emerge con fuerza es la necesidad de monitoreo y depuración en ambientes tan fragmentados. Más de 1000 llamadas implican rastrear trayectorias complejas de datos y eventos, lo que amplifica la dificultad para identificar la raíz de un error o cuellos de botella en el sistema. Esto obliga a las organizaciones a invertir en herramientas de observabilidad avanzadas, dashboards en tiempo real y técnicas sofisticadas de logging para mantener la salud del sistema y garantizar tiempos de respuesta adecuados.En paralelo, la gestión de la consistencia de datos se vuelve desafiante cuando no existe una base de datos común o infraestructuras compartidas entre microservicios.

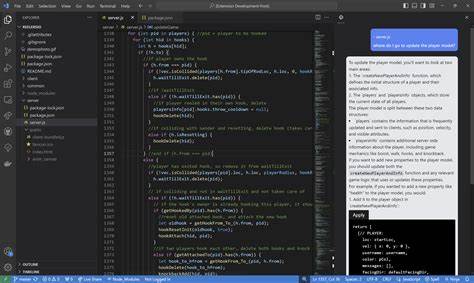

Esto puede generar situaciones donde diferentes servicios muestran información desactualizada o discrepancias en transacciones cruciales, demandando la implementación de mecanismos de sincronización, eventsourcing o bases de datos distribuidas para solventar estos problemas sin sacrificar la autonomía de cada microservicio.Existen también otras formas de compartimentar el trabajo en el desarrollo de software, como la división tradicional basada en capas técnicas, donde los equipos se especializan en frontend, backend, infraestructura o data engineering. En la práctica, muchas organizaciones adoptan modelos híbridos donde conviven estas formas de compartimentación técnica y orientada a productos o funcionalidades específicas, buscando un equilibrio ideal entre profundidad técnica y conocimiento del negocio.Un punto a destacar es la relación entre llamadas de red y llamadas locales a funciones. La comunicación dentro de un mismo proceso mediante llamadas a funciones es más rápida, menos propensa a errores y más sencilla de analizar en términos de dependencias y compatibilidad.

Sin embargo, la escalabilidad y flexibilidad aportadas por la comunicación en red son esenciales para aplicaciones distribuidas que deben estar disponibles globalmente y soportar numerosas funcionalidades simultáneas.La frecuencia de lanzamientos y actualizaciones también está directamente influenciada por el esquema de despliegue y la arquitectura. Sistemas con múltiples microservicios pueden llevar a ciclos de release muy breves y focalizados, permitiendo iterar rápidamente sin afectar la totalidad del producto. Esto, sin embargo, debe balancearse para evitar que un ritmo excesivamente acelerado complique el monitoreo y la capacidad para reaccionar ante fallos, creando una constante tensión entre velocidad y estabilidad.El caso de DoorDash sirve como un ejemplo ilustrativo para comprender no sólo las virtudes, sino también las complejidades e implicaciones implícitas en la adopción de microservicios y comunicaciones masivas vía gRPC en el desarrollo de aplicaciones modernas.

La experiencia demuestra que aunque un esquema con más de mil llamadas por página pueda parecer, a primera vista, caótico o ineficiente, su diseño responde a una optimización cuidadosa en términos de equipo, escalado, coste y experiencia de usuario en un universo donde la economía de la computación y la demanda de rapidez son polos dinámicos en continua transformación.En definitiva, entender el volumen y la naturaleza de interacción entre microservicios, como en el caso de DoorDash, es fundamental para cualquier empresa tecnológica que aspire a construir plataformas robustas, escalables y capaces de evolucionar con rapidez. El desafío está en encontrar un delicado balance entre modularidad, rendimiento y complejidad operativa, y contar con el talento y las herramientas adecuadas para navegar un paisaje donde la colaboración fluida y la vigilancia constante son claves para el éxito.