En un mundo donde la inteligencia artificial (IA) se ha convertido en una herramienta cotidiana, tanto en la vida personal como profesional, muchas organizaciones enfrentan el reto de establecer políticas claras sobre su uso, especialmente en procesos donde la autenticidad y las capacidades humanas son cruciales. Anthropic, una empresa emergente en el ámbito de la IA, ha implementado una política específica para su proceso de solicitud de empleo que prohíbe el uso de asistentes de IA durante la presentación de candidatura. Esta decisión plantea una reflexión profunda sobre cómo equilibrar las ventajas de la tecnología con la necesidad de conservar la identidad y las habilidades individuales. La política de Anthropic se basa en la intención de conocer y evaluar el interés genuino y las aptitudes comunicativas del candidato, sin la mediación o influencia directa de sistemas automatizados. Esta medida surge de un entendimiento claro: aunque la IA puede acelerar o perfeccionar la expresión escrita, puede a su vez ocultar el verdadero nivel del solicitante, complicando la evaluación justa y transparente por parte de los reclutadores.

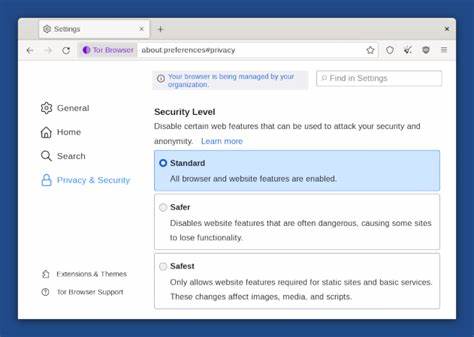

En esencia, Anthropic solicita que los aspirantes a un puesto en la empresa confirmen explícitamente que no han utilizado asistentes de IA durante el envío de su solicitud. En cuanto a motivos, la compañía se enfoca en dos pilares fundamentales: primero, quieren asegurarse de que la motivación por ser parte de Anthropic sea personal, reflexiva y no generada o elaborada por una máquina; segundo, pretenden valorar las habilidades de comunicación humana sin la ayuda de herramientas automatizadas, para así identificar a quienes realmente se adaptan a la cultura y exigencias del equipo. Esta postura no solo se limita a la fase de postulación, sino que establece un precedente sobre cómo la interacción humana debe mantenerse en ciertos ámbitos, incluso en empresas altamente ligadas a la innovación en IA. Es un giro interesante que plantea preguntas sobre los límites de la automatización y qué tan indispensable es cultivar capacidades humanas que no dependan de la tecnología. En la práctica, este enfoque implica que los candidatos deben confiar plenamente en sus competencias para redactar cartas de presentación, currículums y comunicarse eficazmente con los reclutadores.

Muchas personas han admitido que utilizan herramientas de IA para mejorar o acompañar su redacción, a menudo porque sienten que estas tecnologías les ayudan a expresarse mejor o superar inseguridades al escribir. Sin embargo, para Anthropic, ese tipo de apoyo podría ser una forma de mediación no deseada que nubla la evaluación del perfil auténtico del candidato. Es importante reconocer el desafío que representa para muchos postulantes esta exigencia. En la actualidad, el uso de asistentes de IA, como modelos de lenguaje avanzados, está ampliamente extendido y se ha convertido en una herramienta gratuita o económica que facilita desde la investigación hasta la creación de contenido escrito. Renunciar a esta ayuda podría significar para algunos un paso atrás en términos de eficiencia o confianza.

Aun así, esta política muestra una intención firme de Anthropic para fomentar autenticidad y talento genuino, y sus implicaciones son variadas. Por un lado, puede ayudar a evitar una dependencia excesiva en la tecnología para tareas que requieren un toque humano, y alentar a los aspirantes a perfeccionar sus habilidades de redacción y comunicación sin apoyo externo. Por otro lado, también llama a un diálogo más amplio sobre el papel ético de la inteligencia artificial en procesos de selección y desarrollo profesional. Otro punto relevante es la transparencia con la que Anthropic pide a los postulantes que indiquen si han acordado respetar esta política. Esta solicitud supone un compromiso abierto, que exige a los candidatos ser honestos y responsables sobre el uso que le dan a la tecnología en su proceso de solicitud.

Esta ética puede ser un filtro adicional para seleccionar a quienes valoran la integridad y la comunicación directa. Cuando se examinan testimonios de aspirantes en comunidades como Hacker News, se observan reflexiones sobre este tema que resultan enriquecedoras. Algunos usuarios reconocen que en su experiencia personal han preferido utilizar llms (modelos de lenguaje) para convertir borradores gruesos en textos más pulidos o para investigar y estructurar ideas. Sin embargo, también comentan que han optado por dejar de depender exclusivamente de estas herramientas, buscando que sus textos reflejen más verdaderamente su estilo y voz propias. Esta evolución ilustra que aunque la IA es una ayuda poderosa, la expresión humana auténtica sigue teniendo un valor insustituible.

A nivel general, muchas empresas tecnológicas y startups innovadoras enfrentan dilemas parecidos respecto al uso de IA en el ámbito laboral y en los procesos de contratación. Mientras la eficiencia y productividad mejoran gracias a estas herramientas, también aumenta la preocupación por mantener la equidad y la valoración de competencias reales, sin máscaras digitales. La política de Anthropic es un ejemplo concreto de cómo estas tensiones se traducen en reglas específicas. Mirando hacia adelante, es probable que veamos un aumento en políticas de este tipo, en donde se delimite el uso de la inteligencia artificial para asegurar que los procesos humanos conserven su esencia. También podríamos esperar el desarrollo de nuevas técnicas o herramientas de detección que ayuden a identificar texto o contenido elaborado por IA, y así asegurar el cumplimiento de dichas normativas.