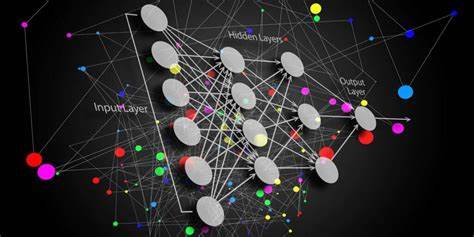

En el mundo de la inteligencia artificial y el procesamiento del lenguaje natural, la arquitectura Transformer ha dominado el panorama durante los últimos años, gracias a su capacidad para generar texto coherente y contextual a partir de grandes volúmenes de datos. Sin embargo, esta arquitectura no está exenta de limitaciones, especialmente cuando se trata de manejar secuencias de texto extensas. Aquí es donde entra en juego Bamba, un modelo de lenguaje abierto y revolucionario que combina Transformer con modelos de espacio de estado (SSM), impulsando un cambio significativo en eficiencia y rendimiento. Los Transformers, pilares fundamentales detrás de grandes modelos como GPT y Llama, se apoyan en un mecanismo conocido como autoatención (self-attention) para evaluar la importancia de cada palabra dentro de una oración o párrafo. Este enfoque permite al modelo entender el contexto de manera precisa y generar respuestas que parecen humanas.

Sin embargo, cuando la conversación o el texto se extienden, la cantidad de cálculos y memoria que el modelo requiere crece de forma cuadrática. Esto se traduce en un procesamiento más lento y un mayor consumo de recursos, problema conocido como el “cuello de botella cuadrático”. Los modelos de espacio de estado (SSM), aunque menos reconocidos en el ámbito del lenguaje natural, tienen tradición en campos como la ingeniería eléctrica y el análisis de sistemas dinámicos. Estos modelos trabajan con un estado oculto de tamaño fijo que actúa como un resumen del pasado, actualizándose conforme llegan nuevos datos sin necesidad de aumentar su tamaño. Esto implica una gestión eficiente de la memoria y un procesamiento más rápido comparado con Transformers, especialmente en secuencias largas.

Bamba fue creado por IBM Research en colaboración con universidades de renombre como CMU, Princeton y la Universidad de Illinois. Su diseño representa un cruce innovador entre el Transformer y el SSM, buscando aprovechar lo mejor de ambos mundos: la expresividad y capacidad de atención contextual del Transformer y la rapidez y eficiencia en la gestión de la memoria del modelo de espacio de estado. Uno de los grandes avances de Bamba es la reducción significativa en la memoria requerida para almacenar la caché KV (Key-Value), un componente crucial en los Transformers para mantener información del contexto durante la generación de texto. Al minimizar esta carga, Bamba puede procesar secuencias más largas de manera más rápida y con menor latencia. De hecho, el modelo Bamba-9B ha demostrado poder operar al menos el doble de rápido que modelos Transformer de tamaño similar, sin sacrificar precisión.

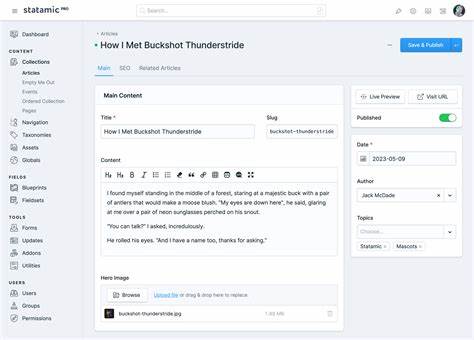

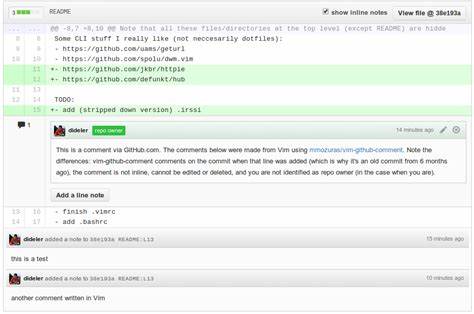

Este modelo fue entrenado inicialmente con 2 billones de tokens y luego incrementó su dataset a 3 billones, lo que junto con técnicas de cuantización que reducen el tamaño del modelo de 18GB a 9GB, ha permitido que Bamba compita en benchmarks clave con modelos conocidos como Meta Llama-3.1 8B, el cual fue entrenado con siete veces más datos. Esto habla del diseño eficiente y la calidad de los datos utilizados en la formación de Bamba. La integración de Bamba con plataformas de inferencia como vLLM, un servidor open-source que facilita la ejecución de modelos de lenguaje, resalta otro aspecto fundamental para la adopción práctica de este modelo. Los SSM, en especial cuando se mezclan con Transformers, presentan desafíos para su soporte en sistemas de inferencia estándar debido a la necesidad de gestionar estados específicos durante el procesamiento.

La colaboración de IBM con Red Hat ha sido esencial para superar estas barreras técnicas. Además, Bamba está preparado para manejar contextos extremadamente largos: fue entrenado con secuencias de 4,000 tokens pero puede gestionar conversaciones de hasta 32,000 tokens, y sus desarrolladores creen que en un futuro cercano podrá trabajar con más de un millón de tokens. Este avance tiene un impacto directo en aplicaciones como chatbots, asistentes virtuales y sistemas de análisis de texto que requieren mantener grandes cantidades de contexto para ofrecer respuestas precisas y coherentes. El surgimiento de híbridos como Bamba representa un cambio de paradigma en el diseño de modelos de lenguaje. Si bien los Transformers han dominado la escena debido a su capacidad para captar dependencias locales y globales en texto, su costo computacional limita su escalabilidad natural.

Los SSM aportan eficiencia y velocidad en tareas secuenciales, pero tradicionalmente adolecen de menor expresividad. La combinación permite que cada componente se especialice en lo que hace mejor, evitando sus limitaciones individuales. La historia de los SSM en el ámbito de la inteligencia artificial es larga pero cambiante. Durante décadas han sido herramientas fundamentales en la ingeniería para modelar sistemas físicos dinámicos. A partir de 2021, con el desarrollo de S4 por parte de Albert Gu y su equipo en Stanford, estos modelos comenzaron a adaptarse para el procesamiento de secuencias de lenguaje natural, demostrando que podían competir con enfoques establecidos y ofrecer mejores rendimientos en contextos donde se requiere manejar información a largo plazo.

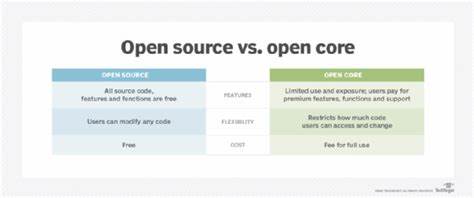

Los aportes de IBM, a través de investigadores como Ankit Gupta, han simplificado muchos de los aspectos técnicos que hacían complejo el uso de SSM en redes neuronales, reduciendo cientos de líneas de código a una mínima expresión y desarrollando mecanismos de filtrado para descartar información irrelevante. Esto ha permitido no solo mejorar la eficiencia sino también elevar la capacidad expresiva acercándola mucho más a la que ofrecen los Transformers. Proyectos como Mamba2, desarrollados por académicos de CMU y Princeton, han sido un precursor importante para Bamba, inspirando el diseño de híbridos que pueden superar a ambos enfoques por separado. Nvidia confirmó el potencial de estos híbridos, lanzando Nemotron-H que ejemplifica cómo estas tecnologías pueden acelerar la inferencia sin sacrificar calidad. El futuro de Bamba y los modelos híbridos destaca especialmente por el compromiso con el código abierto.

IBM ha liberado no solo el modelo, sino también las recetas de entrenamiento, herramientas para la carga de datos y frameworks de cuantización enfocados en reducir los costes tanto de almacenamiento como de ejecución. Este enfoque permite una colaboración más amplia en la comunidad, fomentando mejoras rápidas y personalizaciones que pueden adaptarse a casos de uso específicos. En términos prácticos, Bamba puede transformar la manera en que las empresas y desarrolladores crean y utilizan grandes modelos de lenguaje. La capacidad para manejar contextos más extensos con menor latencia significa mejores experiencias de usuario en aplicaciones de diálogo, reducción de costos en infraestructura y una mayor sostenibilidad al optimizar el consumo energético de estos sistemas. En conclusión, Bamba representa una poderosa muestra de innovación al unir lo mejor del Transformer y los modelos de espacio de estado.

Su eficiencia, velocidad y capacidad para procesar contextos largos son herramientas críticas para superar los cuellos de botella tradicionales en el procesamiento del lenguaje natural. Este modelo no sólo posiciona a IBM y sus colaboradores a la vanguardia tecnológica, sino que también abre la puerta a una nueva generación de modelos de lenguaje más inteligentes y accesibles para todo tipo de usuario. Con el apoyo de la comunidad open-source y el avance continuo de estas tecnologías, Bamba podría ser el inicio de una nueva era en inteligencia artificial aplicada al lenguaje.