La capacidad humana para aprender y adaptarse a nuevas situaciones es una de las características más notables de nuestra inteligencia. A través del aprendizaje, no solamente retenemos información específica, sino que también somos capaces de generalizar conocimientos previos a contextos inéditos. Sin embargo, entender cómo el cerebro humano logra construir estas representaciones generalizables sigue siendo un desafío fundamental en la ciencia cognitiva. Recientemente, el principio de codificación eficiente ha emergido como una explicación clave para este fenómeno, destacando que el cerebro busca representaciones simples y útiles que permitan maximizar recompensas en ambientes complejos y cambiantes. La codificación eficiente, un concepto originalmente formulado en neurociencia y teoría de la información, propone que el cerebro procesa la información del entorno de manera adaptativa para minimizar el costo de almacenamiento y procesamiento, y al mismo tiempo maximizar la utilidad.

Es decir, frente a una avalancha de estímulos sensoriales variados y multifacéticos, la mente humana tiende a destilar únicamente la información esencial que facilita la toma de decisiones eficientes. Esta tensión entre simplicidad y utilidad conduce a la formación de representaciones internas compactas que facilitan la generalización más allá de experiencias específicas. Una aplicación concreta de este planteamiento se encuentra en el marco teórico del aprendizaje por refuerzo (Reinforcement Learning, RL), que generalmente comprende que los agentes inteligentes buscan maximizar la recompensa esperada a través de sus acciones. Sin embargo, el enfoque clásico de RL raramente incluye la problemática de cómo los humanos forman representaciones internas que puedan abstraer y generalizar con eficacia. A diferencia de los sistemas artificiales con representaciones perfectamente definidas, los humanos deben inferir y construir sus propias abstracciones útiles a partir de estímulos complejos y dinámicos.

Para abordar esta brecha, investigadores han integrado la codificación eficiente en la teoría de RL, dando lugar a modelos computacionales más complejos pero más realistas sobre el aprendizaje humano. La idea central es que, además de maximizar la recompensa, el cerebro también busca que las representaciones sean lo más simples posibles sin perder información relevante para el desempeño. Este equilibrio se formaliza matemáticamente mediante funciones objetivo que penalizan la complejidad de la representación, medida por ejemplo en términos de información mutua, mientras se persigue la reducción del error o la maximización del rendimiento. Experimentos con humanos usando paradigmas diseñados para evaluar la equivalencia adquirida (acquired equivalence) muestran que los participantes logran abstraer estímulos con diferentes características superficiales pero iguales valores funcionales o vinculados a las mismas recompensas. Esto implica que el aprendizaje no solo se limita a memorizar asociaciones directas, sino que las personas construyen representaciones internas que agrupan estímulos según sus propiedades relevantes a la tarea, facilitando la generalización a nuevas situaciones no entrenadas previamente.

Un ejemplo clásico consiste en presentar a los participantes estímulos visuales distintos en forma pero similares en color, asociados a ciertas acciones o recompensas. A medida que aprenden las asociaciones, las diferencias superficiales (como detalles de forma) son desechadas si no aportan información relevante, y la mente genera representaciones abstractas donde solo subsisten las características esenciales, como el color en este caso. Este proceso, guiado por la codificación eficiente, permite que el conocimiento adquirido se transfiera rápidamente a nuevos estímulos que comparten las características abstractas aprendidas. Las representaciones compactas y abstraídas sirven como base para una generalización robusta y flexible, permitiendo al cerebro responder no solo a estímulos específicos sino también a conjuntos más amplios y cambiantes de experiencias. Este mecanismo es crucial para adaptarse a un mundo en constante cambio donde reaprender desde cero cada situación sería impracticable y cognitivamente costoso.

Además, la codificación eficiente explica cómo el cerebro puede asignar y extractar características reveladoras y recompensantes de un entorno que contiene múltiples dimensiones y señales ambiguas. En escenarios donde diferentes atributos poseen grados variables de relevancia para obtener recompensas, la mente humana aprenderá a priorizar aquellos que realmente importan. Este fenómeno se observa cuando las personas ignoran características irrelevantes o hasta engañosas (por ejemplo, colores que no indican el premio) y se concentran en señales fiables, logrando una representación de estado reducida pero efectiva para maximizar resultados. Desde una perspectiva neurológica, este proceso de formación de representaciones eficientes está apoyado por la limitación intrínseca de recursos cognitivos, como la capacidad restringida de la memoria de trabajo y la energía metabólica necesaria para el procesamiento neuronal. La codificación eficiente es un principio evolutivo y funcional que ayuda a superar estas restricciones optimizando la manera en que la información es comprimida y usada en la toma de decisiones.

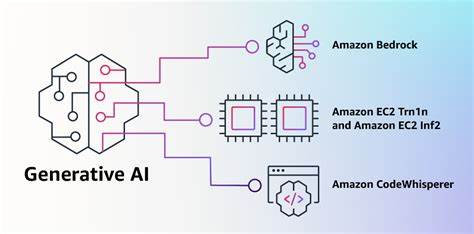

Modelos computacionales modernos que incorporan este principio han demostrado superar con creces a los modelos tradicionales de aprendizaje por refuerzo en la explicación del comportamiento humano experimental. Estos modelos incluyen un término de regularización que penaliza la complejidad de las representaciones, balanceando la precisión con la simplicidad, y logran replicar con fidelidad los patrones de generalización observados en humanos. Este nuevo enfoque integral aporta una mejora conceptual al paradigma clásico, sugiriendo que la representación y la generalización son componentes inseparables y esenciales del aprendizaje. Más allá de maximizar la recompensa inmediata, el aprendizaje humano implica simultáneamente construir modelos internos simplificados del mundo que faciliten la transferencia y adaptación a nuevas experiencias. En términos prácticos, esta comprensión también puede impactar en el desarrollo de inteligencia artificial.

Los sistemas artificiales que incorporen principios de codificación eficiente podrían adquirir habilidades de generalización más humanas, permitiendo que los agentes aprendan con menos datos, adapten más rápido y manejen mejor entornos complejos o no anticipados. Para concluir, la codificación eficiente representa un principio organizador fundamental en el aprendizaje humano. Bajo sus supuestos, el cerebro aprende a transformar la vasta complejidad del mundo externo en representaciones internas simplificadas, centradas en las características más relevantes para la toma de decisiones y la obtención de recompensas. Este proceso sostiene la capacidad humana incomparable para generalizar, adaptarse y actuar con inteligencia en un mundo variable y dinámico. La integración de este principio con la teoría del aprendizaje por refuerzo formaliza una visión más completa y poderosa de cómo aprendemos y aplicamos nuestro conocimiento a nuevas situaciones.

En el futuro, seguir explorando cómo el cerebro implementa estos procesos a nivel neuronal y cómo aplicarlos en sistemas artificiales promete no sólo avances científicos sino también innovaciones tecnológicas con impactos profundos en educación, neurociencia, robótica y más.