La representación geométrica es un elemento vital en la creación de imágenes realistas dentro de los gráficos por computadora, especialmente en técnicas avanzadas como el trazado de rayos. Tradicionalmente, este proceso ha dependido de estructuras espaciales clásicas, como las jerarquías de volúmenes acotados (BVH), para acelerar la intersección de rayos con los objetos en una escena tridimensional. Sin embargo, a pesar de décadas de optimizaciones, estas estructuras presentan limitaciones inherentes al ejecutar en hardware moderno, especialmente en unidades de procesamiento gráfico (GPU) que trabajan bajo arquitecturas SIMT (Single-Instruction Multiple-Thread). La irrregularidad de las ramas y las pautas impredecibles de acceso a memoria durante la navegación de BVH dificulta maximizar el paralelismo y el rendimiento esperado en estas plataformas. En contraste, las redes neuronales, particularmente las perceptrones multicapa (MLP), ofrecen un patrón de cómputo regular y predecible basado en multiplicaciones de matrices densas, operación que se adapta de manera natural a la arquitectura de las GPUs actuales.

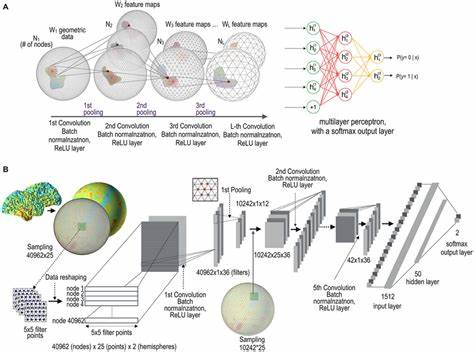

Este hecho ha impulsado la investigación hacia un planteamiento innovador que sustituya el recorrido tradicional de BVH por métodos aprendidos mediante redes neuronales, con el fin de mejorar la utilización del hardware y acelerar el proceso de detección de intersección entre rayos y geometría. Uno de los enfoques pioneros en este campo es la función de intersección neuronal (Neural Intersection Function, NIF), desarrollada por AMD en 2023. Esta propuesta integra una red neuronal directamente en la canalización del trazado de rayos, reemplazando las irregularidades del BVH con cálculos regulares, optimizados para la ejecución paralela en GPU. NIF se fundamenta en dos redes MLP separadas que gestionan rayos dados desde fuera o dentro del cuadro delimitador del objeto (AABB). Estas redes usan codificación en rejilla espacial para representar características volumétricas y verifican la visibilidad de los rayos mediante la interpretación de intersecciones con el AABB, entregando una solución unificada que acelera la fase más costosa y variable del recorrido BVH.

La arquitectura de NIF permite un rendimiento sustancialmente mejor en el cálculo del trazado de rayos secundarios para iluminación directa, llegando a reducciones de hasta un treinta y cinco por ciento en tiempo de cómputo en comparación con métodos tradicionales, sin sacrificar la calidad visual. Este avance se logra aprovechando plenamente unidades especializadas de multiplicación matricial presentes en GPUs modernas, como los Tensor Cores en Nvidia o los Matrix Cores en AMD. No obstante, NIF también presenta limitaciones claras. La dependencia de un entrenamiento en línea que se ajusta al punto de vista actual genera una carga computacional adicional y latencias que pueden dificultar su aplicación en escenarios dinámicos de alta complejidad. Además, el método aún necesita de BVHs convencionales para la generación de datos de referencia durante la fase de entrenamiento, por lo que no elimina completamente estas estructuras del flujo de trabajo.

Tampoco cubre todas las interacciones posibles de rayos en la escena, limitándose principalmente a rayos de sombra, mientras que el consumo de memoria, apesar de ser contenido, sigue siendo un factor a tomar en cuenta en sistemas con recursos restringidos. Con el objetivo de superar estas barreras, se desarrolló el concepto de la función de intersección neuronal localmente subdividida (Locally-Subdivided Neural Intersection Function, LSNIF), presentada en 2025. LSNIF redefine la estrategia al desacoplar el modelo del escenario específico, permitiendo que cada objeto tenga su propia red entrenada offline que puede ser reutilizada en diferentes escenas sin necesidad de entrenamiento adicional. Esta independencia del punto de vista y la iluminación impone una generalización amplia que hace que el sistema sea más práctico y escalable para diversas aplicaciones. LSNIF amplía el espectro funcional incluyendo no solo rayos de sombra, sino también rayos primarios y secundarios en etapas profundas del trazado, además de predecir propiedades físicas complejas como normales superficiales, posiciones de impacto, albedo e índices de materiales.

Esto enriquece significativamente las capacidades de representación geométrica y material, facilitando aplicaciones en renderizados de alta fidelidad e interactividad en tiempo real. Una innovación esencial de LSNIF es el manejo del problema conocido como aliasing de rayos mediante una voxelización local de la geometría del objeto. Al subdividir la superficie en cuadros volumétricos de baja resolución y emplear un algoritmo digital diferencial analizador (DDA) para intersectar rayos con estos voxeles, se incrementa la diversidad y precisión de las entradas a la red, evitando confusiones provocadas por la convergencia de rayos desde orígenes diversos. El sistema utiliza una codificación de rejilla dispersa y multinivel optimizada para almacenar características solo en los límites de los voxeles, optimizando la memoria y acelerando las consultas durante la inferencia. Cada red neuronal asociada a un objeto en LSNIF recibe vectores de características concatenados y predice múltiples resultados simultáneamente, lo que mejora la eficiencia tanto en memoria como en rendimiento frente a enfoques que utilizan redes separadas para cada propiedad.

Además, el soporte para múltiples materiales dentro del mismo objeto ofrece resultados visuales más realistas y versátiles. Los resultados experimentales demuestran que LSNIF puede generar imágenes con fidelidad visual muy alta, comparables a los métodos tradicionales basados en BVH, incluso en regiones de difícil manejo como bordes finos y sombras complejas. El método también mantiene su estabilidad y precisión ante cambios dinámicos en la escena, incluyendo variaciones en la iluminación y transformaciones geométricas. LSNIF no se restringe a entornos experimentales, sino que ha sido integrado exitosamente en pipelines estándar de trazado de rayos, como la API DirectX Raytracing (DXR) de Microsoft. En esta modalidad funciona como un shader de intersección personalizado que substituye la prueba contra primitivos geométricos tradicionales por una inferencia neuronal rápida para determinar la intersección implícita entre rayos y superficie.

Esto permite implementaciones realistas en tiempo real con escenas compuestas exclusivamente de modelos representados por LSNIF, sin necesidad de estructuras clásicas de BVH o buffers de geometría convencionales. El impacto de estas tecnologías abre un nuevo horizonte para la representación geométrica en gráficos por computadora, aproximando el potencial de modelos implícitos neuronales como ciudadanos de primera clase dentro de sistemas de renderizado comerciales y profesionales. La convergencia entre la eficiencia de hardware y la capacidad de aprendizaje automático ofrece caminos prometedores hacia renderizados cada vez más rápidos y fotorrealistas. En conclusión, la aplicación de redes neuronales para la representación geométrica en trazado de rayos representa una revolución en la forma en que se procesan y visualizan escenas tridimensionales. Desde la función de intersección neuronal original que optimiza el uso de GPUs modernas, pasando por la evolución hacia modelos localmente subdivididos y reutilizables, el campo está evolucionando rápidamente.

La combinación de soluciones como NIF y LSNIF apunta a superar las limitaciones de métodos tradicionales, abriendo la puerta a una nueva generación de motores de renderizado que aprovechan la inteligencia artificial para alcanzar niveles inéditos de rendimiento y calidad visual.