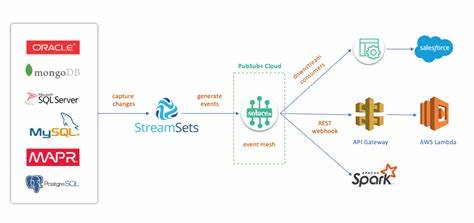

La Captura de Datos de Cambios, conocida como CDC por sus siglas en inglés, ha sido una técnica fundamental en la sincronización eficiente de bases de datos y la alimentación de sistemas de análisis en tiempo real. Sin embargo, con la creciente complejidad y volumen de datos en el panorama digital actual, los modelos tradicionales de CDC han mostrado limitaciones que exigen una arquitectura renovada y adaptada a las necesidades modernas. Resulta imprescindible analizar qué aspectos han funcionado a lo largo del tiempo y cuáles requieren una actualización profunda para optimizar la consistencia, la resiliencia y la eficiencia en los procesos de integración de datos. La importancia de la CDC radica en su capacidad para captar y transmitir cambios de forma instantánea, reduciendo la dependencia de procesos por lotes que suelen ser lentos y propensos a errores. Gracias a la CDC, las organizaciones pueden mantener sincronizados sus sistemas de bases de datos, alimentar almacenes de datos o lagos de datos y soportar aplicaciones analíticas en tiempo real de manera eficaz.

No obstante, la robustez de estos beneficios depende en gran medida de la arquitectura implementada para atender desafíos complejos como la gestión del almacenamiento de logs, la minimización de costos operativos y la adaptación a evoluciones en los esquemas de datos. Una dificultad recurrente en las arquitecturas CDC tradicionales es el manejo del almacenamiento del registro de transacciones, particularmente en sistemas como PostgreSQL que emplean el Write-Ahead Log (WAL). Cuando el CDC no gestiona adecuadamente el reconocimiento de transacciones procesadas, el crecimiento del WAL puede ser incontrolable, impactando negativamente en el rendimiento del sistema productivo y elevando los costos por almacenamiento excedente. Este problema se agrava en escenarios donde las tablas pequeñas reciben actualizaciones con poca frecuencia o cuando existen periodos prolongados de inactividad en destinos de datos, lo cual dificulta el vaciado oportuno del log y puede generar cuellos de botella. Asimismo, la capacidad de realizar retrocesos históricos o backfills se convierte en un dolor de cabeza para muchas organizaciones.

Cuando un nuevo destino de datos necesita integrarse, la falta de almacenamiento duradero de las transacciones obliga a reiterar consultas extensas a la base de datos productiva, aumentando la carga y poniendo en riesgo la estabilidad general. La automatización de estos procesos resulta clave para reducir la interferencia manual, mantener la integridad de los datos y hacer que la actualización o incorporación de destinos sea mucho más fluida. Otro desafío crítico que afecta la calidad y la continuidad de los flujos de datos es la evolución de los esquemas. Cambios en estructuras de tablas, campos o tipos de datos pueden desestabilizar las canalizaciones CDC, provocar inconsistencias o incluso fallos operativos. El manejo manual de estas transformaciones puede ser propenso a errores y consume recursos valiosos, lo que subraya la necesidad de arquitecturas que incorporen soporte automático para la detección y aplicación de modificaciones de esquema de forma segura y eficiente.

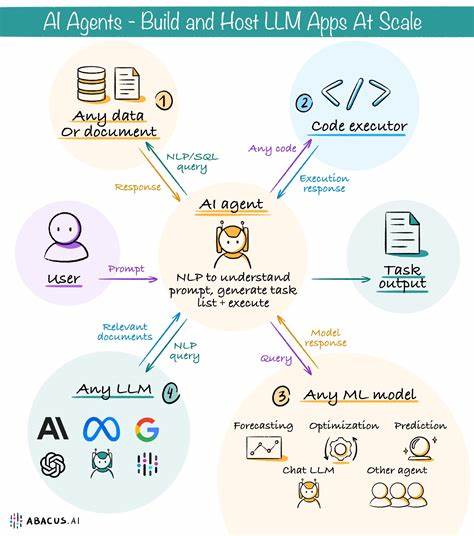

En este contexto, la arquitectura moderna para CDC debe integrar varios elementos esenciales. El reconocimiento oportuno de las transacciones procesadas es indispensable para controlar el crecimiento de los logs y evitar saturaciones. La captura continua de datos en tiempo real debe garantizar actualizaciones de baja latencia que soporten análisis dinámicos y aplicaciones que requieran información fresca. Los sistemas deben implementar mecanismos de señalización o «latidos» que monitoricen la salud del flujo y permitan mantener los logs limpios y sincronizados. La técnica del watermarking o huella temporal en la gestión de los datos facilita la visualización del progreso en la ingestión y el procesamiento, ayudando a restaurar procesos en caso de fallos y asegurando la consistencia general de la información replicada.

Más allá de estos elementos, la arquitectura debe contemplar el uso de almacenamiento duradero externo para los registros de transacciones, un factor crítico para mitigar el riesgo de pérdida de datos y permitir la repetición controlada de los eventos hacia múltiples destinos o para recuperación ante desastres. Una referencia destacada en la evolución hacia esta arquitectura CDC renovada es Estuary Flow, que representa una nueva forma de concebir la captura y materialización de datos cambiantes. En lugar de depender exclusivamente de infraestructuras tradicionales como Kafka combinados con Debezium, Estuary Flow apuesta por una arquitectura desacoplada que separa la captura en tiempo real, el procesamiento y el almacenamiento utilizando almacenamiento de objetos nativo en la nube. Esto permite a las organizaciones elegir su sistema de almacenamiento preferido, ya sea AWS S3, Google Cloud Storage o Azure Blob Storage, asegurando al mismo tiempo la soberanía y cumplimiento de políticas de datos. El uso de almacenamiento de objetos ofrece ventajas significativas en términos de escalabilidad, permitiendo manejar volúmenes masivos de datos sin las limitaciones típicas de sistemas de logs tradicionales.

Además, este enfoque aporta durabilidad y resiliencia superiores, garantizando que los registros CDC estén disponibles para reproducirse o recuperarse en cualquier momento. La capacidad de reproducir datos desde este almacenamiento de objetos de forma independiente al sistema de origen minimiza la carga sobre las bases de datos productivas y simplifica la integración continua con nuevos consumidores de datos. Operacionalmente, el modelo facilita la automatización de procesos clave, como la gestión de backfills y la evolución de esquemas, reduciendo la necesidad de intervención manual y permitiendo que los equipos de ingeniería se centren en la creación de valor a partir de los datos en lugar de gestionar infraestructuras complejas. En términos de costos, el almacenamiento de objetos presenta una alternativa eficiente frente a los altos gastos asociados con la replicación duradera y la red interzona que requieren otras soluciones basadas en Kafka o similares. El panorama de opciones para implementaciones CDC incluye tanto arquitecturas tradicionales como las basadas en Debezium y Kafka, como soluciones modernas y gestionadas como Estuary Flow.

La arquitectura con Debezium es conocida por su flexibilidad y fuerte comunidad, pero enfrenta retos importantes relacionados con la complejidad operacional, la necesidad de componentes múltiples y limitaciones en el soporte nativo de características vitales como backfills automáticos o manejo avanzado de esquemas. Por otro lado, Estuary Flow emerge como una propuesta revolucionaria que automatiza numerosos aspectos operativos, ofreciendo escalabilidad y capacidades en tiempo real con un menor esfuerzo de ingeniería. Si bien puede presentar limitaciones para organizaciones con estrictos requisitos on-premise, la tendencia hacia despliegues privados parece estar encaminada a resolver estas inquietudes. La adopción de una arquitectura CDC moderna representa una apuesta clave para las organizaciones que buscan incrementar la fiabilidad, transparencia y eficiencia en sus flujos de datos. Más allá de la tecnología, implica comprender y diseñar soluciones que equilibren el control operacional, la escalabilidad y el cumplimiento normativo, especialmente en áreas sensibles como la auditoría y la capacidad de hacer «time travel» para análisis históricos y resolución de incidencias.

El futuro de la integración de datos probablemente estará marcado por arquitecturas que promuevan la independencia de los sistemas de origen, almacenamiento duradero y flexible, así como por la automatización avanzada para minimizar errores humanos y acelerar la incorporación de nuevos flujos. Las organizaciones que adopten estos enfoques estarán mejor posicionadas para sacar partido a sus datos en un mundo cada vez más exigente y competitivo, asegurando la integridad, disponibilidad y usabilidad de la información en todos sus ecosistemas digitales.