Durante décadas, la protección del código fuente ha estado estrechamente ligada a la prevención de copias directas. En el mundo del desarrollo tradicional, el licenciamiento fue la herramienta fundamental para garantizar que los creadores originaless tuvieran control sobre cómo se reutilizaba su trabajo, evitando la reproducción no autorizada que podría dañar sus derechos y perjuiciar a la comunidad de software. Sin embargo, con la llegada de la inteligencia artificial (IA) aplicada a la programación, esta dinámica ha experimentado un cambio radical. La IA no se limita a copiar fragmentos exactos de código, sino que transforma, adapta y genera nuevas versiones basadas en patrones y estructuras aprendidas. Esta evolución pone en jaque el modelo de licenciamiento tradicional y abre un campo legal y ético lleno de interrogantes.

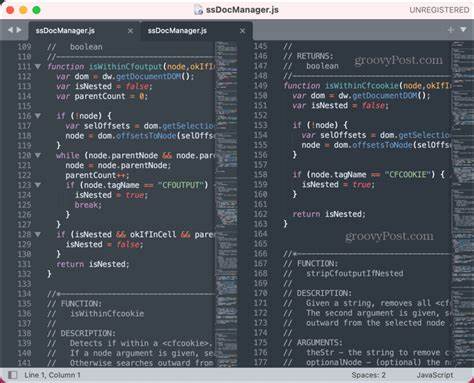

Antes del auge de la IA, los desarrolladores solían enfrentar la tarea de reutilizar código bajo estrictas reglas. Licencias como GPL, MIT o Apache definían con precisión qué estaba permitido y qué no, reforzando un ecosistema donde la atribución y el respeto al trabajo original eran fundamentales. Evidentemente, el copiar código sin respetar estas licencias podía culminar en demandas y sanciones, por lo que muchas organizaciones establecieron departamentos legales especializados para no entrar en conflictos judiciales. Este contexto brindaba una seguridad relativa, pues existía una línea clara entre inspiración y copia. Sin embargo, el paradigma ha cambiado con herramientas inteligentes como GitHub Copilot, ChatGPT o Claude, capaces de analizar grandes volúmenes de código y generar soluciones nuevas sin replicar literalmente el texto fuente.

El proceso de creación de código ahora se entiende más como una adaptación que como una simple transferencia. Esto genera un panorama donde la distinción entre obra derivada y creación original se vuelve difusa, complicando la aplicación directa de licencias tradicionales. Consideremos un caso donde un desarrollador introduce código cubierto por la licencia GPL en una IA, que luego produce un código funcionalmente similar pero estructuralmente diferente y con otro estilo sintáctico. ¿Debería este código luego cumplir con las obligaciones de la GPL? La perspectiva legal no ofrece aún una respuesta definitiva, lo que genera incertidumbre y debate en las comunidades jurídicas y tecnológicas. La clave del asunto radica en la interpretación del derecho de autor, que protege la expresión concreta de ideas, no las ideas en sí mismas.

Cuando una IA extrae patrones y técnicas para desarrollar código nuevo, no copia literalmente sino que genera variantes que podrían calificarse como suficientemente originales. Si el resultado final se aleja de la estructura del código base, podría no ser considerado una obra derivada, evitando así los vínculos con las licencias anteriores. Sin embargo, la experiencia no es tan sencilla respecto al proceso de entrenamiento de estas inteligencias. Si una IA ha sido entrenada con código bajo licencia GPL, existe la cuestión de si esa información “contamina” o impone restricciones a los códigos que genere luego. Algunos expertos argumentan que, dado que los modelos estadísticos aprenden patrones generales en lugar de memorizar textos exactos, se mantiene una distancia suficiente para considerar que no se copian contenidos sujetos a licencias.

Otros, en cambio, defienden que el espíritu del licenciamiento abierto debe extenderse para incluir estas creaciones automatizadas. Un caso emblemático es el de GitHub Copilot, que generó una ola de discusión tras su lanzamiento. Al estar entrenado con una base significativa de código GPL disponible públicamente, muchas de sus sugerencias compartían similitudes con esos proyectos. La Free Software Foundation sostuvo que, por esta razón, existía una obligación para que el código generado también cumpliera con GPL, mientras que GitHub defendió la posición de que los resultados eran suficientemente transformativos y por ende independientes de las licencias originales. Esta controversia aún está sin resolver y será un tema central a medida que la generación automática se consolide en el desarrollo de software.

Más allá de los aspectos legales, la integración de la IA en la programación abre también consideraciones éticas y prácticas importantes. Emplear código propietario como insumo para entrenar IA puede suponer una falta de respeto hacia los derechos y la intención original de los creadores. Aunque pueda defenderse desde el punto de vista jurídico, la comunidad de desarrolladores debe reflexionar sobre la transparencia en el uso de estos modelos y la necesidad de reconocimiento o compensación. Adicionalmente, aunque la IA puede acelerar la producción e incluso optimizar el código, no es infalible. Los errores o vulnerabilidades introducidos por un asistente automatizado son una realidad, y sin una comprensión sólida por parte del programador pueden pasar desapercibidos, afectando la calidad y seguridad del software.

El factor humano sigue siendo esencial para validar, revisar y mejorar lo generado. La discusión sobre cadenas de licenciamiento es otra dimensión crítica. Si una IA es entrenada con código abierto, algunos temen que sus productos deban heredar esas condiciones, mientras que otros afirman que la naturaleza de la inteligencia artificial y el aprendizaje automático rompe con los conceptos existentes de derivación. Algunos visionarios, como John Perry Barlow en su «Declaración de Independencia del Ciberespacio», ya vislumbraron que las industrias basadas en la información podrían quedar obsoletas si insistieran en mantener estructuras legales rígidas sobre la creatividad en la red. La IA, en este sentido, se presentan como un paso más hacia un entorno donde la innovación se nutre de un flujo libre de ideas y generación colectiva.

Este cambio invita a repensar el significado mismo de la propiedad intelectual y a diseñar políticas que favorezcan un equilibrio entre la protección de los derechos y la libertad creativa. En lugar de intentar controlar cada fragmento copiado o adaptado, la atención podría centrarse en fomentar la atribución correcta, la transparencia en la contribución y la colaboración abierta entre comunidades de desarrolladores. Mirando hacia el futuro, tanto empresas como programadores deben mantenerse atentos a la evolución del marco legal y a las prácticas recomendadas para el uso de IA en programación. Desarrollar políticas internas claras y fomentar el diálogo abierto sobre la ética y el respeto en la inteligencia artificial serán claves para evitar conflictos y aprovechar plenamente las ventajas de estas tecnologías. La revolución que trae la inteligencia artificial al mundo del código es un punto de inflexión en la historia del software.

No solo cambia cómo se crea el código, sino que desafía las bases legales y culturales que hasta ahora han definido la propiedad intelectual en la programación. En este nuevo escenario, la capacidad de adaptación, la comprensión profunda y la colaboración serán los pilares de un desarrollo tecnológico próspero y justo. El futuro del código requiere no solo máquinas inteligentes, sino también comunidades conscientes y responsables.