La inteligencia artificial (IA) se ha convertido en el eje central de innovación dentro del sector tecnológico. Cada vez más, empresas impulsan su integración en productos y servicios, con la promesa de transformar la manera en que vivimos, trabajamos y nos comunicamos. Sin embargo, a pesar del entusiasmo por parte de las compañías, existe una división creciente: muchos usuarios muestran un marcado rechazo hacia la IA, algo que las mismas empresas parecen no comprender en su totalidad. ¿Por qué ocurre esto? ¿Qué motiva esa aversión que no siempre está vinculada a las preocupaciones clásicas previstas? Una mirada crítica revela que el problema va más allá del miedo a la dominación robótica o a un escenario distópico de ciencia ficción. Desde hace tiempo, y sobre todo tras encuestas y estudios de opinión entre desarrolladores y usuarios, se observa un patrón en las respuestas negativas hacia la IA.

Lo llamativo es que las opciones prediseñadas para expresar inquietudes suelen girar en torno a nociones poco fundamentadas como el temor a películas sensacionalistas o a una eventual singularidad tecnológica que nunca llega. Sin embargo, las preocupaciones reales relacionadas con la ética, el impacto social y la privacidad no se reflejan correctamente en esos espacios. Esa desconexión entre lo que los usuarios sienten y lo que las empresas asumen es una de las causas por las que el descontento permanece inexplicado para muchos dentro del sector. Una crítica recurrente sobre la IA que muchos usuarios comparten tiene que ver con los efectos socioculturales y económicos que la tecnología puede desencadenar. La IA, más que ser un peligro por sí misma, propicia escenarios donde se fomenta la conducta antisocial, se amplía la desinformación, se generaliza la pornografía no consensuada y se desplazan industrias enteras sin dar alternativas viables a quienes dependen de ellas para su sustento.

Estas consecuencias no surgieron accidentalmente, sino que están directamente vinculadas a cómo las estructuras de incentivos dentro de la sociedad y las empresas moldean las conductas de las personas. Cuando se altera la dinámica en función de beneficios económicos o tecnológicos sin considerar profundamente el impacto humano y social, el resultado puede ser devastador para muchas comunidades. Además, un elemento fundamental en esta brecha de comprensión es la falta de empatía y respeto que algunos entusiastas y desarrolladores de IA manifiestan hacia los usuarios y profesionales, especialmente hacia artistas y creadores. La idea de que las tecnologías generativas “democratizan” el proceso creativo ignora las luchas reales que atraviesan los sectores creativos frente a la automatización y la erosión de sus ingresos y propiedad intelectual. Esta postura no solo deshumaniza el trabajo artístico sino que alimenta una alienación cultural, contribuyendo al rechazo popular.

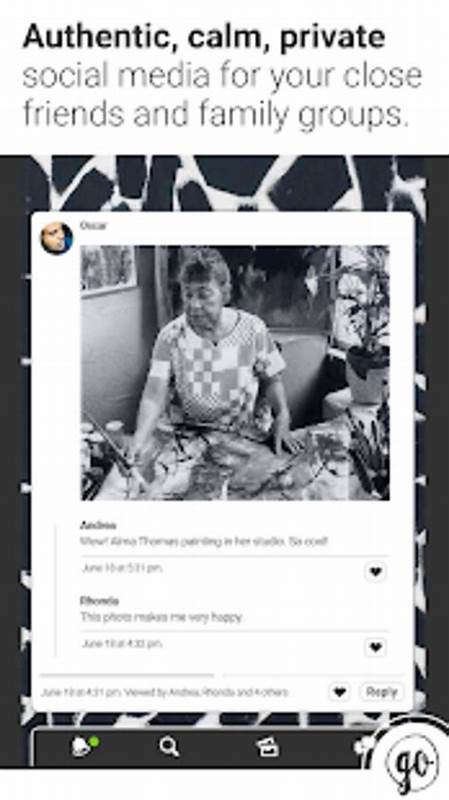

Otra dimensión crítica que no se suele comunicar con claridad desde las empresas es la relacionada con la privacidad y la seguridad. La introducción de funciones de IA en aplicaciones que antes garantizaban el respeto a la confidencialidad del usuario —por ejemplo, los servicios de mensajería cifrada de extremo a extremo— representa una amenaza tangible. Cuando funciones automáticas requieren que los datos personales sean transmitidos a servidores en la nube para procesamiento, se pierde la protección que brindan constituciones o leyes en distintos países, exponiendo a los usuarios a potenciales vulnerabilidades legales y personales. El uso de modelos lingüísticos avanzados para analizar conversaciones incrementa el riesgo de malinterpretaciones y errores, conocidos popularmente como “alucinaciones” de la IA, lo que puede traducirse en consecuencias perjudiciales para personas inocentes. Esto demuestra que el problema no se limita a fallos tecnológicos aislados sino que está embebido en el ecosistema legal, social y tecnológico que rodea a la aplicación de estas innovaciones.

Asimismo, el peligro no reside exclusivamente en inteligencias artificiales avanzadas o hipotéticas, sino en la confluencia de tecnologías accesibles y mal usadas. Por ejemplo, la combinación de modelos locales que perfilan psicológicamente a las personas con software malicioso autorreplicante podría dar lugar a escenarios catastróficos, imposibles de mitigar sólo con medidas tradicionales de seguridad o capacitación corporativa. La imaginación científica ficción deja de ser algo lejano cuando se considera la realidad tecnológica actual y la falta de regulación eficaz y ética. Ante estas inquietudes, existe un llamado claro a las empresas y desarrolladores para implementar los sistemas de IA con un enfoque basado en el consentimiento y la confianza. Optar por características de IA que estén desactivadas por defecto y que solo se activen si el usuario lo decide voluntariamente es una demanda legítima y razonable.

Este tipo de prácticas no buscan frenar el avance tecnológico, sino crear un entorno donde las personas puedan elegir entre utilizar o no estas funciones sin sentirse forzadas o espiadas. Es comprensible que desde la perspectiva de las compañías la métrica de interacción pueda sufrir al aplicar opciones opt-in, pero quienes usan activamente las funcionalidades de IA serán usuarios verdaderamente interesados, reduciendo fricciones y frustraciones innecesarias. La experiencia histórica del sector tecnológico está llena de ejemplos donde la imposición de tecnologías bajo esquemas poco transparentes produjo rechazo, desconfianza y pérdidas a largo plazo. Aprender de esos casos es vital para no repetir errores que socavan la relación con los consumidores. En definitiva, la aparente falta de comprensión de las empresas tecnológicas sobre el rechazo a la IA no se debe a una simple ignorancia, sino a un problema estructural que combina falta de empatía, prioridades equivocadas y ausencia de diálogo abierto con la sociedad.