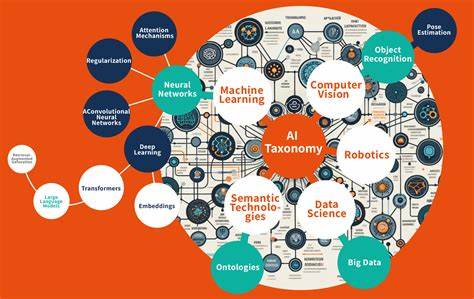

En el campo de la inteligencia artificial (IA), la gestión y transformación de datos representa un desafío fundamental para optimizar el desarrollo de modelos y su rendimiento en producción. La correcta aplicación y clasificación de las transformaciones de datos no solo impacta la eficiencia del sistema, sino también la calidad y reutilización de las características o features que alimentan a los modelos de aprendizaje automático. Por ello, comprender la taxonomía de las transformaciones de datos en sistemas de IA resulta esencial para cualquier profesional que busque maximizar el valor de sus datos y evitar errores comunes en la implementación de pipelines de datos para IA. La transformación de datos en IA puede dividirse en diferentes categorías que varían según su naturaleza y propósito, y que condicionan la forma en que se reutilizan en distintos modelos. Esta clasificación permite identificar qué tipo de transformación es adecuada según el contexto de uso, además de facilitar la detección y prevención de problemas como el sesgo entre las fases de entrenamiento e inferencia.

En esencia, la taxonomía contempla tres grandes grupos: transformaciones independientes del modelo, dependientes del modelo y bajo demanda. Las transformaciones independientes del modelo comprenden aquellas operaciones de procesamiento de datos que generan características reutilizables para múltiples modelos sin que su resultado dependa de los parámetros de entrenamiento de un modelo en particular. Este tipo de transformaciones suele ser gestionado y ejecutado por data engineers en pipelines de características, y abarca técnicas conocidas como agregaciones, filtrados, binning, entre otros. Por ejemplo, calcular el gasto total de un cliente en la última semana constituye una característica model-independent que puede alimentar diversos modelos que trabajen con comportamiento de clientes. Una de las ventajas más importantes de estas transformaciones es la creación de datos que son independientes de la muestra de entrenamiento.

Esto permite almacenarlas en feature stores o almacenes de características, desde donde pueden ser accedidas y reutilizadas por diferentes proyectos o modelos, reduciendo la redundancia y los costos asociados a la elaboración repetitiva de las mismas características. Por otro lado, las transformaciones dependientes del modelo abarcan las operaciones que se realizan teniendo en cuenta parámetros derivados del conjunto de datos de entrenamiento específico de un modelo. Estas transformaciones suelen involucrar normalización, escalado, codificación de variables categóricas, imputación de valores faltantes, tokenización de textos, entre otras técnicas que afectan directamente el rendimiento individual de un modelo. Este grupo de transformaciones no produce características reutilizables para otros modelos debido a su dependencia directa en los parámetros particulares del entrenamiento, como la media y desviación estándar utilizada en una normalización. Un caso típico es la tokenización en modelos de lenguaje natural, donde cada modelo posee su propio vocabulario y reglas de tokenización que diferencian sus transformaciones de forma exclusiva.

La importancia de mantener la coherencia de estas transformaciones en las fases de entrenamiento e inferencia es crucial para evitar lo que se conoce como un sesgo online-offline o sesgo entre entrenamiento y producción. Si durante la inferencia se aplican transformaciones distintas a las que se usaron en el entrenamiento, los resultados pueden ser erráticos o inesperados. Para evitarlo, muchas soluciones incluyen pipelines que ejecutan estas transformaciones de manera uniforme antes y durante la predicción en producción. Finalmente, las transformaciones bajo demanda o on-demand se refieren a aquellas que requieren datos que sólo están disponibles en el momento de la solicitud de inferencia en tiempo real. Estas transformaciones no pueden ser precalculadas durante los procesos offline y suelen estar ligadas a parámetros recibidos directamente en la petición, como la ubicación geográfica momentánea de un usuario o algún dato específico del contexto actual.

El uso de transformaciones on-demand permite ofrecer inferencias más precisas y adaptadas al contexto, combinando las características previamente calculadas en el feature store con información inmediata para generar datos más ricos y específicos. Asimismo, pueden ser utilizadas en procesos batch para retroalimentar características nuevas a partir de datos históricos, mejorando la calidad del entrenamiento de futuros modelos. Las soluciones modernas de feature store reconocen la necesidad de soportar esta complejidad en las transformaciones y, por ello, algunas como Hopsworks han desarrollado un soporte integral para toda esta taxonomía. El enfoque de integrar transformaciones model-independent, model-dependent y on-demand dentro de una misma plataforma facilita la administración coherente de datos, reduciendo la posibilidad de sesgos y aumentando la eficiencia operativa. Sin embargo, no todos los feature stores sostienen esta versatilidad.

Muchos sólo soportan transformaciones independientes del modelo, limitando las opciones para la reutilización de datos en escenarios que requieran transformaciones especializadas y dinámicas. Algunos proveedores aplican transformaciones on-demand solo como funciones en la inferencia, pero sin una infraestructura que permita su inclusión en las pipelines offline o su reutilización en varios modelos. Una práctica común es desacoplar las transformaciones model-dependent para que se definan y empaqueten junto con el modelo, por ejemplo, a través de pipelines de Scikit-Learn o capas de preprocesamiento en frameworks como TensorFlow y PyTorch. Esto garantiza que el mismo proceso de transformación se aplique tanto al entrenar como al hacer predicciones, conservando la coherencia y evitando sesgos. Pese a estas ventajas, las transformaciones model-dependent pueden llegar a ser costosas en términos computacionales y afectar la utilización de hardware especializado como GPUs, ya que a menudo requieren CPU para procesar los datos.

En escenarios con grandes volúmenes de datos, es recomendable aplicar estas transformaciones en pipelines que produzcan datasets de entrenamiento ya preparados, optimizando así el proceso de entrenamiento. Es fundamental también entender la problemática que emerge cuando las transformaciones on-demand no cuentan con un feature store que las soporte adecuadamente, ya que esto implica cargas sustanciales en la generación de datasets de entrenamiento debido al cómputo repetido de transformaciones al procesar grandes cantidades de datos históricos. Tal situación frena la capacidad del equipo de ciencia de datos para iterar rápidamente y mejorar sus modelos. La evolución de las arquitecturas de IA apunta a una integración más estrecha entre las diferentes fases del ciclo de vida de datos y modelos, permitiendo que las transformaciones bajo demanda se registren y ejecuten de forma consistente tanto en modo batch (para backfilling) como en tiempo real, alineando las necesidades de rendimiento con la calidad y coherencia del modelo. En resumen, la taxonomía para las transformaciones de datos en sistemas de IA representa una herramienta clave para diseñar y operar sistemas escalables, eficientes y libres de sesgos.

Al distinguir claramente entre transformaciones model-independent, model-dependent y on-demand, los equipos pueden asignar correctamente cada tarea al pipeline adecuado, asegurar la reutilización efectiva de características y mantener la integridad del proceso desde la obtención inicial de datos hasta la inferencia en producción. Entender y aplicar esta taxonomía permite no solo optimizar recursos y tiempo sino también garantizar resultados confiables y replicables en los modelos de inteligencia artificial. Además, impulsa la adopción de soluciones de feature store que soportan plenamente estas categorías, facilitando el desarrollo de AI modernas y robustas. Así, los profesionales que dominan estas prácticas estarán mejor preparados para enfrentar los retos de la gestión de características en sistemas inteligentes cada vez más complejos y demandantes.

![Michael Saylor Bitcoin for Corporations 2025 Keynote Speech [video]](/images/F1E65633-1948-4DAA-AEB7-B21CDD5D2DBD)