En el panorama actual de la inteligencia artificial, la competencia entre modelos propietarios y de código abierto se intensifica cada día. Durante años, el sector tecnológico ha visto cómo el software de código abierto ha ganado terreno frente a soluciones propietarias, ofreciendo rapidez, colaboración y accesibilidad. Sin embargo, la naturaleza efímera y dinámica de los modelos de IA plantea nuevos retos y oportunidades que difieren significativamente del software tradicional. La técnica conocida como Chain-of-Thought (CoT) o razonamiento en cadena ha emergido como un recurso clave que las compañías con infraestructuras centralizadas están utilizando para transformar la forma en la que se desarrollan y despliegan sus modelos, incentivando una ventaja competitiva que va mucho más allá de las capacidades brutas del algoritmo. En 2023, un documento interno filtrado de una empresa líder en IA generó revuelo al señalar que ni ellos ni otros gigantes tecnológicos podían competir efectivamente con modelos de IA de código abierto.

Este hecho avivó una discusión sobre el futuro del desarrollo en inteligencia artificial, con expertos comparando la evolución de la IA con la trayectoria del software abierto que, con el tiempo, fue absorbiendo mercado. No obstante, a diferencia del software convencional que puede permanecer relevante durante décadas, los modelos de IA, por la velocidad a la cual se vuelven obsoletos, enfrentan una obsolescencia acelerada en cuestión de meses. Esto obliga a una reevaluación constante, en la que la innovación continua y la optimización son indispensables. Uno de los grandes retos es la competencia en términos de escalabilidad y actualización rápida. Los modelos open source, como el R1 lanzado por DeepSeek, muestran una agilidad notable: en pocas horas una nueva versión puede estar integrada en múltiples plataformas y servicios.

Esta capacidad de despliegue inmediato y el acceso gratuito crean una presión constante para que las compañías propietarias justifiquen sus inversiones masivas. Sin embargo, donde radica su fortaleza no es simplemente en presentar un modelo más avanzado, sino en cómo gestionan y optimizan su infraestructura y el uso en función de patrones de usuario comunes. La técnica Chain-of-Thought ha modificado considerablemente la relación entre los recursos dedicados a entrenamiento y los dedicados a inferencia del modelo. Originalmente, los modelos invertían mucho esfuerzo computacional en un entrenamiento exhaustivo para internalizar funciones de razonamiento complejas, con tiempos de inferencia cortos y relativamente económicos. Con CoT, la premisa es trasladar una parte del razonamiento al momento de la consulta, haciendo que la inferencia sea más pesada pero permitiendo que el entrenamiento pueda ser menos intensivo.

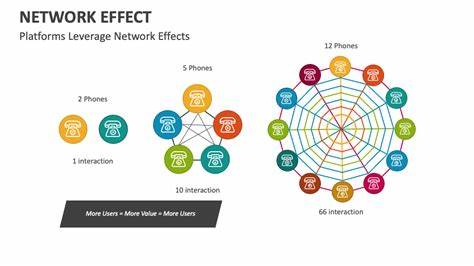

Esta modificación también abre la puerta a nuevas optimizaciones centradas en la reutilización del «proceso de pensamiento» para consultas similares. Un usuario podría hacer una pregunta relacionada con las características de una araña y otro usuario realizar un cuestionamiento que responde a la misma lógica subyacente. Mediante la captura y el almacenamiento de los pasos intermedios realizados para responder a una consulta, las compañías pueden reutilizar estos «razonamientos cacheados» para acelerar futuras respuestas, reduciendo costes y latencia. Esta reutilización del razonamiento no solo representa una innovación técnica, sino una manera inteligente de sacar provecho a la concentración de usuarios de un mismo proveedor sobre infraestructuras comunes, generando lo que se llama un efecto de red. Además, se ha desarrollado el concepto de «minting» o creación de tokens de razonamiento especializados.

Al identificar patrones recurrentes en cadenas de inferencia compleja, se crea un token condensado que encapsula todo el razonamiento detrás de ese patrón, permitiendo que la ejecución futura de consultas similares sea mucho más rápida y económica. Este enfoque convierte el razonamiento previamente costoso en un atajo operativo que mantiene la calidad y precisión sin el gasto repetitivo de recursos. El impacto de estas técnicas es significativo. Por un lado, aceleran la evolución y mejora de la capacidad de los modelos al reducir el tiempo y coste asociado a la inferencia. Por otro, fomentan un ecosistema en el que modelos desarrollados y optimizados centralizadamente pueden aprovechar la experiencia colectiva y el comportamiento agregado de los usuarios.

En definitiva, beneficia a aquellos proveedores que pueden mantener y explotar infraestructuras robustas, no solamente en términos tecnológicos, sino en la capacidad para gestionar y analizar grandes cantidades de datos derivados de la interacción simultánea de millones de usuarios. Esta estrategia también propone un cambio en el paradigma comercial de los servicios de IA. Mientras que los usuarios pueden cambiar fácilmente entre APIs de diferentes proveedores sin coste significativo, la acumulación y optimización continua de los procesos internos de inferencia ante patrones repetidos crea barreras difíciles de replicar para quienes operan con infraestructuras fragmentadas y modelos distribuidos. Por lo tanto, el valor no solo reside en la calidad del modelo, sino en cómo se gestionan los datos, se analizan los comportamientos y se reutilizan componentes del razonamiento en beneficio del usuario final y del proveedor a la vez. Es importante también destacar la aceleración en la mejora de las capacidades agenticas gracias a CoT.

Si tradicionalmente la capacidad de estos modelos se duplicaba en unos siete meses, la introducción de razonamientos reutilizables y técnicas de token especializado ha acelerado esta tasa a apenas cuatro meses, lo que significa una velocidad inédita en el avance tecnológico. Este ritmo obliga a pensar en infraestructuras no solo escalables, sino también adaptativas, con mantenimiento constante y procesos automatizados para incorporar nuevos tokens y patrones derivadas de las interacciones diarias. Por tanto, a pesar de que el desarrollo abierto continúa aportando innovación y acceso democratizado, las ventajas en la explotación inteligente de la infraestructura y la gestión de efectos de red pueden inclinar la balanza hacia los proveedores que apuesten por la centralización y optimización continua. La relación entre despliegue ágil, escalabilidad y eficiencia operativa será determinante para definir quién lidera la próxima generación de inteligencia artificial. En conclusión, la introducción y perfeccionamiento de técnicas como Chain-of-Thought y la reutilización de tokens especializados no solo mejoran el desempeño de los modelos de IA sino que también crean una nueva dimensión competitiva basada en la economía colectiva del razonamiento.

Mientras la comunidad open source continúa siendo vital para la innovación y experimentación, las empresas propietarias que logren consolidar sus usuarios y optimizar su infraestructura mediante estas estrategias tendrán un camino privilegiado en la competencia del futuro. La inteligencia artificial está entrando en una etapa en la que el valor reside tanto en la calidad técnica como en la arquitectura social y computacional que la sustenta.