En la era digital actual, la cantidad de información en formato de audio crece exponencialmente. Desde grabaciones de reuniones, llamadas telefónicas y mensajes de voz hasta podcasts y comandos de voz, la necesidad de transformar esos datos auditivos en información procesable se ha vuelto crucial. Sin embargo, extraer información estructurada de audios capturados no es una tarea trivial. Requiere un enfoque integral que combine la tecnología adecuada con estrategias de análisis precisas y eficientes. Una de las herramientas destacadas para la transcripción automática es OpenAI Whisper, un modelo capaz de convertir voz en texto de manera bastante precisa.

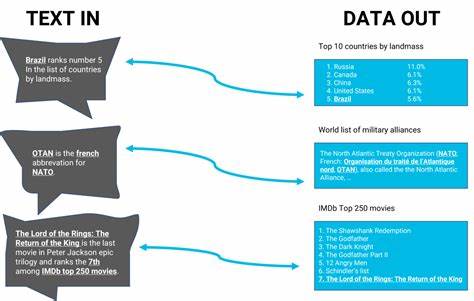

Utilizar Whisper como punto de partida permite transformar el contenido auditivo en una base textual accesible para posteriores análisis. No obstante, el verdadero desafío radica en dar sentido a esos textos y organizar la información en estructuras que permitan tomar decisiones o alimentar sistemas automatizados. Para lograr ese objetivo, es necesario definir claramente qué tipo de información queremos extraer. En muchos casos, existe un conjunto limitado de posibles "propósitos" o intenciones detrás de una solicitud o un mensaje hablado. Por ejemplo, una petición para solicitar días de licencia, un pedido de reunión o una instrucción técnica.

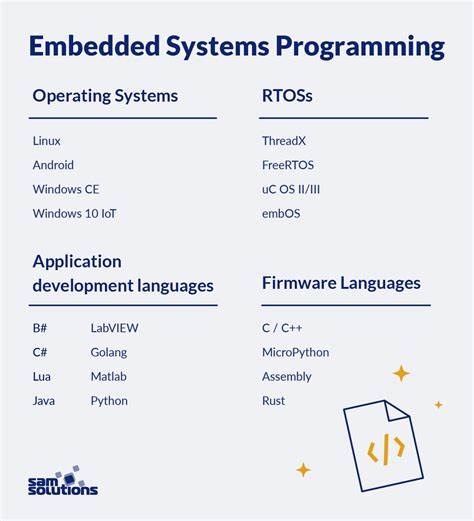

Cada propósito puede requerir una serie específica de datos, a menudo en forma de pares clave-valor, como fechas de inicio y fin en una solicitud de permiso. En dispositivos con recursos limitados, como aquellos que cuentan con una tarjeta gráfica NVidia GTX 1660 Super con 6GB de VRAM o menos, se debe buscar un equilibrio entre precisión y eficiencia. Las soluciones con modelos de lenguaje grandes (LLM) en pequeño tamaño, además de Whisper, ofrecen un enfoque adecuado. Estos modelos permiten analizar el texto generado y clasificarlo según el propósito identificado, extrayendo posteriormente la información relevante mediante técnicas de procesamiento de lenguaje natural (PLN). Entre las estrategias para extraer y estructurar datos se encuentran los enfoques basados en reglas y los modelos estadísticos o de aprendizaje automático.

Los métodos basados en reglas incluyen el uso de expresiones regulares, que permiten identificar patrones específicos dentro del texto, como fechas, nombres, ubicaciones o cantidades. Si bien estas técnicas pueden ser muy precisas para información bien definida, suelen requerir mantenimiento y ajustes constantes, especialmente con variaciones en el lenguaje natural. Por otro lado, los modelos de PLN como spaCy proveen herramientas sofisticadas para el análisis morfosintáctico, la tokenización, la identificación de entidades nombradas y la extracción de relaciones. Estas funcionalidades facilitan la identificación automática de elementos clave en el texto que corresponden a los datos requeridos. Además, spaCy y librerías similares permiten entrenar modelos personalizados que se adaptan a las necesidades específicas de cada proyecto.

Es importante tener en cuenta que la normalización de datos es una fase esencial. Cuando el audio se convierte en texto, la información como fechas puede presentarse en diversas formas, tales como "1 de noviembre" o "el primero del mes siguiente". Aplicar reglas y técnicas de normalización ayuda a convertir estas variaciones en formatos estándar, por ejemplo, ISO 8601 para fechas, facilitando su almacenamiento y análisis posterior. A pesar de todas estas herramientas y métodos, es común que el sistema enfrente ambigüedades o casos que no pueda resolver con total precisión. En estas situaciones, implementar un flujo de revisión humana puede ser beneficioso para garantizar la calidad de la información extraída.

Además, un sistema híbrido que combine automatización con intervención humana puede evolucionar con el tiempo a medida que se alimenta con más datos y casos. En cuanto al diseño del pipeline de extracción, comenzar con la conversión de audio a texto es crítico. Whisper es una opción notable por su rendimiento y accesibilidad. Seguir con una etapa de tokenización y análisis lingüístico mediante spaCy o herramientas similares permite organizar el texto en componentes que luego se pueden clasificar y mapear a las estructuras deseadas. Para clasificar la intención o propósito, se pueden entrenar clasificadores basados en técnicas de aprendizaje supervisado, alimentados con ejemplos etiquetados que representen los posibles propósitos.

Finalmente, la salida debe estructurarse en un formato estándar como JSON, lo que permite una fácil integración con otras aplicaciones y sistemas. Un ejemplo de resultado sería una representación en JSON con el campo “purpose” que indica la intención principal y el campo “data” que contiene las variables clave valor correspondientes. Este proceso no solo es relevante para proyectos personales o pequeñas empresas, sino también para desarrollos en atención al cliente, automatización de procesos internos y sistemas de información basados en voz. Con la democratización de herramientas de código abierto y hardware accesible, cada vez más profesionales y aficionados pueden implementar soluciones capaces de convertir audio en datos valiosos de forma confiable y económica. En conclusión, extraer información estructurada de audios capturados es una tarea que combina varias disciplinas tecnológicas.

Desde la transcripción con modelos como Whisper, pasando por el análisis de lenguaje natural con spaCy, hasta la normalización y clasificación basada en inteligencia artificial, las opciones son variadas y adaptables. Aprovechar estos recursos en dispositivos modestos resulta factible, siempre que se diseñe un pipeline integrado y eficiente. Este enfoque abre nuevas posibilidades para transformar la información auditiva en conocimiento aplicable, beneficiando a todo tipo de usuarios y entornos.

![ASML's Breakthrough 3-Pulse EUV Light Source [video]](/images/E70ED659-32CF-459E-BF7E-7595754B6E27)