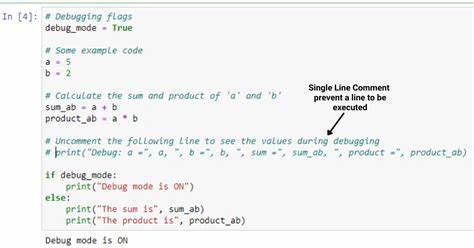

En el mundo de la optimización de código y compiladores, la técnica llamada 'inlining' es reconocida como una de las más poderosas y populares. Consiste en reemplazar una llamada a función por el cuerpo mismo de dicha función, eliminando así la sobrecarga asociada a la llamada. Pero, ¿qué pasaría si aplicáramos esta técnica a todas las funciones disponibles en un programa? ¿Qué consecuencias traería aplicarla sin restricciones? Este análisis nos permitirá comprender en profundidad las implicaciones, tanto positivas como negativas, de este enfoque. Primero, es fundamental entender qué es el inlining. Se trata de una optimización realizada principalmente en compiladores como LLVM y GCC, que busca mejorar el rendimiento al evitar saltos y llamadas que consumen ciclos de CPU.

Al sustituir la llamada con el propio código, se espera reducir la latencia y permitir otras optimizaciones más agresivas dentro del contexto donde se realiza la intercalación. Expertos reconocidos en la comunidad de compiladores, como Chandler Carruth, valoran el inline como la optimización más importante, pero advierten que debe aplicarse con moderación y criterio. Sin embargo, la tentación de aplicar inline a todo el código puede resultar atractiva para quienes buscan exprimir el rendimiento al máximo sin importar otros factores. Esta idea implica que cada función llamable se reemplaza directamente en su sitio, todo, sin excepciones salvo aquellos casos técnicamente imposibles. Al explorar las consecuencias reales, experimentos y estudios recientes han aportado evidencia valiosa sobre qué ocurre cuando se rompe esa moderación.

El primer impacto evidente es en los tiempos de compilación. Al incrustar cada función en todos los lugares donde se llama, el compilador debe procesar el mismo segmento de código varias veces. Esta duplicación directa puede multiplicar dramáticamente el tiempo que tarda en traducir el programa a código máquina. Por ejemplo, en casos prácticos con compiladores basados en LLVM, la compilación puede incrementarse hasta unas 25 veces comparado con configuraciones estándar. Esto no solo es un problema desde el punto de vista de la productividad del programador, sino que se refleja en mayores recursos computacionales necesarios para el proceso.

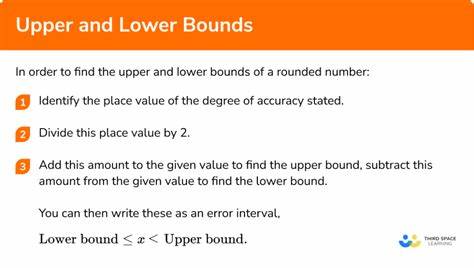

Relacionada con la compilación, está la cuestión del tamaño del ejecutable final. Al tener múltiples copias del mismo código por todas partes, el archivo generado crece proporcionalmente. En pruebas comparativas, ejecutables con inline total pueden ser hasta diez veces más grandes. Este aumento implica mayor espacio en disco y también repercute en la carga de memoria y el uso de cachés de instrucciones dentro de la CPU, lo que puede afectar negativamente la eficiencia a largo plazo. Un punto que no se puede pasar por alto es que algunas funciones no son susceptibles de ser inlined.

Específicamente, funciones recursivas o aquellas que usan argumentos variables, como va_start(), presentan dificultades técnicas que impiden su sustitución. En compiladores modernos, estas situaciones suelen detectarse y se les asignan atributos especiales para evitar que el inlining intente aplicarse, previniendo errores y caídas en la compilación. Aunque a primera vista el aumento del tamaño y del tiempo de compilación resultan negativos, la pregunta más importante se centra en el rendimiento en tiempo de ejecución. Sorprendentemente, las evidencias experimentales muestran que, en muchos casos, el rendimiento mejora levemente o se mantiene prácticamente igual. Esto se debe a que la eliminación de llamadas repetidas permite al optimizador realizar transformaciones que mejoran el código superficial, al tiempo que reduce la latencia por salto.

Por ejemplo, en pipelines de procesamiento de imágenes optimizados, versiones con todas las funciones inlineadas han demostrado tiempos de ejecución similares a los builds convencionales, incluso obteniendo pequeñas mejoras en promedio geométrico de rendimiento. Esta circunstancia desafía la creencia común de que inlinearlo todo empeorará la eficiencia en ejecución. Las razones por las que el rendimiento no empeora tanto incluyen que el compilador puede aprovechar mejor la proximidad de código y optimizar el uso de registros, evitar llamadas costosas y realizar fusiones de instrucciones. Sin embargo, estas ganancias pueden verse limitadas a código pequeño o mediano, ya que en proyectos muy grandes el tamaño descomunal del código resultante puede afectar negativamente a la caché de instrucciones y la administración de registros a largo plazo. Otro desafío importante relacionado con el inlining total es la complejidad técnica para lograr que los compiladores admitan esta forma excepcional de comportamiento.

Modificar internamente los mecanismos de decisión de inlining, conocidos como análisis de rentabilidad, no es trivial. Está íntimamente mezclado con la transformación del código y requiere un profundo conocimiento del compilador para evitar inconsistencias u errores, como caídas o problemas en funciones con argumentos variables. Por ejemplo, en LLVM es necesario intervenir en múltiples lugares del código fuente que controlan no solo la decisión de si se debe realizar inlining, sino también las condiciones para garantizar la viabilidad técnica. Intentos de forzar el inlining indiscriminado pueden provocar bloqueos o resultados inesperados. Para superarlo, es imprescindible integrar verificaciones que excluyan funciones no aptas y respetar atributos automáticos que el compilador asigna para proteger estos casos.

Este nivel de intervención demuestra que aunque la idea de inlinear todo suene sencilla, la realidad es que el ecosistema de compiladores está diseñado para optimizar conservadoramente y evitar desmadres que puedan poner en riesgo estabilidad y productividad. La edición casual o el uso indiscriminado del atributo always_inline sin rigor puede generar aumentos abusivos en compilación y tamaño, sin mejoras proporcionales para el usuario final. De hecho, figuras prominentes dentro de la comunidad de compiladores alertan sobre el uso indebido del atributo always_inline, recomendando usarlo solamente cuando haya evidencia clara de que la omisión de inlining es un error del compilador y mediante análisis rigurosos de métricas y comportamiento. No se trata de evitar la optimización, sino de usarla como una herramienta que requiere juicio y medidas. En resumen, probar la estrategia de inlinear todo revela que, aunque se incrementan sus peores efectos secundarios —tiempo de compilación y tamaño binario— en cuanto a rendimiento de ejecución no siempre estas penalizaciones se manifiestan.

Esto abre preguntas sobre si, en entornos donde el tiempo de compilación sea irrelevante y el almacenamiento abundante, convendría una agresividad mayor en el uso de inlining para exprimir cada ciclo de CPU. Para desarrolladores y entusiastas de la compilación, la conclusión práctica podría ser que se debe mantener el equilibrio: el uso puntual y meditado del inline puede potenciar el rendimiento, pero su aplicación ilimitada compromete la manejabilidad y escalabilidad del proyecto. Mientras tanto, el avance constante en técnicas de análisis de rentabilidad y soporte de atributos facilitará que en el futuro los compiladores adapten mejor sus decisiones dependiendo del contexto y no una regla fija. Finalmente, es importante destacar que estas investigaciones son parte de una línea creciente que explora hasta dónde pueden llegar las optimizaciones automáticas, especialmente con la llegada de técnicas basadas en aprendizaje automático que buscan superar limitaciones tradicionales. La comunidad continúa evaluando cómo combinar seguridad, rendimiento y eficiencia en entornos cada vez más complejos y heterogéneos.

En definitiva, la pregunta de qué sucede si inlinamos todo no tiene una respuesta binaria: en muchos escenarios funciona sin degradar el rendimiento, pero hacerlo indiscriminadamente acarrea costos importantes en otros aspectos. Cada proyecto debe valorar qué balance de optimizaciones se adaptan mejor a sus necesidades particulares, siendo el inlining una poderosa herramienta cuando se usa con conocimiento y prudencia.