Los modelos de lenguaje han revolucionado la manera en que las máquinas entienden y generan texto, facilitando aplicaciones desde la traducción automática hasta la asistencia personalizada en tiempo real. Sin embargo, detrás de estos modelos avanzados se encuentran complejas arquitecturas que permiten el manejo eficiente de grandes volúmenes de información, entre ellas mecanismos como Gather-and-Aggregate (G&A). Este mecanismo juega un papel esencial en la capacidad de los modelos para recuperar y sintetizar información relevante directamente del contexto, lo cual es crucial para la precisión en tareas algorítmicas y de comprensión profunda. Para comprender la importancia del mecanismo Gather-and-Aggregate, primero debemos recordar las diferencias fundamentales entre los Transformers y los modelos basados en estado de espacio (SSMs, por sus siglas en inglés). Mientras que los Transformers aprovechan su capacidad para atender a cada token del texto mediante mecanismos de atención que consideran todas las posiciones en una secuencia, los SSMs utilizan un estado recurrente fijo que limita la cantidad de información que se puede retener sobre el historial.

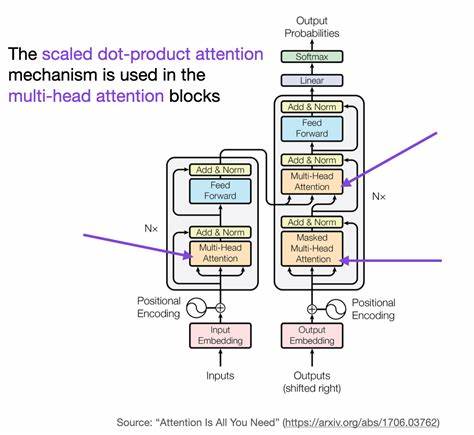

Esta limitación puede afectar significativamente su desempeño en tareas que requieren recuperar datos pasados con precisión, lo que se traduce en una brecha en habilidades entre ambas arquitecturas. El descubrimiento clave en investigaciones recientes es que, a pesar de sus diferencias estructurales, tanto los Transformers como los SSMs dependen de manera crítica de un mecanismo de recuperación de contexto similar: el Gather-and-Aggregate. En esencia, este mecanismo incluye dos componentes principales. En primer lugar, el Gather Head que se encarga de extraer piezas específicas de información relevante del contexto. En segundo lugar, el Aggregate Head que integra estos fragmentos en una representación unificada y coherente que el modelo puede utilizar para realizar predicciones o generar respuestas.

Lo notable es que estos componentes no funcionan dispersos en toda la red del modelo, sino que se concentran en un número pequeño y específico de “cabezas” de atención o unidades recurrentes que actúan como cuellos de botella críticos. Estos cuellos de botella implican que si alguna de estas cabezas de Gather o Aggregate es deshabilitada, el modelo pierde su capacidad para realizar correctamente tareas de recuperación contextual, lo que deteriora drásticamente su rendimiento. Por ejemplo, en pruebas con el modelo Llama-3.1-8B, desactivar un solo Gather Head pudo hacer que la precisión en una tarea conocida como MMLU cayera de un 66% a un 25%, una tasa cercana al azar. Este fenómeno evidencia que el rendimiento general del modelo no siempre refleja la completitud de su conocimiento, sino que puede estar limitado por la capacidad del mecanismo G&A para acceder y combinar datos del contexto.

Por lo tanto, incluso un modelo con un conocimiento vasto puede fallar en tareas específicas si las cabezas involucradas en la agregación y recopilación son defectuosas o tienen un funcionamiento inadecuado. Otro aspecto importante asociado a este mecanismo es cómo afecta la diferencia de rendimiento percibida entre los Transformers y los modelos SSM, especialmente en tareas complejas y dependientes del razonamiento y la comprensión. Mientras los Transformers exhiben patrones de atención agudos que permiten transiciones abruptas y precisas entre tokens clave, los SSMs tienden a generar patrones más suaves y graduales, lo que limita su habilidad para destacar información crítica en contexto. Al analizar este comportamiento a través del prisma de Gather-and-Aggregate, se entiende mejor por qué los SSMs tienen dificultades para igualar el desempeño de los Transformers en ciertos benchmarks relevantes como GSM8K (problemas matemáticos), BBH (evaluación de habilidades y conocimiento) y en tareas de comprensión de diálogos complejos. La falta de cabezas G&A efectivas en los SSMs implica que estos modelos no pueden realizar una agregación selectiva y concentrada de información, lo que termina afectando la coherencia y exactitud de las respuestas.

Este hallazgo ha llevado a la propuesta de modelos híbridos preentrenados que combinan las fortalezas de ambos enfoques. Estos modelos utilizan los SSMs para procesar secuencias largas de manera eficiente, mientras que incorporan capas de atención con mecanismos de Gather-and-Aggregate para fortalecer la habilidad de recuperar información contextual de forma precisa. De hecho, estudios muestran que reemplazar incluso una sola cabeza de Gather con una variante de atención puede mejorar significativamente el rendimiento en tareas de recuperación y otros benchmarks. En esta convergencia de arquitecturas, el mecanismo Gather-and-Aggregate actúa como un puente conceptual y funcional, ilustrando que la capacidad para recuperar y sintetizar información relevante del contexto es fundamental para la inteligencia de los modelos de lenguaje. No se trata únicamente de la cantidad de información almacenada, sino de la manera en que el sistema selecciona, combina y representa esa información al enfrentarse a problemas diversos.

Además de sus implicaciones para el diseño de modelos, el entendimiento del mecanismo G&A abre nuevas vías para optimizar y personalizar modelos de lenguaje en aplicaciones prácticas. Por ejemplo, podría guiar el desarrollo de técnicas de poda o ajuste fino que identifiquen y refuercen las cabezas más críticas para la tarea específica, mejorando la eficiencia computacional sin sacrificar la calidad. También señala la importancia de desarrollar nuevas arquitecturas que maximicen la efectividad de estos cuellos de botella en la recuperación contextual. Finalmente, la investigación sobre Gather-and-Aggregate tiene un profundo impacto en nuestra comprensión de la inteligencia artificial y el procesamiento del lenguaje natural. Muestra cómo un enfoque basado en una combinación eficiente de extracción y agregación de información puede superar limitaciones estructurales y abrir caminos para modelos más robustos, adaptativos y contextualmente conscientes.

En conclusión, el mecanismo Gather-and-Aggregate representa una pieza clave en el funcionamiento y evolución de los modelos de lenguaje modernos. Su influencia no solo explica diferencias de rendimiento entre arquitecturas, sino que también ofrece oportunidades para innovar y optimizar estos sistemas, acercándonos cada vez más a una verdadera comprensión automática del lenguaje humano.