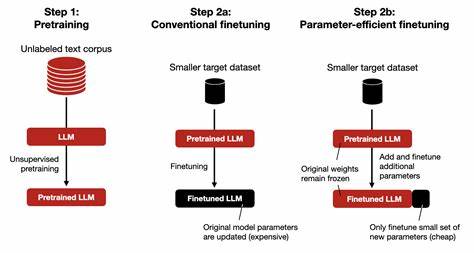

En el creciente mundo de la inteligencia artificial, la precisión y la personalización de los modelos de aprendizaje automático se han vuelto cruciales para alcanzar resultados óptimos. El fine-tuning, o ajuste fino, es una práctica que consiste en adaptar modelos preentrenados a necesidades específicas mediante conjuntos de datos diseñados expresamente para ese fin. Crear estos conjuntos de datos de manera eficiente y personalizada puede marcar la diferencia entre un proyecto exitoso y uno que no cumple con las expectativas. Tradicionalmente, la obtención y preparación de conjuntos de datos para fine-tuning es una tarea que puede extenderse durante semanas o incluso meses, consumiendo recursos valiosos y retrasando la capacidad de una organización para implementar soluciones basadas en inteligencia artificial. Sin embargo, un cambio significativo está ocurriendo en la forma en la que se desarrollan estos conjuntos de datos: la posibilidad de construirlos a medida en tan solo 24 a 72 horas.

Este avance representa una revolución en la industria, ya que permite a los equipos técnicos acelerar notablemente el ciclo de vida de sus proyectos de IA. Al contar con datos personalizados rápidamente, los modelos pueden ser ajustados con precisión para reflejar contextos específicos, sectores puntuales o problemas únicos del negocio, generando así modelos más efectivos y relevantes desde el punto de vista operativo. El proceso de creación de datasets personalizados para fine-tuning implica una serie de etapas que van desde la recolección de datos crudos, su limpieza y preprocesamiento, hasta la anotación rigurosa que asegura que el modelo aprenda del contenido correcto. Contar con soluciones que agilicen cada uno de estos pasos es fundamental para lograr ciclos de desarrollo comprimidos. Además, la personalización en la generación del dataset puede incluir variables tales como la selección de textos, imágenes o señales que reflejen fielmente el dominio deseado, la integración de fuentes de datos internas o externas, y la adaptación a las regulaciones de privacidad y seguridad que aplican en cada jurisdicción.

Esto garantiza que el modelo entrenado no sólo sea eficiente en su desempeño, sino también ético y respetuoso con las normativas. Las ventajas de disponer de datasets personalizados en corto tiempo son numerosas. La primera y más evidente es la reducción significativa en el tiempo de desarrollo de modelos a medida, lo que se traduce en una mayor agilidad para responder a oportunidades de mercado o necesidades cambiantes. En segundo lugar, se mejora la calidad de los resultados, ya que los datos incluyen contextos y matices específicos que modelos genéricos pueden pasar por alto. Esto también promueve una mayor confianza de los usuarios y stakeholders en la tecnología debido a su mayor precisión.

Por otro lado, la capacidad de crear datasets rápidamente fomenta la experimentación y la innovación dentro de las organizaciones. Los equipos pueden probar diferentes configuraciones, adaptar modelos a múltiples nichos o conjuntos de datos simultáneamente, y optimizar sus soluciones sin la necesidad de grandes inversiones iniciales en infraestructura o tiempo. Esta flexibilidad contribuye a democratizar el acceso a técnicas de inteligencia artificial avanzada. Sin embargo, este proceso también presenta retos. Para construir conjuntos de datos eficientes en tiempos tan cortos, es indispensable contar con tecnologías de última generación, sistemas automatizados para la recolección y procesamiento, así como expertos en la materia que garanticen la calidad y relevancia del contenido.

Además, la velocidad no debe sacrificar la precisión ni la integridad ética de los datos utilizados. En consecuencia, los proveedores y desarrolladores que ofrecen servicios de construcción rápida de datasets personalizados para fine-tuning apuestan por un balance entre automatización y supervisión humana. Esta combinación asegura que los modelos entrenados no sólo sean efectivos, sino también confiables y alineados con los valores corporativos y normativos. Asimismo, la integración de inteligencia artificial en el propio proceso de construcción de datasets permite optimizar la selección, limpieza y anotación de datos. Algoritmos especializados pueden identificar rápidamente patrones, detectar inconsistencias o clasificar grandes volúmenes de información, acelerando las etapas manuales y permitiendo al equipo concentrarse en aspectos estratégicos.

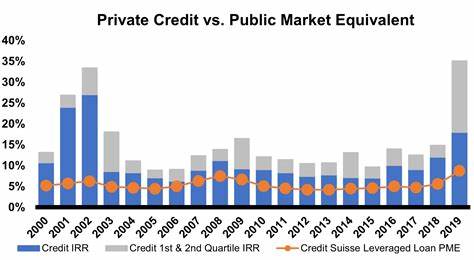

El impacto de esta innovación es palpable en diversos sectores, desde la salud, donde modelos personalizados pueden identificar patologías con mayor exactitud, hasta el comercio electrónico, que utiliza datos específicos para mejorar recomendaciones y experiencia de usuario. También en la industria financiera, donde el análisis puntual de riesgos requiere datos específicos para cada segmento. Frente al panorama de una demanda creciente por soluciones de inteligencia artificial efectivas y adaptadas, la posibilidad de generar datasets para fine-tuning en un lapso de 24 a 72 horas es un cambio trascendental. No sólo se optimizan recursos y tiempos, sino que se amplía la capacidad de innovación y competitividad de las empresas. Finalmente, las organizaciones que adopten estos métodos avanzados estarán mejor preparadas para enfrentar los desafíos del futuro, donde la personalización y la velocidad de respuesta serán factores claves para mantener la relevancia en un entorno cada vez más digitalizado y dinámico.

En resumen, la construcción rápida y personalizada de conjuntos de datos para fine-tuning es una herramienta poderosa que impulsa la evolución de la inteligencia artificial, permitiendo a las empresas maximizar el valor de sus inversiones y alcanzar nuevos niveles de desempeño.