En la era digital actual, los modelos de lenguaje de gran escala (LLMs, por sus siglas en inglés) han revolucionado la forma en que interactuamos con la tecnología. Desde asistentes virtuales hasta generadores automáticos de texto, su capacidad para procesar y producir lenguaje humano ha abierto un sinfín de oportunidades. Sin embargo, a pesar de su potencial, muchas personas cometen errores comunes a la hora de utilizar estas herramientas, especialmente al escribir prompts o indicaciones. Estos fallos pueden limitar la efectividad del modelo y provocar resultados insatisfactorios. Comprender estos errores es esencial para aprovechar al máximo estas tecnologías y obtener respuestas precisas, coherentes y útiles.

Uno de los errores más habituales al usar modelos de lenguaje grandes es proporcionar prompts poco claros o ambiguos. La precisión en la redacción es clave, ya que los modelos trabajan mejor cuando la solicitud es específica. Cuando un prompt es vago, el modelo puede interpretar múltiples significados, originando respuestas que no cumplen con las expectativas del usuario. Por ejemplo, una pregunta demasiado genérica o con términos polisémicos puede generar una respuesta amplia o fuera de contexto. Para evitar esto, es recomendable incluir en el prompt información detallada y establecer claramente el objetivo deseado.

Además, muchas personas tienden a subestimar la importancia del contexto en la interacción con los modelos. Un prompt aislado sin antecedentes puede hacer que el modelo genere respuestas desconectadas o poco coherentes con la conversación previa. Incluir información contextual puede ayudar al modelo a comprender mejor la intención y producir una respuesta más relevante. En ciertos casos, fragmentos de texto adicionales o ejemplos pueden mejorar significativamente la calidad de la salida. Otro error común radica en esperar un conocimiento actualizado o infalible de parte del modelo.

Los LLMs están entrenados con grandes cantidades de datos hasta una fecha límite específica y no poseen acceso en tiempo real a información actualizada. Por ello, solicitar datos recientes o eventos en desarrollo puede resultar en información incorrecta o desactualizada. Es fundamental entender estas limitaciones y, cuando sea necesario, complementar las respuestas con fuentes confiables y actualizadas. La falta de iteración en la elaboración de prompts es también un desacierto frecuente. Muchas veces, los usuarios plantean un prompt, reciben una respuesta y la consideran definitiva sin intentar ajustar, reformular o profundizar en la consulta.

Sin embargo, la interacción con un modelo de lenguaje es un proceso dinámico que beneficia de la experimentación. Ajustar la redacción o dirigir la conversación hacia aspectos más específicos puede mejorar significativamente los resultados. La sobrecarga de información en un solo prompt es otro aspecto que puede entorpecer la respuesta del modelo. Incluir demasiados elementos o preguntas en una sola indicación puede confundir al modelo y diluir la precisión de su salida. Es preferible dividir consultas complejas en partes más manejables, facilitando respuestas claras y enfocadas en cada tópico.

También existe el error de no aprovechar completamente las capacidades del modelo, como la especificación del tono, estilo o formato deseado. Indicar estas características puede orientar al modelo hacia una respuesta más adaptada a las necesidades específicas del usuario, desde textos formales hasta creativos, resúmenes o listados claros. Omitir esta guía puede derivar en textos genéricos y menos efectivos. Por otra parte, algunas personas ignoran la importancia de revisar y validar las respuestas generadas. Aunque los modelos son sofisticados, pueden producir errores, imprecisiones, o incluso información sesgada.

Confirmar las respuestas mediante fuentes externas o la revisión humana es una práctica recomendada para asegurar la calidad y fiabilidad del contenido. Un problema adicional se presenta cuando los usuarios no consideran las limitaciones éticas y legales al utilizar LLMs. Generar contenidos que infrinjan derechos de autor, propicien desinformación o perpetúen sesgos puede tener consecuencias negativas. Es esencial utilizar estas herramientas con responsabilidad, evaluando el impacto y verificando la coherencia de los textos producidos. Asimismo, la desconexión entre las expectativas del usuario y las capacidades reales del modelo puede llevar a frustración.

Algunos usuarios esperan que el modelo comprenda de manera infalible todos los matices culturales, linguísticos o técnicos, cuando en realidad el aprendizaje del modelo depende de los datos con los que fue entrenado y puede presentar limitaciones en áreas específicas. Reconocer estas limitaciones ayuda a establecer metas realistas y a comunicarse de forma más efectiva con el sistema. Un aspecto técnico que a menudo pasa desapercibido es la selección inapropiada del modelo para la tarea concreta. Existen diferentes variantes de LLMs que varían en tamaño, especialización y coste computacional. Utilizar un modelo demasiado general o menos potente puede no ser la mejor opción para determinadas aplicaciones, mientras que un modelo avanzado sin la correcta configuración puede resultar ineficiente.

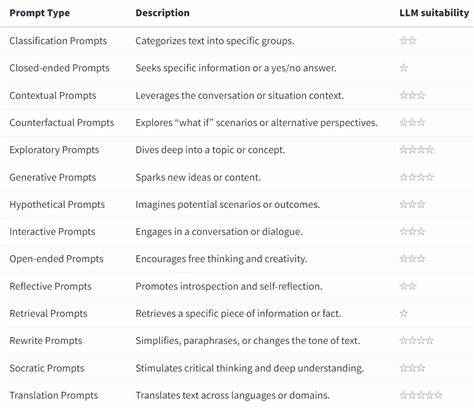

Evaluar y elegir la herramienta adecuada es un paso crítico para maximizar resultados. En el ámbito de la redacción de prompts, la falta de creatividad y experimentación representa un obstáculo para aprovechar todas las potencialidades de los LLMs. La manera en que se formula una pregunta o se estructura una indicación puede influir radicalmente en la respuesta obtenida. Por ello, explorar diferentes enfoques y técnicas para escribir prompts es una estrategia valiosa para descubrir nuevas aplicaciones y optimizar la interacción con el modelo. Finalmente, un error recurrente es el descuido en la gestión de la privacidad y los datos personales al utilizar estos sistemas.