En el dinámico mundo de la tecnología, la inteligencia artificial se ha convertido en un eje central para el desarrollo y la innovación. Amazon Web Services (AWS), un líder mundial en servicios en la nube, ha adoptado un enfoque estructurado para posicionarse como un referente en IA mediante una estrategia de tres capas. Este planteamiento busca ofrecer desde la infraestructura necesaria hasta las aplicaciones que utilizan modelos de lenguaje y aprendizaje profundo. Pero la pregunta que muchos técnicos, directores tecnológicos y entusiastas se hacen es: ¿está AWS realmente cumpliendo con lo que promete en cada uno de estos niveles? El primer nivel de este enfoque, conocido como la capa inferior o de infraestructura, se enfoca en proveer la base técnica para el entrenamiento de modelos de inteligencia artificial, especialmente aquellos de gran escala o fundacionales. AWS ha invertido considerablemente en desarrollar hardware específico para esta tarea, destacando sus chips Trainium e Inferentia.

Aunque estos no son GPUs tradicionales, están diseñados específicamente para optimizar el entrenamiento y la inferencia de modelos de IA, con motores especializados para acelerar operaciones tensoriales y vectoriales. Sin embargo, existe cierta controversia con respecto a la integración de estos chips en los ecosistemas actuales de desarrollo. La mayoría de los frameworks de aprendizaje profundo y herramientas alrededor de la IA están optimizados para GPUs, y mayormente para las desarrolladas por NVIDIA, que domina el mercado tanto en hardware como en software. Esto significa que, para muchos desarrolladores, cambiar a arquitecturas diferentes como Trainium puede representar un desafío técnico significativo, ya que implica modificar pipelines y herramientas ya establecidas. AWS parece estar motivado por reducir su dependencia respecto a NVIDIA y sus términos, pero por el momento esta transición no se ve sencilla ni inmediata.

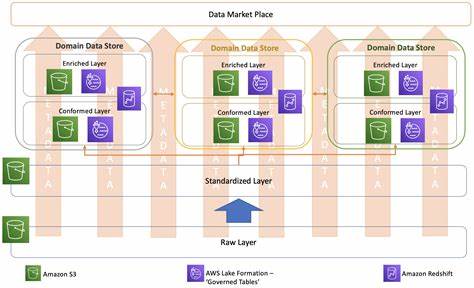

Pese a ello, hay que reconocer que AWS entrega una infraestructura robusta que va más allá del hardware. Su ecosistema basado en máquinas virtuales escalables, almacenamiento altamente disponible y redes de baja latencia ofrecen ventajas claras para trabajar con cargas de trabajo intensivas en datos y cómputo, como las que requieren los entrenamientos de modelos complejos. Es esta capacidad para escalar, gestionar y ajustar recursos en tiempo real la que sigue siendo uno de los puntos fuertes de AWS frente a otros proveedores en el segmento de la nube y la inteligencia artificial. En el segundo nivel, AWS se ha concentrado en los modelos fundacionales (Foundation Models) y las herramientas para construir y entrenar grandes modelos de lenguaje (LLMs). Aunque en años anteriores sus propuestas en esta área eran limitadas o poco competitivas, la reciente introducción de los modelos Amazon Nova ha cambiado la perspectiva.

Estos modelos, que inicialmente parecían ser una repetición de alternativas ya existentes bajo una nueva marca, en realidad ofrecen un desempeño comparable a opciones líderes del mercado, y con un importante ahorro en costos. Esto abre nuevas posibilidades tanto para empresas como para desarrolladores que buscan aprovechar modelos avanzados sin incurrir en los costos usualmente altos. Además, AWS lanzó Amazon Bedrock, un servicio que facilita el acceso y la integración de diferentes modelos fundacionales a través de una única capa de acceso. Esta plataforma permite a los usuarios interactuar con una variedad de modelos de distintos proveedores, como Anthropic, sin necesidad de cambiar la forma en que se hacen las llamadas a la API o realizar múltiples configuraciones de autenticación. Aunque Bedrock ha sido criticado por tener ciertos 'cantazos' técnicos y particularidades poco intuitivas, su estrategia busca estandarizar y simplificar la interacción con múltiples modelos, lo cual podría ser un diferenciador importante para los usuarios embebidos en el ecosistema AWS.

Sin embargo, para muchos usuarios experimentados, acceder directamente a APIs de terceros como OpenAI o Anthropic sigue siendo igual de eficiente, lo que plantea la tarea pendiente para AWS de pulir y consolidar el producto Bedrock, haciéndolo no solo seguro y sencillo, sino también coherente y robusto en su experiencia de usuario. La tercera capa representa el nivel superior, donde residen las aplicaciones y herramientas que utilizan los modelos de inteligencia artificial para ofrecer soluciones concretas. En este ámbito, AWS tiene antecedentes destacados con herramientas que llevan años en el mercado y que gozan de reconocimiento por su eficacia y fiabilidad, como Amazon Textract, para reconocimiento óptico de caracteres, y AWS Transcribe para transcripción de audio. Estas soluciones evidencian la capacidad de AWS para ofrecer servicios automatizados con un nivel alto de especialización que benefician a sus clientes desde hace tiempo. Sin embargo, las nuevas ofertas bajo la marca Amazon Q, pensadas para desarrollar e integrar IA directamente en herramientas de desarrollo e interfaces, presentan un panorama más mixto.

En ocasiones, estas parecen más enfocadas a prevenir errores o respuestas problemáticas que a impulsar funcionalidades innovadoras. Adicionalmente, la propuesta comercial detrás de Amazon Q Business no está clara para muchos usuarios, lo que genera dudas sobre su propuesta de valor y posicionamiento frente a otras soluciones emergentes. Uno de los aspectos más notables y menos publicitados de AWS en el contexto de IA es su servicio Compute Optimizer. Esta herramienta, aunque no representativa de la IA tradicional de aprendizaje profundo, utiliza técnicas para analizar y recomendar ajustes automáticos en las cargas de trabajo y recursos asignados en la nube, optimizando costos y rendimiento. Su capacidad para entender el comportamiento de miles de aplicaciones y ajustar sus recursos a las necesidades reales es un claro ejemplo de cómo AWS aplica inteligencia artificial para resolver problemas prácticos y cotidianos de sus usuarios.

Este servicio, junto con el Savings Plan Analyzer, demuestra que AWS está utilizando el aprendizaje automático y la IA en áreas críticas pero menos visibles, lo que aporta un valor tangible a los clientes en términos de ahorro y eficiencia. Curiosamente, estos éxitos no son parte de su narrativa principal en torno a la IA, posiblemente porque no encajan con la imagen de innovación espectacular que buscan proyectar actualmente. A nivel general, AWS mantiene una postura tradicional de no exagerar sus capacidades hasta que sus productos están realmente maduros, aunque en esta era de IA han adoptado una estrategia diferente, impulsando historias y propuestas sobre tecnologías e ideas que aún están en desarrollo o por madurar. Esto dificulta para los usuarios y analistas distinguir claramente dónde hay verdadero valor inmediato y dónde hay solo promesas o hype. En resumen, AWS se encuentra en una etapa de transición y consolidación en su esfuerzo por dominar la inteligencia artificial a través de su enfoque de tres capas.

Su infraestructura es sólida y confiable, aunque con retos para integrar plenamente su hardware especializado. En el ámbito de los modelos fundacionales, ha dado pasos importantes con productos competitivos, aunque sigue necesitando mejorar la cohesión y facilidad de sus servicios. Finalmente, en aplicaciones y herramientas, existen luces y sombras, con servicios maduros y confiables complementados por otras iniciativas que todavía buscan definir su rumbo. El año 2025 será crucial para AWS, en el sentido de que mostrará si puede armonizar estas capas y construir una oferta genuinamente diferenciada y convincente para la industria de la inteligencia artificial. A medida que la nube se vuelve cada vez más homogénea en sus capacidades básicas, la apuesta de AWS por la IA podría ser la clave para destacar, siempre y cuando mantenga su compromiso con la calidad, la usabilidad y la innovación sincera.

Para los profesionales y empresas interesados en tecnología, seguir de cerca la evolución de AWS en este terreno brindará valiosos aprendizajes sobre cómo se interrelacionan hardware, software y aplicaciones en la próxima generación de la computación en la nube y la inteligencia artificial.