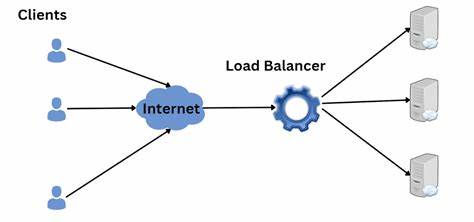

En la era digital actual, la capacidad para manejar grandes volúmenes de tráfico es esencial para mantener la disponibilidad y el desempeño de aplicaciones web y servicios en línea. Los balanceadores de carga juegan un papel fundamental al distribuir las solicitudes entrantes entre múltiples servidores backend, asegurando que ninguna máquina se vea sobrecargada y mejorando la tolerancia a fallos. Si bien existen soluciones robustas y muy utilizadas como NGINX o HAProxy, comprender cómo funcionan estas herramientas a nivel interno es un conocimiento invaluable para cualquier desarrollador o ingeniero en sistemas. En este sentido, el lenguaje Go, reconocido por su rendimiento y facilidad para crear aplicaciones concurrentes, ofrece un entorno ideal para construir un balanceador de carga sencillo pero eficaz. En pocas líneas de código, es posible implementar un sistema que realice distribución round-robin, monitoreo de salud de servidores y reenvío de solicitudes HTTP.

A continuación, te mostramos cómo desarrollar un balanceador de carga HTTP usando solo la biblioteca estándar de Go, con un enfoque didáctico y práctico que abarca todos los componentes necesarios para que funcione correctamente. El primer paso al crear un balanceador de carga es definir los elementos que conformarán la infraestructura. En este caso, cada servidor backend será representado mediante una estructura que contendrá su URL, su estado de vida (es decir, si está activo o no) junto con un mecanismo para asegurar que el estado sea accesible y modificable de manera segura en entornos concurrentes. Para manejar las solicitudes, aprovechamos el paquete net/http/httputil que ofrece un proxy reverso integrado, facilitando la redirección de peticiones sin necesidad de gestionar manualmente cada detalle del protocolo HTTP. La función para seleccionar el siguiente backend usa un algoritmo round-robin que rotativamente distribuye el tráfico entre los servidores disponibles, omitiendo aquellos que se encuentren inactivos para evitar enviar peticiones a servicios no disponibles.

La concurrencia se maneja mediante el uso de operaciones atómicas, con el fin de evitar condiciones de carrera y preservar la integridad del contador que determina cuál backend es el siguiente en atender una solicitud. La supervisión del estado de los servidores backend es fundamental para el correcto funcionamiento del balanceador. Implementar una rutina de chequeo de salud garantiza que solo los servidores que respondan satisfactoriamente reciban tráfico. Este mecanismo consiste en intentar establecer una conexión TCP con el servidor dentro de un tiempo establecido; si la conexión es positiva, el backend se considera vivo, de lo contrario se marca como muerto y se excluye temporalmente de la distribución de solicitudes. Esta metodología sencilla puede mejorarse para casos de producción al realizar solicitudes HTTP específicas a un endpoint de salud, validando también la correcta respuesta de la aplicación, pero para fines educativos y funcionalidad básica, la verificación TCP es suficiente.

La parte central que se encarga de manejar las solicitudes HTTP se basa en el método ServeHTTP, que implementa la interfaz http.Handler. Este método obtiene el backend disponible y utiliza el proxy reverso para reenviar la solicitud original. Si no existe ningún backend disponible, se responde con un error 503 Service Unavailable, informando al cliente que el servicio no está temporalmente accesible. El uso del proxy reverso del paquete httputil libera al desarrollador de tener que gestionar manualmente todas las peculiaridades del protocolo HTTP, como encabezados, cookies, o manejo de streaming, asegurando que la petición se retransmita correctamente.

La función main integra todos los componentes. En ella se configuran los puertos y las direcciones de los servidores backend, se instancian los objetos que representan cada servidor, asignándoles el proxy reverso junto a las rutinas de manejo de errores. Se realiza un chequeo inicial de salud para asegurar el estado en tiempo real y se lanza un goroutine que ejecuta chequeos periódicos, manteniendo actualizado el estado de los servidores de manera independiente y eficiente. Finalmente, se inicia el servidor HTTP que escucha sobre el puerto configurado y utiliza el balanceador de carga como controlador para distribuir todas las solicitudes entrantes. Para probar el balanceador, es recomendable disponer de múltiples instancias sencillas de servidores que respondan en diferentes puertos.

Estos servidores pueden ser implementados con un código mínimo en Go donde simplemente respondan al recibir solicitudes HTTP con un mensaje identificando el puerto de respuesta y alguna ruta. De esta forma, al realizar peticiones consecutivas al balanceador, se puede verificar visualmente cómo la carga se reparte en forma rotativa, validando el correcto funcionamiento del sistema. A pesar de que este balanceador es básico y diseñado para fines educativos, demuestra claramente cómo los fundamentos de programación en Go, junto con su biblioteca estándar, permiten construir herramientas poderosas de manera eficiente. En un entorno de producción real, sería necesario ampliar la funcionalidad para soportar algoritmos de balanceo más avanzados, realizar chequeos de salud más completos incluyendo análisis del contenido de las respuestas HTTP, implementar métricas y monitoreo, manejar sesiones persistentes, integrar soporte para TLS y permitir dinámica en la configuración sin interrupciones del servicio. Comprender este ejemplo sirve también para mejorar la capacidad de diagnosticar y configurar balanceadores comerciales, ya que clarifica las operaciones internas básicas que estos programas realizan.

La simplicidad y claridad que ofrece Go, sumado a la eficiencia de su modelo de concurrencia, lo convierten en un lenguaje ideal para este tipo de desarrollo. Además, el hecho de que todo esto se pueda lograr en aproximadamente 150 líneas de código es una muestra elocuente del poder que los lenguajes modernos ofrecen a los desarrolladores. En conclusión, construir un balanceador de carga HTTP con Go no solo es un excelente ejercicio para entender conceptos de redes y concurrencia, sino también una base sólida para crear soluciones a medida que respondan a las necesidades específicas de cualquier entorno. Desde la creación de pequeños proyectos hasta la escalabilidad requerida por grandes sistemas distribuidos, las bases presentadas aquí permitirán a los desarrolladores diseñar con conocimiento y confianza sus arquitecturas de tráfico web, maximizando el rendimiento y la disponibilidad de sus servicios.