En la avanzada intersección entre la robótica y la inteligencia artificial, un nuevo sistema desarrollado por un equipo de investigadores del Massachusetts Institute of Technology (MIT), Amazon Robotics y la Universidad de British Columbia está revolucionando la manera en la que los robots pueden interactuar con el mundo físico. Esta innovadora técnica permite a los robots identificar propiedades de objetos —como su masa, suavidad o contenido— únicamente a través del manejo y la manipulación directa, sin depender de cámaras, sensores táctiles adicionales ni otros instrumentos externos. La inspiración para este desarrollo proviene de la capacidad humana de inferir características de un objeto con solo sostenerlo y moverlo. Por ejemplo, al levantar una caja en un ático oscuro, una persona puede estimar su peso y lo que podría contener simplemente percibiendo las fuerzas ejercidas y los pequeños movimientos que el objeto realiza. Este proceso, que los humanos realizan con facilidad gracias a la propriocepción y la experiencia sensorial, ahora ha sido adaptado para robots mediante una combinación de sensores incorporados y simulaciones avanzadas.

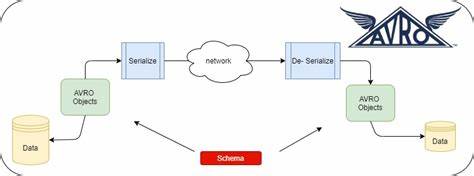

El núcleo del sistema consiste en una estrategia que aprovecha los sensores internos del robot —principalmente los codificadores de las articulaciones— para recoger información sobre el movimiento y las fuerzas que ocurren al manipular un objeto. Los codificadores miden la posición angular y la velocidad de cada junta, brindando datos precisos y en tiempo real acerca de cómo la estructura robótica reacciona a la interacción con el mundo físico. A diferencia de muchas técnicas que se basan en costosos sensores táctiles o en la captura visual mediante cámaras, esta metodología es principalmente económica y efectiva. Los robots ya suelen contar con estos sensores integrados en sus motores para controlar el movimiento, lo que elimina la necesidad de equipamiento adicional. Esta simplicidad aporta una ventaja significativa, sobre todo en entornos donde la iluminación es pobre o la visibilidad está comprometida, como puede ocurrir en bodegas oscuras o en edificios dañados tras un desastre natural.

Gracias a la información obtenida de los sensores internos, el sistema emplea modelos digitales precisos que simulan tanto el robot como el objeto con el que interactúa. La precisión de estas réplicas digitales o “gemelos digitales” es esencial para que el método funcione correctamente, ya que permiten comparar en tiempo real los datos sensoriales reales con las predicciones hechas a través de la simulación. Una herramienta fundamental en este sistema es la simulación diferenciable, una técnica que posibilita calcular cómo pequeñas variaciones en las propiedades del objeto, como la masa o la dureza, afectan el comportamiento del robot al levantar o sacudir dicho objeto. Utilizando esta técnica, el algoritmo ajusta continuamente los parámetros simulados hasta que el movimiento simulado coincide con el real observado por los sensores, lo que implica que las propiedades estimadas del objeto son correctas. Este enfoque permite a los robots estimar propiedades físicas en cuestión de segundos, y lo que es más notable, hacerlo con un modelo de aprendizaje eficiente en datos.

El sistema solo requiere una única trayectoria del movimiento del robot en el mundo real para determinar con precisión las características del objeto, evitando la necesidad de recopilar grandes conjuntos de datos para entrenar modelos complejos como sucede en muchas técnicas basadas en visión computarizada. El potencial de esta tecnología es vasto. Además de estimar la masa y suavidad de objetos sólidos, es capaz de anticipar otras propiedades físicas como el momento de inercia o la viscosidad de líquidos contenidos en recipientes. Esta capacidad es especialmente útil para robots que tienen que manipular diferentes tipos de materiales o enfrentarse a escenarios impredecibles, fortaleciendo su autonomía y adaptabilidad. Los investigadores liderados por Peter Yichen Chen, un postdoctorado en el MIT, visualizan un futuro donde los robots podrán explorar su entorno tocando y moviendo objetos para aprender de manera autónoma sus características.

Esta evolución propiciaría la creación de sistemas robóticos capaces de desarrollar nuevas habilidades de manipulación con rapidez y ajustarse dinámicamente a cambios en su entorno sin necesidad de reprogramación manual o supervisión constante. Aunque el equipo reconoce que esta tecnología no busca reemplazar las técnicas basadas en visión, como el aprendizaje profundo aplicado a imágenes, planean combinar ambas para formar sistemas multimodales que aprovechen lo mejor de ambos mundos. Esto permitiría a los robots utilizar la percepción visual para identificar objetos a distancia y recurrir a la propriocepción y simulación para indagar en profundidad sus propiedades físicas cuando los manipulen. La integración de estas herramientas es un paso prometedor hacia robots más inteligentes y versátiles que podrían desempeñar funciones en una amplia gama de industrias y entornos. Desde el ordenamiento de objetos en almacenes poco iluminados, pasando por la asistencia en situaciones de desastre donde el acceso visual es limitado, hasta la manipulación segura de materiales delicados o peligrosos, las aplicaciones prácticas son numerosas.

El desarrollo ha contado con el apoyo de Amazon y el programa GIST-CSAIL, reflejando el interés tanto académico como industrial en avanzar en capacidades más sofisticadas para la robótica. Al combinar el conocimiento en simulación, control robótico y aprendizaje automático, esta iniciativa representa un hito en la relación entre máquinas y su entorno físico. Además, esta técnica abre las puertas a la exploración en contextos más complejos, como robots blandos que tienen una dinámica mucho más difícil de modelar y controlar, o la manipulación de objetos con comportamientos no rígidos, como líquidos que se mueven dentro de contenedores o medios granulares como la arena. Estos desafíos, hasta ahora muy difíciles para la robótica convencional, podrían ser abordados con esta novedosa combinación de propriocepción y simulación diferenciable. En definitiva, el avance permite vislumbrar una nueva generación de robots capaces de aprender de manera autónoma sobre sus entornos y objetos con los que interactúan, basándose no solo en lo que pueden ver, sino también en lo que pueden sentir y deducir a través de su interacción física directa.

Esto representa un gran paso hacia una robótica más intuitiva, capaz de operar en escenarios reales y desafiantes con alta precisión y autonomía.