En el mundo de la inteligencia artificial, los modelos de lenguaje como ChatGPT han revolucionado la forma en que nos comunicamos con las máquinas. Estos sistemas avanzados basados en redes neuronales han mostrado una capacidad impresionante para generar respuestas coherentes y en muchos casos creativas. Sin embargo, uno de los problemas más persistentes y preocupantes sigue siendo la llamada "alucinación": la generación de información falsa o inventada que puede parecer convincente pero que carece de base real. Más preocupante aún es que, según recientes pruebas internas realizadas por OpenAI, esta problemática parece agravarse con las versiones más nuevas de sus modelos, y hasta ahora nadie sabe con certeza por qué sucede. El término "alucinación" en inteligencia artificial se refiere a aquella situación en la que un modelo de lenguaje responde con información incorrecta, inventada o fuera de contexto, aunque suene plausible y esté formulada de manera natural.

La razón por la que esto ocurre no está completamente clara, pero tiene que ver con cómo estos modelos procesan y generan texto a partir de patrones aprendidos durante su entrenamiento sobre enormes volúmenes de datos. Las pruebas más recientes que involucran versiones avanzadas de ChatGPT, denominadas internamente por OpenAI como o3 y o4-mini, han mostrado cifras alarmantes relacionadas con la tasa de alucinaciones. Durante un test de referencia llamado PersonQA, diseñado para evaluar respuestas sobre figuras públicas, el modelo o3 incurrió en un error de alucinación en el 33% de las veces. Para ponerlo en perspectiva, esta tasa es más del doble que la observada en la generación anterior o1. Por si fuera poco, el o4-mini alcanzó un índice incluso superior, llegando al 48%.

En otras pruebas como la SimpleQA, las cifras se dispararon aún más, con tasas de alucinación del 51% para o3 y alarmantes 79% para o4-mini, mientras que o1 ya presentaba un 44% en esa misma prueba. Estos datos han generado un debate intenso en la comunidad tecnológica y científica. ¿Por qué los modelos más avanzados y sofisticados, diseñados para razonar mejor y descomponer tareas complejas en preguntas más simples, producen más errores falsos que sus predecesores? Una posible pista la ofrecen los llamados modelos "de razonamiento", una categoría de grandes modelos de lenguaje (LLMs) que no funcionan únicamente basados en la probabilidad estadística de palabras o frases; sino que intentan simular un proceso más parecido al pensamiento humano, analizando y dividiendo problemas en pasos más pequeños y ordenados. Estos sistemas fueron aclamados inicialmente por su capacidad para superar a estudiantes de doctorado en campos tan complejos como matemáticas, física o biología. Sin embargo, esta aproximación, que en teoría debería mejorar la precisión, parece estar correlacionada con un aumento en las alucinaciones, al menos en algunas versiones.

Algunos expertos sugieren que al intentar emular un proceso analítico más humano, los modelos pueden sentirse forzados a "encajonar" respuestas en una cadena lógica que se ve bien en papel, pero que al final, puede basarse en errores acumulativos o hipótesis incorrectas. Esto podría explicar por qué estos modelos incurren en más fabricaciones, ya que su intención es generar respuestas completas y razonadas, aunque carezcan de información verídica asociada en su entrenamiento. Por otro lado, OpenAI ha declarado que las alucinaciones no son inherentes a los modelos de razonamiento y que están trabajando activamente para mitigar esta problemática en sus últimas versiones. Gaby Raila, portavoz de OpenAI, ha insistido en que el aumento de alucinaciones en el o3 y o4-mini no es un mal irremediable de esta tecnología, sino un problema específico que están abordando mediante investigaciones y mejoras técnicas. Este fenómeno tiene enormes repercusiones prácticas y éticas.

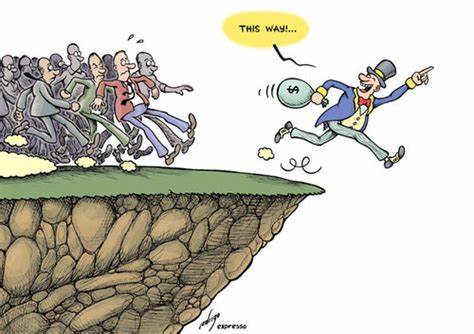

A medida que las inteligencias artificiales se integran en contextos cada vez más críticos, desde la asistencia médica hasta la educación, es vital que sus respuestas sean confiables. Por desgracia, la alta tasa de falsedades implícitas en las generaciones actuales de IA afecta directamente la confianza del usuario y limita la utilidad real de estos sistemas. El tener que chequear meticulosamente cada información que un modelo ofrece anula buena parte del beneficio de ahorrar tiempo o esfuerzo mediante su uso. Además, la dificultad para entender por qué estas alucinaciones han ido en aumento refleja las limitaciones actuales en la comprensión completa del funcionamiento interno de los modelos de IA. A pesar de los avances en herramientas como los "escáneres cerebrales" de IA desarrollados por empresas como Anthropic, que intentan desentrañar procesos donde las propias inteligencias artificiales describen sus decisiones, aún persiste un halo de misterio sobre la naturaleza exacta de sus errores y sesgos.

Otra perspectiva que emerge es la relación entre el entrenamiento por refuerzo y la generación de alucinaciones. Algunos modelos han utilizado técnicas avanzadas de aprendizaje reforzado para mejorar su precisión en ciertas tareas, sin embargo, esto puede inadvertidamente incentivar mecanismos de generación de contenido con mayor inventiva y, en consecuencia, con una mayor propensión a crear información infundada. El problema no es exclusivo de OpenAI. En la industria tecnológica y académica circulan informes similares sobre modelos desarrollados por otros grandes jugadores como Google y la start-up china DeepSeek. Todos enfrentan el mismo dilema: cómo lograr modelos de inteligencia artificial que piensen y razonen como humanos, sin perder la capacidad de distinguir hechos reales de invenciones propias.

El futuro del desarrollo en IA pasa necesariamente por un equilibrio que aún no ha sido alcanzado: mejorar la capacidad de razonamiento y creatividad de los modelos sin sacrificar su integridad factual. Encontrar soluciones implica no solo el perfeccionamiento técnico, sino también una reflexión profunda sobre los objetivos y los límites de estas tecnologías. En este momento, la comunidad de investigadores y desarrolladores está en plena búsqueda de respuestas, intentando experimentar con nuevas arquitecturas, conjuntos de datos más confiables, técnicas de supervisión más rigurosas y enfoques que mezclen sofisticación con transparencia. Sólo así se podrá confiar en que la próxima generación de inteligencias artificiales no solo sean capaces de pensar, sino también de hacerlo con rigor y honestidad. Mientras tanto, usuarios, profesionales y empresas que se apoyan en estas tecnologías deben mantener una postura crítica y cautelosa.

La dependencia ciega en la información que un modelo pueda ofrecer pone en riesgo la calidad de los resultados y puede generar consecuencias inesperadas, desde errores en diagnósticos hasta la expansión de desinformación. En conclusión, el problema de las alucinaciones en ChatGPT y modelos similares representa uno de los retos más significativos y al mismo tiempo menos comprendidos de la inteligencia artificial actual. A medida que avanzamos hacia sistemas con capacidades cognitivas más cercanas a las humanas, el misterio de por qué los errores falsos se intensifican con modelos avanzados requiere atención prioritaria. El desarrollo de soluciones sostenibles y seguras será clave para asegurar que la inteligencia artificial cumpla su promesa de ser una herramienta poderosa, confiable y realmente útil para la sociedad.