La rápida evolución de la inteligencia artificial ha traído consigo desafíos únicos en cuanto a la veracidad y trazabilidad de sus resultados. En un mundo donde las organizaciones y usuarios dependen cada vez más de los modelos de IA para tomar decisiones críticas, surge una pregunta crucial: ¿cómo podemos demostrar que una salida generada por una IA fue producto de una infraestructura específica, en un momento y lugar determinados, sin tener acceso al código o al algoritmo interno que produjo dicha salida? Esta cuestión no es solo una curiosidad técnica, sino un pilar fundamental para la confianza, la seguridad y la regulación responsable en la era digital. La respuesta a esta compleja interrogante pasa por una innovadora técnica llamada "computación sellada". Este concepto abre la puerta a la creación de pruebas verificables sobre las condiciones exactas en que una tarea de inferencia de IA fue ejecutada. La computación sellada posibilita garantizar que una salida fue generada en circunstancias controladas, incluyendo la utilización de un chip único y en una ubicación geográfica precisa, todo ello sin comprometer el secreto del proceso o la lógica del modelo.

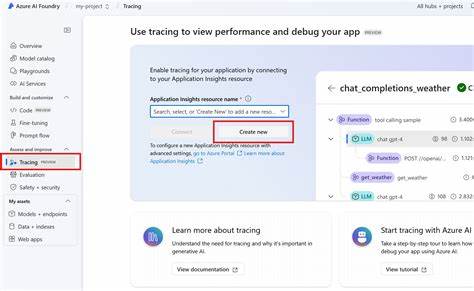

Uno de los principales retos para establecer esta confianza es cómo otorgar garantías sin que el "host" —la entidad que ejecuta el modelo— tenga que revelar su carga de trabajo, su propiedad intelectual o exponerse a vulnerabilidades. En lugar de ello, la computación sellada actúa como un mediador seguro que aísla la ejecución de la inferencia mientras ofrece certificaciones firmadas y verificables sobre las condiciones en que se llevó a cabo el cálculo. Esto se logra mediante la introducción de un tercero confiable denominado "embajada", que funciona como una especie de guardián del proceso. El proceso comienza cuando un usuario final solicita una inferencia a un sistema. Si solo desean el resultado, este se entrega de forma tradicional.

No obstante, si el usuario requiere garantías sobre el contexto de generación, la solicitud se cifra usando una clave especial que solo puede ser desbloqueada con la cooperación de la embajada. Al recibir esta solicitación especial, el sistema se comunica con la embajada para cerrarse y aislarse del entorno externo, asegurando que ningún dato no autorizado ingrese o salga durante la inferencia. Esta “selladura” se basa en tecnologías seguras de enclaves confiables y contenedorización, donde la embajada bloquea todas las conexiones externas salvo las estrictamente necesarias para la comunicación con el sistema aislado. Además, la embajada genera y firma una declaración verificable en la cual se registran la fecha, hora, ubicación y medidas del sistema. Esta declaración constituye la piedra angular que permite al usuario confiar en que la ejecución fue legítima, pues el proceso ha quedado confinado sin posibilidad de intervención externa.

Para garantizar una confianza todavía mayor, una vez finalizada la inferencia, el sistema se compromete con el resultado mediante un hash, que también es firmado y registrado por la embajada antes de reabrirse y enviar el resultado al usuario. De esta forma, se asegura que la salida no pudo ser modificada o reemplazada tras haber sido generada en un entorno completamente cerrado y monitoreado. La embajada utiliza técnicas avanzadas para establecer límites temporales y espaciales de la ejecución, como relojes a prueba de manipulaciones y rutinas de geolocalización basadas en el análisis de latencias de red, asegurando que la inferencia ocurrió efectivamente en un intervalo de tiempo y en un lugar físico específicos. Además, revisa el hardware utilizado, accediendo a identificadores únicos que los fabricantes integran en chips como los GPUs Nvidia para confirmar que la ejecución ocurrió en el dispositivo esperado. Dentro del ámbito de la computación sellada, se hace una distinción importante respecto a las barreras de protección durante la selladura: existen selladuras de entrada, las cuales impiden que nueva información pueda ingresar a la ejecución aislada; y selladuras de salida, que aseguran que nada pueda salir del enclave mientras está cerrado.

Ambas modalidades tratan de evitar que se filtren datos que puedan corromper la inferencia o poner en riesgo la privacidad y seguridad. Estas pruebas de localidad, temporalidad y uso de hardware único no solo aportan seguridad y trazabilidad, sino que además abren nuevas posibilidades en materia de gobernanza de la IA. Por ejemplo, organizaciones reguladoras pueden asegurarse de que ciertas capacidades o conocimientos sensibles solo se utilicen en entornos adecuados y dentro de jurisdicciones autorizadas, evitando usos indebidos o violaciones a normativas internacionales. La posibilidad de que la embajada realice un monitoreo discreto de las habilidades usadas en cada inferencia —mediante un análisis indirecto de las activaciones neuronales consumidas— añade un nivel adicional de control que puede ser fundamental para evitar situaciones de riesgo como el uso dual de tecnologías o la filtración de conocimiento crítico. Sin embargo, la eficacia de estos sistemas depende de una cadena de confianza sólida.

Para que la computación sellada funcione, la embajada y su entorno operativo deben ser confiables y libres de manipulaciones maliciosas. Por ello, se apoyan en sistemas operativos de ure capa abierta, mecanismos de arranque medidos y módulos TPM para garantizar que el sistema no ha sido corrompido ni por actores internos ni externos. Asimismo, aunque las tecnologías de entornos confiables (TEE) ofrecen una protección potente, no son infalibles; vulnerabilidades y ataques sofisticados siempre representan un riesgo, especialmente por actores con recursos avanzados. Sin embargo, la adopción de estas soluciones representa un paso decisivo, especialmente cuando se ve apoyada por mecanismos de auditoría y transparencia que reducen drásticamente la superficie de ataque. Las implicaciones prácticas de esta tecnología son vastas.

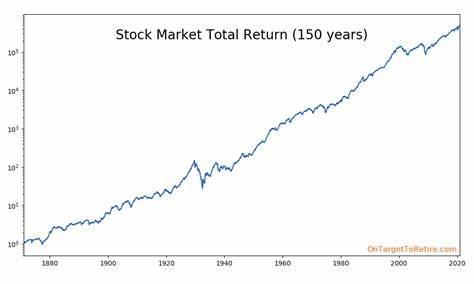

En ámbitos como la defensa, las finanzas o la salud, donde la confidencialidad y la integridad de las operaciones con IA son críticas, la capacidad de proveer evidencia verificable de la ejecución y las condiciones de generación de resultados es un avance disruptivo. Más allá del cumplimiento normativo, esto también contribuye a resolver preocupaciones éticas sobre la transparencia y responsabilidad en decisiones automatizadas. Mirando hacia el futuro, el desarrollo de pruebas de ejecución selladas puede integrarse con redes descentralizadas de confianza, donde múltiples hosts compartan carga de trabajo de inferencia bajo acuerdos consensuados que garanticen geolocalización, propiedad del hardware y cumplimiento de políticas regionales. Esta infraestructura podría permitir un ecosistema de IA con auditorías automatizadas y certifiquables, reforzando la soberanía digital y la protección de datos transfronterizos. Además, la computación sellada puede evolucionar incorporando monitoreos en tiempo real sobre el consumo de recursos de IA, permitiendo a distintos actores —como defensores de los derechos digitales, reguladores o usuarios finales autorizados— examinar cómo se utilizan las capacidades de los modelos y detectar posibles malas prácticas o desviaciones hacia resultados indeseados.

En conclusión, rastrear todas las salidas de inteligencia artificial hasta chips específicos mediante la computación sellada supone un salto tecnológico fundamental para la transparencia y seguridad de los sistemas inteligentes. Al proporcionar garantías verificables acerca de cuándo, dónde y con qué hardware se ejecutó una inferencia sin revelar detalles del modelo o la lógica interna, esta tecnología responde a las demandas actuales de confianza, regulación y ética en la inteligencia artificial. Impulsada por avances en enclaves confiables, protocolos criptográficos y sistemas operativos seguros, la computación sellada se perfila como un componente imprescindible para asegurar que las salidas de la IA sean auténticas y responsables, promoviendo un futuro donde el valor y la integridad de los datos derivados de la inteligencia artificial estén garantizados.