En el avance vertiginoso de la inteligencia artificial, los modelos de lenguaje de gran escala se han consolidado como herramientas esenciales en múltiples áreas que van desde la atención al cliente hasta la generación de contenido automático. Sin embargo, a pesar de sus grandes capacidades, estos modelos enfrentan un desafío crítico: la generación de información incorrecta o «alucinaciones». Detectar y mitigar estas alucinaciones es vital para garantizar la fiabilidad y seguridad de las aplicaciones basadas en inteligencia artificial. En este contexto, UQLM emerge como una solución innovadora para cuantificar la incertidumbre de estos modelos y así reducir el riesgo de errores en sus respuestas. UQLM, acrónimo de Uncertainty Quantification for Language Models, es una biblioteca en Python creada para detectar de manera eficiente y precisa las alucinaciones producidas por modelos de lenguaje, utilizando técnicas de cuantificación de incertidumbre de última generación.

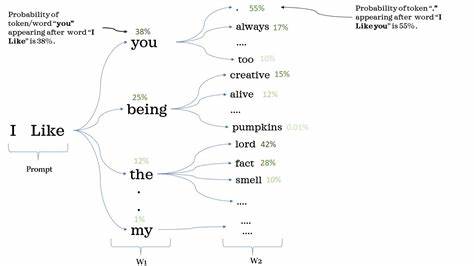

Su enfoque se basa en proporcionar una valoración objetiva sobre la confianza que se puede depositar en cada resultado generado por un modelo de lenguaje, permitiendo así a los desarrolladores y usuarios finales tomar decisiones informadas y mitigar las respuestas erróneas. Uno de los aspectos más destacados de UQLM es su capacidad de combinar metodologías diversas de cuantificación de incertidumbre, adaptándose tanto a modelos cuyos detalles internos son accesibles como a aquellos que operan en «cajas negras». En términos simples, UQLM ofrece herramientas para evaluar la calidad de una respuesta sin necesidad de conocer el funcionamiento interno del modelo o aprovechando información detallada como las probabilidades de los tokens generados. La biblioteca ofrece cuatro grandes categorías de evaluadores o «scorers» para llevar a cabo esta tarea. En primer lugar, los evaluadores “Black-Box” o de caja negra, que analizan la consistencia en múltiples respuestas generadas a partir de la misma entrada.

Estos métodos son universales, compatibles con cualquier modelo de lenguaje, y no requieren acceso a la arquitectura interna ni a los datos probabilísticos, aunque su uso implica una mayor latencia y costos asociados, debido a que generan múltiples resultados para comparar. Por otro lado, los evaluadores “White-Box” o de caja blanca aprovechan la información de las probabilidades de los tokens que el modelo genera en cada paso. Al acceder a estos datos, es posible estimar directamente la confianza en cada token y, por ende, en la respuesta completa. Este enfoque es más rápido y menos costoso, ya que no requiere múltiples llamadas al modelo, sin embargo está limitado a modelos que permitan acceder a esta información interna, lo que no siempre está disponible según la API o plataforma utilizada. Las siguientes herramientas disponibles en UQLM son los evaluadores basados en el concepto de “LLM-as-a-Judge” o modelo de lenguaje como juez.

Aquí, un modelo de lenguaje adicional o un panel de ellos evalúa la respuesta generada por otro modelo, calificando su fiabilidad. Esta estrategia es altamente personalizable mediante técnicas de ingeniería de prompts y la elección de los modelos jueces, facilitando un control más dinámico y contextual sobre la evaluación. La latencia y el costo pueden variar en función de la cantidad y complejidad de los jueces utilizados. Finalmente, UQLM también presenta un enfoque de conjuntos o «ensemble» de evaluadores, que combinan múltiples técnicas para obtener una valoración más robusta y precisa de la incertidumbre. Este método permite aprovechar las fortalezas individuales de cada evaluador y compensar sus debilidades, logrando un equilibrio óptimo entre precisión, costo y eficiencia.

El uso de UQLM es sencillo e intuitivo, especialmente para desarrolladores que utilizan LangChain, una popular biblioteca para la construcción de aplicaciones sobre modelos de lenguaje. Mediante ejemplos prácticos, UQLM demuestra cómo integrar sus evaluadores en procesos de generación y evaluación de texto, facilitando la detección automática de posibles alucinaciones y la selección de respuestas con menor riesgo. Esto es fundamental en aplicaciones críticas donde la confianza en la información generada es prioritaria, como en la medicina, asesoría legal o sistemas educativos. Entre los evaluadores Black-Box más reconocidos que incorpora UQLM se encuentran métricas como la probabilidad de no contradicción, entropía semántica, exactitud de coincidencia, BERT-score y similitud coseno entre respuestas. Estas métricas capturan diferentes dimensiones de la variabilidad y coherencia en las respuestas, ofreciendo un panorama integral de la incertidumbre sin depender del acceso directo al modelo.

En la categoría White-Box, destacamos evaluadores como la probabilidad mínima de token y la probabilidad conjunta normalizada por longitud, que permiten identificar respuestas o fragmentos con baja confianza, ofreciendo un indicador preciso del riesgo de error dentro del propio procesamiento del lenguaje. Respecto a los evaluadores basados en el enfoque LLM-as-a-Judge, UQLM ofrece desde evaluadores categóricos que clasifican la validez de las respuestas, hasta evaluadores continuos y paneles compuestos por múltiples modelos jueces que aportan una evaluación colaborativa y enriquecida. Este paradigma abre la puerta a la aplicación de diferentes perspectivas y especializaciones para refinar la calidad del juicio sobre las respuestas generadas. La flexibilidad de los evaluadores en conjunto permite además ajustar y sintonizar los parámetros para adaptarse a casos específicos o datasets particulares, optimizando aún más la capacidad de detectar hallazgos falsos o inconsistencias. Esto convierte a UQLM en una herramienta ideal para la investigación y desarrollo en inteligencia artificial confiable.

Por último, contar con documentación detallada, notebooks de ejemplo y demos para cada tipo de evaluador facilita su adopción y adaptación a proyectos reales. La comunidad detrás de UQLM es activa y contribuye constantemente a su mejora, incluyendo actualizaciones de seguridad y nuevas funcionalidades que amplían su alcance y utilidad. En resumen, UQLM representa un avance significativo en la arena de la inteligencia artificial responsable, al proporcionar mecanismos sofisticados para cuantificar la incertidumbre en las respuestas generadas por modelos de lenguaje. Su enfoque modular, la variedad de estrategias ofrecidas y su compatibilidad con diferentes entornos de desarrollo lo convierten en una herramienta imprescindible para quienes buscan garantizar la fiabilidad y seguridad en aplicaciones que dependan de inteligencia artificial conversacional o generativa. Con la creciente implementación de modelos de lenguaje en sectores sensibles, la capacidad para identificar y reducir las alucinaciones resulta crucial.

UQLM ofrece un enfoque riguroso y accesible para enfrentar este desafío, marcando un punto de inflexión hacia sistemas más transparentes y confiables. Explorar y adoptar esta tecnología no solo mejora la calidad de las soluciones basadas en inteligencia artificial, sino que también contribuye a una interacción más segura y efectiva entre humanos y máquinas.