En el dinámico mundo de la inteligencia artificial, los modelos de visión y lenguaje (VLM, por sus siglas en inglés) se han convertido en piezas fundamentales para diversas aplicaciones, desde la interpretación de imágenes hasta la generación automática de texto contextualizado. Sin embargo, entrenar y ajustar estos modelos suele requerir una gran cantidad de recursos computacionales y complejidad técnica, lo que limita su accesibilidad para investigadores y desarrolladores con hardware más modesto o menos experiencia técnica. En este contexto, nanoVLM emerge como un repositorio innovador, diseñado para simplificar y acelerar el proceso de entrenamiento y ajuste de modelos VLM de tamaño pequeño, mediante una implementación ligera en puro PyTorch. nanoVLM representa una respuesta directa a la necesidad de democratizar el acceso a la tecnología avanzada de modelos multimodales. Inspirado en la filosofía de simplicidad de proyectos como nanoGPT, nanoVLM ofrece un código base altamente legible y fácil de modificar, capaz de ejecutar tareas complejas con eficiencia y claridad.

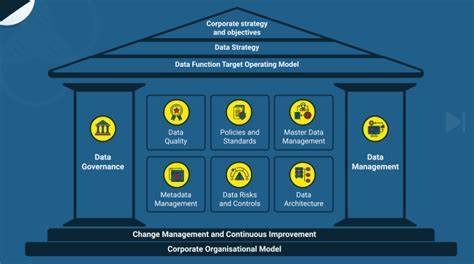

Esto hace que el aprendizaje, experimentación y personalización sean accesibles incluso para desarrolladores que recién comienzan o para aquellos que prefieren un entorno limpio y controlado sin dependencias adicionales. La estructura del repositorio está organizada de manera que cada componente esencial de un modelo VLM está claramente separado y explicado. Se compone principalmente de cuatro módulos: la columna vertebral visual (Vision Backbone), que se encarga de extraer características relevantes de las imágenes; el decodificador de lenguaje (Language Decoder) que genera texto basado en la entrada multimodal; la proyección de modalidad (Modality Projection), que unifica las representaciones de imagen y texto; y el propio modelo de visión y lenguaje (VisionLanguageModel) que une todos estos elementos para su entrenamiento y despliegue. Este diseño modular no solo facilita la comprensión, sino que también permite una gran flexibilidad para que los usuarios personalicen y ajusten cada parte según sus necesidades específicas. La implementación en PyTorch, uno de los frameworks de deep learning más utilizados y versátiles, garantiza compatibilidad y soporta optimizaciones que pueden aprovechar distintos hardware, desde GPUs de gama alta hasta configuraciones más modestas.

En términos de rendimiento, aunque nanoVLM no pretende establecer nuevos récords de precisión o eficiencia, sí logra encontrar un equilibrio entre simplicidad y potencia. Por ejemplo, utilizando los backbones SigLIP-B/16-224-85M y HuggingFaceTB/SmolLM2-135M, es posible entrenar el modelo nanoVLM de 222 millones de parámetros en poco menos de seis horas con un conjunto de datos de aproximadamente 1.7 millones de muestras. Esto resulta en un desempeño competitivo en benchmarks como MMStar, alcanzando una precisión del 35,3%, lo que es notable considerando los recursos limitados necesarios. El repositorio ofrece también herramientas para facilitar la medición del uso de memoria VRAM durante el entrenamiento, una información crítica para seleccionar el hardware adecuado y configurar los tamaños de batch (lote) óptimos.

Estas métricas son especialmente útiles para quienes trabajan con GPUs con memoria limitada, ya que permiten planificar de forma realista las sesiones de entrenamiento y evitar errores de memoria insuficiente. Además, la integración con Hugging Face Hub facilita la gestión y el despliegue de los modelos entrenados. Los usuarios pueden cargar modelos preentrenados directamente desde el repositorio, aprovechar pesos preexistentes para acelerar el ajuste fino o subir sus propios modelos tras el entrenamiento para compartirlos con la comunidad o para uso personal. Esta conectividad fomenta la colaboración y el intercambio de avances, acelerando el desarrollo colectivo en la comunidad de inteligencia artificial. La experiencia de usuario ha sido cuidadosamente considerada, permitiendo comenzar rápidamente mediante la clonación del repositorio, configuración sencilla del entorno (se recomienda la utilización del gestor de paquetes uv, aunque también se puede usar pip o cualquier otro gestor compatible) y ejecución inmediata de los scripts de entrenamiento o generación.

Incluso quienes no cuentan con hardware dedicado pueden explorar nanoVLM a través de notebooks interactivos en plataformas como Colab. NanoVLM no solo es una herramienta práctica, sino que también representa una plataforma educativa valiosa. Su código compactado en menos de 750 líneas para la definición y lógica de entrenamiento del modelo principal ayuda a los nuevos desarrolladores a entender los fundamentos de los modelos VLM sin sentirse abrumados. Esta educación práctica promueve una mejor comprensión del funcionamiento interno de los modelos multimodales y prepara a los usuarios para proyectos más complejos. Aunque el proyecto ya se encuentra en un estado maduro, los desarrolladores mantienen una hoja de ruta activa que incluye ambiciosos objetivos futuros como la implementación de evaluaciones más completas, soporte para entrenamiento multinúcleo y multi-GPU, manejo de múltiples imágenes simultáneamente y técnicas avanzadas como el image-splitting para trabajar con resoluciones superiores.

También se planea la integración con kits de evaluación específicos para VLM que permitirán realizar benchmarks más rigurosos y comparativos. Al mismo tiempo que promueve las contribuciones de la comunidad, el repositorio mantiene su enfoque en una implementación ligera y pura de PyTorch, rechazando la inclusión de dependencias demasiado pesadas que podrían complicar o ralentizar el código. Esto asegura que la simplicidad y la eficiencia sigan siendo la prioridad en todas las etapas de desarrollo. En conclusión, nanoVLM representa una opción excepcional para investigadores, desarrolladores y entusiastas de inteligencia artificial que desean adentrarse en el campo de los modelos de visión y lenguaje sin enfrentarse a la habitual complejidad que suelen presentar estos sistemas. Su simplicidad, rapidez y enfoque educativo lo coloca como una referencia para el entrenamiento y ajuste fino de modelos multimodales pequeños, accesibles desde una variada gama de hardware y niveles de experiencia.

Con la creciente demanda de aplicaciones que combinan visión y lenguaje y la constante evolución del ecosistema de IA, herramientas como nanoVLM se vuelven imprescindibles para impulsar la innovación y la accesibilidad. Su capacidad para proporcionar una base sólida y personalizable fomenta un desarrollo ágil, reduciendo barreras técnicas y permitiendo a la comunidad explorar nuevas posibilidades con mayor facilidad y confianza.

![Sobol' Sequences with Guaranteed-Quality 2D Projections [video]](/images/637368FB-1430-4FCA-832F-94DED3428FDE)