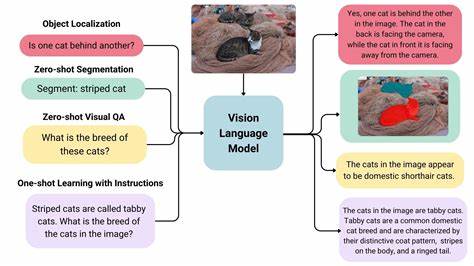

En el campo de la inteligencia artificial, la interacción entre la visión y el lenguaje ha alcanzado un nivel sin precedentes gracias a los avances en modelos visión-lenguaje a gran escala (LVLMs). Estas innovadoras arquitecturas permiten a las máquinas interpretar y procesar información visual junto con datos textuales para llevar a cabo tareas diversas, que van desde la descripción automática de imágenes hasta la respuesta compleja a preguntas contextuales. Sin embargo, a medida que estos sistemas han evolucionado, ha surgido un fenómeno conocido como "overthinking" o pensamiento excesivo, donde los modelos tienden a generar razonamientos extensos y a veces redundantes independientemente de la complejidad real de la tarea que se les plantea. Este comportamiento no solo afecta la eficiencia en el uso de recursos computacionales, sino que también puede impactar negativamente en la precisión y claridad de las respuestas proporcionadas. Ante este desafío, se ha desarrollado un marco innovador denominado FAST que propone un método dinámico y adaptativo para ajustar la profundidad del razonamiento según las características específicas de la pregunta o tarea.

La idea central detrás de FAST es inspirarse en el concepto psicológico del pensamiento rápido y lento, popularizado por Daniel Kahneman, pero aplicándolo al ámbito de los modelos de inteligencia artificial. El pensamiento rápido se refiere a procesos intuitivos, ágiles y automáticos, mientras que el pensamiento lento implica un análisis más profundo, deliberado y detallado. Al integrar estas dos formas de pensamiento, FAST busca optimizar el rendimiento de los modelos LVLM, reduciendo la generación excesiva de tokens sin sacrificar la exactitud de las respuestas. El desarrollo de FAST-GRPO, una implementación específica de esta metodología, engloba componentes clave como métricas basadas en el modelo para caracterizar las preguntas, un mecanismo adaptativo de recompensa que regula el nivel de razonamiento y una regularización consciente de la dificultad mediante la Kullback-Leibler (KL) para mantener un equilibrio adecuado entre aprendizaje y generalización. Estos elementos trabajan en conjunto para que el modelo pueda discernir automáticamente cuándo aplicar un razonamiento rápido y cuándo es necesario profundizar mediante un análisis más lento y elaborado.

Las pruebas experimentales que han evaluado este enfoque a través de siete benchmarks diferentes de razonamiento demuestran resultados sobresalientes. FAST no solo alcanza niveles de precisión superiores a los obtenidos por los modelos base, con una mejora relativa que supera el 10%, sino que también muestra una significativa reducción en el uso de tokens, comprendida entre el 32.7% y el 67.3% si se compara con enfoques previos de razonamiento lento. Esto implica no solo un ahorro notable en recursos computacionales, sino también una mayor velocidad y fluidez en la generación de respuestas.

La relevancia de FAST se extiende más allá de la mera optimización técnica. En un mundo donde el procesamiento multimodal es cada vez más necesario para aplicaciones cotidianas —como asistentes virtuales, sistemas de ayuda para personas con discapacidades y herramientas avanzadas para la creación de contenidos— lograr un equilibro entre rapidez y profundidad en el razonamiento es vital para ofrecer experiencias naturales y precisas. Por ejemplo, en sistemas de asistencia médica, una respuesta rápida puede ser crucial para preguntas simples, mientras que en diagnósticos más complejos se requiere un razonamiento lento y detallado. FAST permite atender esta variabilidad de forma automática y eficiente. Además, la incorporación de métricas de caracterización de preguntas dentro del modelo facilita su adaptabilidad a distintos dominios y tipos de preguntas, lo que potencia la generalización del sistema y su robustez frente a nuevos escenarios.

Esta característica es particularmente importante en entornos dinámicos donde las consultas del usuario pueden variar ampliamente en complejidad y contexto. El fundamento teórico y práctico detrás de FAST también invita a reflexionar sobre cómo los futuros sistemas de inteligencia artificial pueden diseñarse para emular patrones cognitivos humanos, adaptando su nivel de detalle y reflexión según el problema presentado. Este paradigma podría abrir nuevas puertas en la investigación de modelos híbridos que combinen rapidez y exhaustividad, superando limitaciones actuales y optimizando la experiencia del usuario final. En resumen, el enfoque de pensamiento rápido y lento para el razonamiento en modelos visión-lenguaje a gran escala representa un avance significativo en la eficiencia y efectividad de la inteligencia artificial. Combina la elegancia del análisis adaptativo con la potencia de las arquitecturas modernas para transformar la manera en que las máquinas entienden y responden a su entorno.

La implementación de frameworks como FAST promete no solo mejoras técnicas, sino también un impacto profundo en aplicaciones prácticas que dependen de la interacción multimodal, posicionándose como un hito en el camino hacia sistemas de inteligencia artificial más inteligentes, conscientes y útiles.

![CPL elementary programming manual [pdf]](/images/55871484-D7F2-408F-BFB8-13AD24B9CF06)