En el mundo del desarrollo de software, la calidad y la confiabilidad dependen en gran medida de las pruebas unitarias. Estas pruebas son la primera línea de defensa ante errores, garantizando que cada pieza del código funcione según lo esperado. Sin embargo, una pregunta que frecuentemente surge entre desarrolladores y equipos de calidad es si se deben utilizar datos hardcodeados (datos escritos literalmente en el código) dentro de estas pruebas o si deberían evitarse en favor de métodos más dinámicos o algoritmos alternativos. La discusión no es banal ni sencilla, pues implica comprender las complejidades del desarrollo, las necesidades de mantenimiento a largo plazo, y las mejores prácticas para obtener un software robusto y flexible. En este análisis profundo, exploraremos cuándo y por qué usar datos hardcodeados en pruebas unitarias, las consecuencias de hacerlo sin criterio, y posibles alternativas que superan sus limitaciones.

Decidir cómo manejar los datos de una prueba unitaria puede parecer a primera vista una cuestión técnica menor, pero tiene un impacto directo en la calidad del proyecto. En principio, usar datos hardcodeados facilita la creación y ejecución de pruebas. El programador define explícitamente qué salida es esperada para una entrada determinada y puede comparar el resultado del código con ese valor fijo para validar su correcto funcionamiento. Esta simplicidad y claridad hacen que la prueba sea fácil de entender y evaluar, lo que contribuye a una rápida detección de errores. Además, cuando la lógica es sencilla y el contexto estable, este método prácticamente no tiene fisuras.

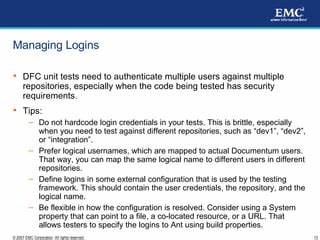

Sin embargo, la realidad en desarrollos complejos suele ser más desafiante. Cuando las aplicaciones crecen y se entrelazan múltiples módulos, mantener un gran volumen de datos hardcodeados para pruebas puede tornarse un problema. Cada cambio en la lógica puede afectar diversos puntos, generando discrepancias entre la salida actual y la esperada. Esto, por supuesto, obliga a que se actualicen los datos hardcodeados para reflejar el nuevo comportamiento. El inconveniente surge cuando muchas personas participan en el proyecto, se suceden diferentes desarrolladores y la memoria colectiva sobre la razón de ciertos datos desaparece.

En esas condiciones, reemplazar un archivo o dato hardcodeado para hacer pasar una prueba puede conducir a falsos positivos, donde los tests pasan sin que realmente se valide la corrección funcional del código. Este fenómeno, conocido como “teatro de pruebas unitarias”, produce la ilusión de un software saludable. Las pruebas devuelven resultados exitosos, pero en el fondo no detectan fallos relevantes porque el estándar de comparación se ha alterado sin un control riguroso. El impacto es grave: la confianza en la base de código disminuye, errores se filtran en etapas posteriores y la calidad del producto final es insuficiente. Por lo tanto, abusar o depender exclusivamente de datos hardcodeados puede ser un hundimiento silencioso que surge con el tiempo si no se planifica cuidadosamente.

Una alternativa interesante a los datos hardcodeados consiste en generar expectativas a partir de algoritmos paralelos, diseñados específicamente para las pruebas. En lugar de confiar en valores estáticos, la prueba ejecuta un algoritmo más sencillo, incluso deliberadamente menos eficiente, que calcula la salida esperada en base a la misma entrada. Esta comparación algorítmica permite verificar la congruencia lógica del código bajo prueba, ya que si ambas implementaciones producen la misma salida, la probabilidad de error es baja. Este enfoque ofrece varias ventajas claras. Primero, la verificación es más transparente.

El algoritmo de prueba, por su simplicidad, es más fácil de entender, revisar y validar manualmente. Esto facilita la identificación cuando las salidas no coinciden y dónde podría estar el problema, sin depender de memorias empresariales o archivos ocultos con datos obsoletos. Además, permite manejar entradas variables y escenarios no predefinidos, incrementando la cobertura real del test. En lugar de limitarse a validar un conjunto fijo y posiblemente incompleto de casos, la prueba evalúa la lógica bajo diversas condiciones, incluyendo aquellas no anticipadas inicialmente. Por otro lado, este método requiere un esfuerzo mayor a corto plazo para implementar un algoritmo de referencia fiable, y puede impactar en el tiempo de ejecución de las pruebas si no se optimiza adecuadamente.

Sin embargo, la inversión tiende a compensarse con creces a medida que el proyecto crece y el mantenimiento se vuelve más exigente. Además, la transparencia del método fortalece las capacidades de diagnóstico y resolución de fallos, evitando el ocultamiento inadvertido de problemas reales. Vale la pena destacar que tampoco se trata de un enfoque que deba adoptarse sin cuestionamientos. No existe una respuesta única o un “método infalible” que sirva para todos los contextos. Al contrario, la decisión adecuada depende de múltiples factores: el tamaño del proyecto, la estabilidad del código, la colaboración entre desarrolladores, la criticidad de las pruebas, el tiempo disponible para testeo, entre otros.

Sustituir por completo los datos hardcodeados sin analizar estas variables podría entorpecer la agilidad y generar costos innecesarios. Un punto adicional de reflexión es el propósito de las pruebas unitarias en el entorno real. Por ejemplo, algunas aplicaciones, como módulos de manejo de fechas y horarios, son especialmente sensibles a aspectos externos como la zona horaria, la configuración regional o el idioma. Forzar la ejecución de pruebas en un entorno controlado, como fijar la zona horaria a un único valor, puede asegurar la repetibilidad de los resultados y facilitar la automatización. No obstante, al hacerlo limitamos la capacidad de detectar errores surgidos en contextos internacionales o diversos, perdiendo oportunidades para garantizar la robustez universal del código.

Permitir que las pruebas se ejecuten en ambientes reales diversos, con distintas configuraciones regionales o locales, implica aceptar cierta incertidumbre en los resultados y enfrentarse a fallos inesperados. Sin embargo, este riesgo es positivo cuando se considera como una oportunidad para anticipar y corregir posibles incompatibilidades antes de que el software sea desplegado a audiencias globales. Así como asegurar estabilidad a corto plazo puede ser tentador mediante hardcodeo o entorno controlado, ofrecer cobertura real y versátil obliga a un balance inteligente y constante revisión. En síntesis, el debate sobre si se debe usar hardcode en pruebas unitarias no es blanco o negro. Ambas aproximaciones tienen sus méritos y limitaciones.

El hardcodeo ofrece simplicidad y eficiencia en la generación y evaluación inmediata de tests, mientras que la generación dinámica de expectativas mediante algoritmos auxiliares aporta flexibilidad, transparencia y mayor capacidad para adaptarse a cambios y escenarios variados. El mejor camino radica en combinar estrategias de forma consciente, evaluando el contexto específico y las consecuencias a largo plazo. Permitir cierto grado de repetición y hardcodeo controlado, como lo aconseja la metodología DRY (Don’t Repeat Yourself) flexibilizada en pruebas, puede ser saludable para mantener claridad y orden. Al mismo tiempo, incorporar validaciones basadas en algoritmos alternativos y ejecución en entornos representativos incrementa la confianza y la cobertura. En última instancia, la calidad del software no depende tanto del dogma acerca de codificar datos en pruebas, como de la inteligencia y experiencia con la que se diseñen y mantengan esas pruebas a lo largo del ciclo de vida del desarrollo.

Adaptar las herramientas y métodos a la realidad específica es la clave para obtener productos confiables, mantenibles y preparados para los desafíos del mundo real. Así que, la eterna cuestión del hardcodeo en pruebas unitarias no tiene una única respuesta correcta, sino una serie de consideraciones prácticas que cada equipo debe sopesar. Entender bien las ventajas y riesgos de cada enfoque es el primer paso para tomar decisiones efectivas, evitar pruebas vacías que no aportan valor y construir software que funcione realmente para los usuarios a lo largo del tiempo.