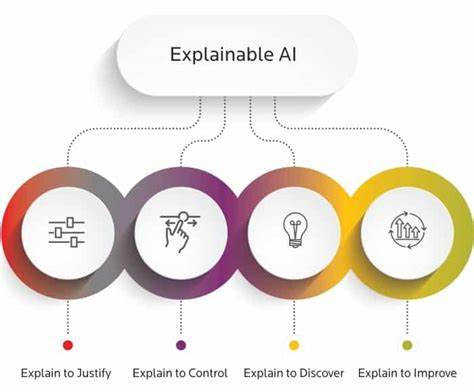

La inteligencia artificial (IA) ha transformado innumerables sectores, desde la medicina hasta las finanzas, pasando por la defensa y el ámbito legal. Sin embargo, a pesar de sus impresionantes capacidades, muchos modelos de IA, especialmente aquellos basados en aprendizaje automático profundo, son opacos en cuanto a la forma en que toman decisiones. Este fenómeno es comúnmente conocido como el problema de la “caja negra”, donde los usuarios y, en algunos casos, incluso sus creadores no pueden comprender claramente cómo se llegó a un resultado específico. En respuesta a esta dificultad, surge la Inteligencia Artificial Explicable (XAI, por sus siglas en inglés), un campo emergente que busca dotar de transparencia, interpretabilidad y explicaciones entendibles a los sistemas de IA para asegurar un mayor control humano y confianza en sus resultados. La importancia de la inteligencia artificial explicable radica en la necesidad que tienen los usuarios y las organizaciones de entender las razones detrás de las decisiones automatizadas.

Este entendimiento permite evaluar la seguridad y la equidad de los algoritmos, realizar auditorías de posibles sesgos y, en general, fomentar la confianza en sistemas cada vez más complejos. La transparencia no solo se vuelve esencial en aplicaciones cotidianas, sino en ámbitos críticos como el diagnóstico médico, donde un médico debe entender por qué un sistema recomendó un tratamiento específico, o en procesos legales y financieros, donde las decisiones automatizadas pueden afectar profundamente a individuos y comunidades. La diferencia conceptual entre transparencia, interpretabilidad y explicabilidad es importante para entender el alcance y los desafíos de XAI. La transparencia se refiere a que los procesos internos del modelo — desde cómo se entrenó hasta cómo realiza predicciones — sean entendibles y accesibles. Los modelos transparentes son a menudo denominados "de caja blanca", pues permiten a los expertos comprender plenamente sus mecanismos.

La interpretabilidad, en cambio, enfatiza en la capacidad del usuario para comprender y razonar sobre el resultado que produce un modelo, mientras que la explicabilidad es un concepto más amplio que incluye aquellas características que permiten esclarecer qué información influyó en una decisión específica del sistema, incluso si el modelo completo no es transparente. Dentro de la inteligencia artificial, los modelos pueden clasificarse como blancos o negros dependiendo de su nivel de explicabilidad. Los modelos blanco son aquellos que ofrecen estructuras intrínsecamente interpretables, como los árboles de decisión o modelos lineales simples. Por el contrario, los modelos de caja negra como las redes neuronales profundas o los ensamblados suelen ser altamente precisos, pero difíciles de interpretar. Por ello, muchas investigaciones actuales se centran en desarrollar métodos para explicar las predicciones de estos modelos complejos sin sacrificar su rendimiento.

Existen diversas técnicas de XAI que permiten dotar de explicaciones a modelos complejos. Por ejemplo, los gráficos de dependencia parcial muestran cómo cambia la predicción cuando se altera una característica de entrada. SHAP (SHapley Additive exPlanations) es una herramienta muy popular que calcula la contribución de cada variable al resultado final, basándose en la teoría de juegos para asignar un valor justo a cada característica. Asimismo, LIME (Local Interpretable Model-agnostic Explanations) aproxima el comportamiento del modelo localmente con uno sencillo y explicable. Para análisis de imágenes, los mapas de saliencia indican qué regiones del input fueron relevantes para la decisión.

En el caso de modelos generativos y lenguaje natural, como los transformadores preentrenados, las técnicas más tradicionales no siempre son aplicables. En este campo se han desarrollado métodos como el análisis de atención, la identificación de circuitos neuronales o técnicas de sondeo que buscan entender qué representa cada parte de la red y cómo influye en la salida. Aunque estos avances proporcionan herramientas poderosas, la explicabilidad en modelos de lenguaje sigue siendo un desafío activo y crucial para evitar comportamientos indeseados como sesgos o manipulaciones. La historia de la inteligencia artificial explicable se remonta a décadas atrás, con sistemas expertos y simbólicos que podían justificar sus diagnósticos o recomendaciones basándose en reglas explícitas. Programas pioneros como MYCIN en los años setenta diagnosticaban infecciones bacterianas y explicaban sus razonamientos a través de reglas codificadas manualmente.

Las investigaciones posteriores en sistemas de mantenimiento de la verdad ampliaron estas capacidades al trazar y justificar líneas de razonamiento para evitar contradicciones. Sin embargo, con la popularización del aprendizaje profundo, se perdió esa transparencia inicial, dando pie a un renovado interés por desarrollar métodos que puedan abrir las cajas negras modernas. La inteligencia artificial explicable no solo involucra aspectos técnicos, sino también legales y éticos. Por ejemplo, la Unión Europea incorporó en el Reglamento General de Protección de Datos (GDPR) el llamado “derecho a la explicación”, que otorga a los usuarios el derecho a entender cómo funcionan los algoritmos que procesan sus datos personales. De forma similar, en países como Francia o Estados Unidos, se establecen requerimientos de transparencia para sectores regulados, como el asegurador, que requieren justificar decisiones de cobertura o tarifas.

Estos marcos regulatorios impulsan el desarrollo de XAI para cumplir con exigencias que protejan los derechos individuales y la justicia social. No obstante, existen limitaciones y desafíos inherentes a la inteligencia artificial explicable. Por un lado, hacer un modelo demasiado interpretable puede implicar sacrificar la precisión o capacidad de generalización. Por otro lado, exponer demasiada información acerca del funcionamiento interno del sistema puede hacer que una organización sea vulnerable a adversarios capaces de explotar esta información para manipular resultados o replicar la tecnología. Además, adaptar las explicaciones a diferentes perfiles de usuarios es una tarea compleja, ya que expertos precisan detalles técnicos profundos y usuarios finales requieren explicaciones claras, concisas y accesibles.

También hay un reto en equilibrar la complejidad técnica de los modelos con la simplicidad de las explicaciones proporcionadas. Las explicaciones excesivamente simplificadas pueden resultar engañosas, mientras que las detalladas suelen ser inaccesibles para personas sin formación técnica. Por ello se debate sobre la mejor forma de presentar estas explicaciones, buscando formas intuitivas, quizás con soporte visual or interactivo, que permitan al usuario calibrar su confianza en el sistema de acuerdo al contexto y sus necesidades. Desde el punto de vista psicológico y social, la explicabilidad no garantiza automáticamente que los usuarios confíen en los sistemas de IA. Se ha detectado que incluso cuando las personas entienden cómo funciona un algoritmo, pueden mantener escepticismo hacia sus decisiones, especialmente si estas impactan directamente en sus vidas, como en admisiones universitarias o decisiones judiciales.

Este fenómeno indica que XAI debe complementarse con otras estrategias para fomentar relaciones de confianza y promover una aceptación ética y responsable de la inteligencia artificial. Por otra parte, en el campo de la racionalidad social y la teoría de la elección, la explicabilidad también adquiere relevancia. El estudio de cómo se pueden justificar los resultados en procesos colectivos, como sistemas de votación o presupuestos participativos, se basa en axiomas claramente establecidos que permiten generar explicaciones convincentes y que refuerzan la legitimidad y equidad del proceso. Así, el XAI también extiende su ámbito más allá del aprendizaje automático, hacia la toma de decisiones sociales complejas. En definitiva, la inteligencia artificial explicable representa un paso fundamental hacia sistemas más responsables, éticos y confiables.

La apuesta por modelos transparentes y explicables fomenta una mayor comprensión humana, lo que es esencial para supervisar, auditar y mejorar las tecnologías que cada vez más determinan aspectos importantes de nuestras vidas. Si bien persisten desafíos técnicos, sociales y regulatorios, el avance continuo en este campo promete abrir las cajas negras del aprendizaje automático, garantizando que la innovación en IA vaya de la mano con la confianza y el control humano. El futuro de la inteligencia artificial no solo estará definido por su capacidad para aprender y predecir con precisión, sino también por su habilidad para explicar y justificar sus decisiones. El desarrollo de técnicas que hagan esto posible se perfila como uno de los pilares para alcanzar una inteligencia artificial verdaderamente humana y alineada con los valores sociales.