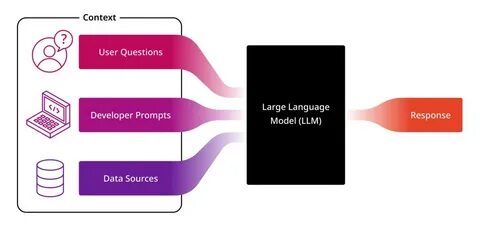

En el panorama actual de la inteligencia artificial, los modelos de lenguaje grandes (LLMs) han demostrado habilidades sorprendentes que trascienden el procesamiento exclusivo de texto. Tradicionalmente, se ha pensado que estos modelos requieren entrenamiento adicional para comprender modalidades distintas al texto, como imágenes o audio. Sin embargo, investigaciones recientes han revelado que los LLMs pueden, sorprendentemente, ver y escuchar sin ningún entrenamiento específico para estas tareas. Este avance representa un cambio paradigmático que abre nuevas puertas a aplicaciones innovadoras y a una comprensión más profunda del procesamiento multimodal. El concepto clave detrás de esta capacidad radica en la integración de modalidades múltiples mediante técnicas ingeniosas que combinan el poder lingüístico con representaciones visuales y auditivas.

Los LLMs, originalmente diseñados para entender y generar lenguaje natural, están siendo habilitados para procesar señales visuales y auditivas sin la necesidad de remodelar el modelo o someterlos a rigurosos procesos de entrenamiento con datos especializados de cada modalidad. Una de las iniciativas más destacadas en esta área es el proyecto MILS (Multimodal Inference via Language Supervision), el cual ha sido presentado en la comunidad académica como una implementación oficial que aprovecha las capacidades inherentes de los LLMs para interpretar imágenes, videos y audios directamente. La clave de MILS está en que utiliza datos textuales generados a partir de otras modalidades para alimentar al modelo, permitiéndole generar descripciones precisas y coherentes sin entrenamiento explícito con datos visuales o auditivos. ¿Pero cómo es posible que un modelo centrado en el lenguaje pueda comprender imágenes o sonidos sin entrenamiento? La respuesta se encuentra en cómo se representa y traduce la información no textual en formatos que el LLM pueda procesar eficazmente. Por ejemplo, en la visión computacional, los datos de imágenes pueden ser convertidos en representaciones textuales, como etiquetas o descripciones iniciales, que luego son interpretadas y enriquecidas por el modelo.

En cuanto al audio, mediante técnicas de captioning, los sonidos pueden transformarse en transcripciones o descripciones narrativas que activan la comprensión semántica del LLM. Este proceso no solo amplía la funcionalidad del modelo, sino que también reduce significativamente la necesidad de contar con grandes bases de datos multimodales para el entrenamiento, un aspecto que habitualmente demandaba tiempo y recursos escasos. El enfoque de MILS permite realizar inferencias y generar contenido a partir de imágenes, audio y video, únicamente apoyándose en la capacidad del LLM para entender texto, lo cual representa un ahorro notable y mayor flexibilidad. Desde la perspectiva tecnológica, este avance está impulsando el desarrollo de herramientas de captioning para imágenes y audios que no dependen de arquitecturas entrenadas específicamente para esas tareas, sino que pueden ser gestionadas por modelos generales de lenguaje. Esto facilita, por ejemplo, la generación automática de descripciones para fotos en redes sociales, la transcripción y etiquetado de contenidos audiovisuales, o la creación de prompts para generación de imágenes a partir del lenguaje natural.

En el ámbito del procesamiento de video, la capacidad de los LLMs para interpretar secuencias visuales y auditivas sin entrenamiento específico abre caminos para aplicaciones en vigilancia, producción multimedia, y análisis contextual en tiempo real. Al transformar los datos audiovisuales en texto descriptivo, los modelos pueden proporcionar un entendimiento más accesible y manipulable para tareas posteriores, como la generación de resúmenes o la mejora en algoritmos de búsqueda y clasificación. En cuanto al impacto en el desarrollo y la innovación, la posibilidad de desplegar modelos generalistas que comprendan múltiples modalidades sin entrenamiento adicional facilita la creación de sistemas más versátiles y adaptativos. Las empresas y desarrolladores pueden integrar estas tecnologías con menor inversión, acelerando la implementación de asistentes virtuales capaces de interpretar y responder a estímulos visuales o auditivos de forma mucho más natural e intuitiva. Sin embargo, estos avances también plantean desafíos y preguntas relevantes.

La interpretación correcta y coherente de la información visual y auditiva desde estructuras textuales puede enfrentar limitaciones en contextos complejos o con datos ruidosos. Además, la ausencia de entrenamiento específico puede causar ciertas imprecisiones o malentendidos en la generación de contenido multimodal, lo que sugiere la necesidad de perfeccionar estos métodos y complementar el sistema con mejoras en preprocesamiento y ajuste fino. Otro aspecto fundamental es la ética y privacidad relacionadas con la capacidad de captar y comprender imágenes y sonidos sin restricciones. El uso responsable de estas tecnologías debe garantizar que los datos sensibles sean protegidos y que el procesamiento automatizado no vulnere derechos ni genere consecuencias negativas para los usuarios. La comunidad científica está explorando con entusiasmo estas posibilidades, trabajando en mejorar la robustez y precisión de los LLMs multimodales, así como en ampliar el espectro de aplicaciones prácticas.