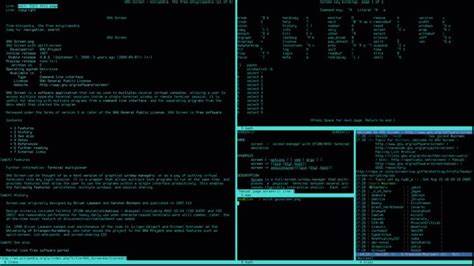

En la intersección entre la biología y la inteligencia artificial, los modelos de lenguaje emergen como herramientas poderosas para predecir la viabilidad y aptitud de secuencias biológicas tales como proteínas y ácidos nucleicos. Estos modelos, entrenados sobre grandes conjuntos de datos, aprenden las reglas complejas que gobiernan la estructura y función de estas secuencias, proporcionando un valor de probabilidad o likelihood que se asocia con la capacidad funcional o evolución favorable de dichas secuencias. Sin embargo, recientes investigaciones muestran que el aprendizaje en contexto puede distorsionar esta relación entre la probabilidad estimada por el modelo y la aptitud biológica real, un fenómeno que genera importantes desafíos para la interpretación y aplicación de estas tecnologías. El aprendizaje en contexto se refiere a la habilidad de los modelos lingüísticos, típicamente de arquitectura transformer, para adaptar su inferencia basándose en patrones y ejemplos dados dentro del mismo input, sin necesidad de reentrenamiento explícito. En el terreno de las secuencias biológicas, este tipo de aprendizaje puede hacer que el modelo utilice información fragmentaria del entorno inmediato de una secuencia para predecir con mayor precisión los elementos faltantes.

Aunque esta capacidad impulsa la eficacia predictiva, también desencadena sesgos específicos que pueden inflar artificialmente las probabilidades asignadas a ciertas secuencias, especialmente aquellas que contienen motivos repetitivos. Los motivos repetidos en secuencias biológicas son inherentes a múltiples funciones biológicas y estructuras. Sin embargo, durante el aprendizaje en contexto, los modelos de lenguaje pueden caer en la trampa de la redundancia, sobreestimando la probabilidad de secuencias que simplemente repiten un patrón ya presente en la entrada. Este sesgo no refleja necesariamente una mayor aptitud biológica, sino más bien un artefacto computacional. La consecuencia directa es que una secuencia con repeticiones reiteradas puede recibir una puntuación de likelihood anormalmente alta incluso cuando la viabilidad biológica experimentalmente verificada no corrobora tal predicción.

Este fenómeno es particularmente notorio en modelos basados en transformadores entrenados con la tarea de enmascarar tokens o aminoácidos para su predicción posterior. Los transformadores, mediante su mecanismo de atención, identifican relaciones globales dentro del input, lo cual es extremadamente útil para captar dependencias de largo alcance en secuencias biológicas. Sin embargo, cuando se enfrentan a elementos repetitivos, esta atención puede actuar como una operación de búsqueda, utilizando una copia del motivo repetido como una referencia para predecir con alta confianza el otro, incrementando así artificialmente la probabilidad asignada. Además, esta tendencia a la sobrevaloración de secuencias repetidas no solo se restringe a motivos exactos, sino que también se extiende a secuencias similares con pequeñas variaciones, y a otros patrones biológicamente relevantes, como los motivos en ARN que forman estructuras secundarias complejas como horquillas o complementos reversos. Esto sugiere que el sesgo inducido por el aprendizaje en contexto es un fenómeno generalizado que afecta diversas formas de información estructurada en datos biológicos.

Desde el punto de vista práctico, este conocimiento implica que la interpretación de las puntuaciones de probabilidad producidas por los modelos de lenguaje en biología debe hacerse con cautela. Las métricas convencionales que vinculan una alta probabilidad con una alta aptitud pueden no ser plenamente confiables en presencia de patrones repetitivos. Esto debería incentivar a investigadores y desarrolladores a complementar estas predicciones con experimentos biológicos o con métricas alternativas que puedan discriminar mejor entre artefactos computacionales y verdaderos indicadores biológicos. Para mitigar este problema, una vía prometedora es ajustar las arquitecturas de los modelos o los procedimientos de inferencia para reducir el efecto de las repeticiones. Esto puede incluir la incorporación de regularizaciones específicas, modificar las estrategias de atención para penalizar la redundancia o implementar mecanismos explícitos para reconocer y ajustar la influencia de motivos repetidos durante el cómputo de probabilidades.

Otra estrategia puede consistir en enriquecer los datos de entrenamiento con ejemplos que permitan al modelo aprender a distinguir entre probabilidad y aptitud verdadera, promoviendo así predicciones más robustas y precisas. En términos más amplios, este hallazgo arroja luz sobre las limitaciones actuales de aplicar modelos de lenguaje avanzados en contextos biológicos complejos. La capacidad de estos modelos para capturar patrones estadísticos no siempre se traduce en una comprensión biológica profunda. La distorsión provocada por el aprendizaje en contexto enfatiza la necesidad de evaluar críticamente las salidas de la inteligencia artificial en biología antes de su aplicación directa en investigación experimental o diseño biomolecular. Por último, la interacción entre los mecanismos computacionales del aprendizaje automático y los fenómenos naturales presentes en datos biológicos subraya la importancia de un enfoque interdisciplinario.

La colaboración entre expertos en informática, biología molecular, bioinformática y estadística puede facilitar el desarrollo de modelos más sofisticados y metodologías analíticas que reconozcan y corrijan las distorsiones identificadas. En conclusión, aunque los modelos de lenguaje han revolucionado la predicción y diseño de secuencias biológicas, el aprendizaje en contexto introduce distorsiones significativas que afectan la relación entre las probabilidades asignadas por el modelo y la auténtica aptitud biológica. Reconocer y abordar este desafío es fundamental para el avance confiable de la biología computacional y la biotecnología basada en inteligencia artificial, garantizando que las predicciones sean tanto estadísticamente válidas como biológicamente relevantes.