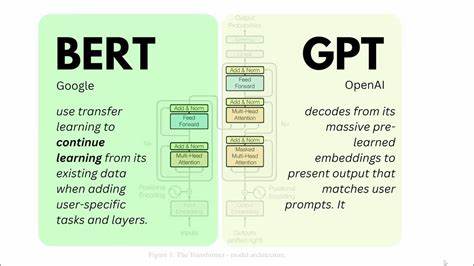

En la era moderna de la inteligencia artificial, los grandes modelos de lenguaje (LLM) han redefinido la forma en que procesamos, entendemos y generamos texto. Su capacidad para generar anotaciones y etiquetas hace que muchos investigadores y profesionales consideren usar estos datos sintéticos para entrenar modelos más pequeños y eficientes, como los clasificadores basados en BERT. Sin embargo, emplear anotaciones generadas por LLM para entrenar modelos encoder-only no está exento de riesgos y complejidades que deben ser cuidadosamente evaluados antes de implementarse en aplicaciones reales. Los LLM, debido a su arquitectura y tamaño, pueden generar etiquetas sintéticas para conjuntos de datos, que luego se utilizan como sustitutos de las anotaciones manuales realizadas por expertos. Esta metodología promete acelerar el proceso de etiquetado y reducir costos, especialmente en tareas de clasificación de texto.

No obstante, estudios recientes evidencian que al alimentar a modelos BERT con estas etiquetas generadas automáticamente, surgen problemas significativos que afectan la precisión, estabilidad y confiabilidad del modelo final. Uno de los principales desafíos que se detecta es la llamada 'maldición de entrenar con datos sintéticos'. En esencia, cuando un clasificador BERT se entrena con etiquetas no originales, sino inferidas por otro modelo como un LLM, se introducen errores inherentes que no son aleatorios, sino sistemáticos. Estas imperfecciones propagan sesgos y confusiones en el entrenamiento, causando una disminución notoria en métricas clave como la precisión y la puntuación F1. Esto significa que, aunque un modelo BERT entrenado con anotaciones reales logra un nivel de desempeño estable y confiable, aquel que depende de etiquetas LLM suele mostrar resultados más bajos y erráticos.

Otro problema inherente es la inestabilidad que acompaña a los modelos entrenados con etiquetas LLM. Los ensayos y evaluaciones indican que estos modelos no solo presentan una disminución en el rendimiento promedio, sino que además sufren de fluctuaciones significativas entre diferentes corridas de entrenamiento. Esta variabilidad dificulta la reproducibilidad y genera incertidumbre sobre la verdadera capacidad del modelo para generalizar a datos no vistos. Además, se ha detectado que estos modelos pueden alcanzar un punto de inflexión prematuro en su curva de aprendizaje, donde la mejora en el desempeño se estanca rápidamente aunque se continúe entrenando. Este fenómeno se relaciona con la propagación de errores no aleatorios provenientes del LLM, los cuales limitan la capacidad del clasificador BERT para aprender representaciones más profundas y generalizables del texto.

Estos aspectos plantean serias dudas sobre la confiabilidad de usar etiquetas generadas por LLM en contextos donde la precisión y robustez son esenciales, especialmente en sectores con alto riesgo como el análisis jurídico, el diagnóstico médico o la moderación de contenido en redes sociales. Para entender mejor estas manifestaciones, se hace necesaria una perspectiva basada en la teoría de la propagación de errores. Cuando una fuente de datos sintéticos presenta sesgos o errores sistemáticos, estos se transfieren y amplifican en la cadena de aprendizaje, contamindado la retroalimentación y limitando la capacidad adaptativa del modelo. En este contexto, los errores no son causados por ruido aleatorio, sino por patrones de equívocos inherentes al modelo generador, lo que dificulta su corrección automática. Frente a estos desafíos, se han propuesto varias estrategias para mitigar los riesgos asociados con el uso de anotaciones LLM.

Una de las técnicas más prometedoras es el filtrado basado en entropía, que consiste en evaluar la certeza de las etiquetas generadas y descartar aquellas asignaciones con alto grado de incertidumbre. Este método reduce la cantidad de etiquetas incorrectas que llegan al proceso de entrenamiento, aunque no elimina por completo el problema. Otra aproximación consiste en el uso de técnicas de ensamblado o ensemble, donde se combinan múltiples modelos o predicciones para suavizar errores específicos de cada modelo individual. El ensamblado puede mejorar la estabilidad y ofrecer un rendimiento algo más consistente, pero aún depende de la calidad relativa de las anotaciones sintéticas y la diversidad de los modelos involucrados. Es fundamental destacar que estas heurísticas ofrecen mejoras parciales y no resuelven completamente el problema que subyace en la propagación de errores no aleatorios.

Por consiguiente, la comunidad científica y tecnológica recomienda ejercer precaución antes de implementar este flujo de trabajo en escenarios críticos y de alto impacto, donde una mala decisión o una clasificación errónea puede desencadenar consecuencias significativas. En resumen, aunque el uso de anotaciones generadas por grandes modelos de lenguaje para entrenar clasificadores BERT representa una posibilidad atractiva en términos de eficiencia y escalabilidad, sus riesgos y limitaciones no deben ser subestimados. Se requiere un análisis riguroso de la naturaleza de los errores introducidos, su influencia en el entrenamiento y la adopción de estrategias de mitigación efectivas para salvaguardar la calidad y fiabilidad del modelo. De cara al futuro, la investigación debería centrarse en desarrollar metodologías más robustas para validar y corregir anotaciones sintéticas, así como en diseñar arquitecturas híbridas que combinen lo mejor de los LLM con la especialización y eficiencia de modelos encoder-only. Asimismo, se impone la necesidad de establecer marcos éticos y normativos que regulen el uso de datos generados artificialmente en aplicaciones sensibles.

Finalmente, para profesionales y organizaciones que deseen aprovechar esta técnica, la recomendación es combinar siempre los datos sintéticos con una porción significativa de anotaciones humanas verificadas, emplear técnicas de filtrado rigurosas y realizar evaluaciones exhaustivas y repetidas antes de desplegar cualquier modelo entrenado bajo este esquema en producción. Solo así se podrá garantizar un equilibrio adecuado entre innovación, eficiencia y confiabilidad en la clasificación automática de texto.