En el mundo actual, donde la automatización y la inteligencia artificial avanzan a pasos agigantados, la interacción precisa con interfaces gráficas de usuario (GUI) se ha convertido en una necesidad para optimizar procesos y tareas que antes requerían intervención manual constante. ByteDance, reconocido gigante tecnológico, ha desarrollado UI-TARS, un agente multimodal de código abierto que se posiciona como una solución innovadora para la automatización avanzada de tareas en entornos virtuales. UI-TARS integra capacidades de visión y lenguaje para interpretar, razonar y llevar a cabo acciones con una eficiencia y adaptabilidad sorprendentes, marcando un antes y un después en la forma en que los sistemas automáticos interactúan con las GUI. UI-TARS-1.5 es la versión más reciente y destacada de este agente inteligente, diseñada sobre una arquitectura potente que habilita un razonamiento avanzado mediante el aprendizaje por refuerzo.

Esta integración permite que el modelo analice y reflexione sobre sus propias decisiones antes de ejecutar acciones, mejorando drásticamente su rendimiento y la capacidad de adaptarse a distintos escenarios y complejidades durante la ejecución en tiempo real. Dicho enfoque intelectual dota al agente de una robustez en la inferencia que supera a modelos anteriores y establece nuevas referencias en benchmarkings estándar del sector. El despliegue de UI-TARS es accesible y eficiente para desarrolladores y usuarios avanzados interesados en incorporar automatización inteligente en sus sistemas. La instalación se simplifica mediante paquetes disponibles en PyPI, facilitando su integración con plataformas como Hugging Face para despliegue en endpoints o mediante ejecución local. La documentación oficial ofrece orientación paso a paso, desde la configuración inicial hasta el procesamiento avanzado de predicciones que permiten traducir las respuestas del agente en comandos concretos para gestionar dispositivos y software.

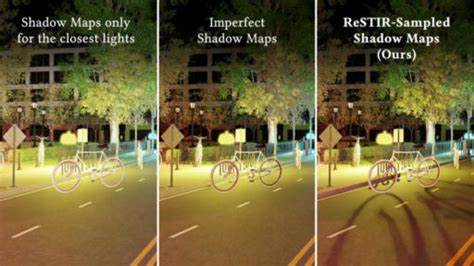

Una característica esencial de UI-TARS es su manejo impecable de las coordenadas absolutas dentro de las interfaces. Este mecanismo es crucial para la precisión en la interacción con objetos gráficos distribuidos en pantallas de distintos tamaños y resoluciones. La guía de visualización proporcionada ayuda a comprender cómo se procesan estas coordenadas, mejorando la confianza y la exactitud de las acciones tomadas por el agente. Esta atención al detalle es fundamental para aplicaciones que requieren manipulación exacta, como clics de mouse, arrastres y entradas de texto. El agente UI-TARS se adapta a múltiples entornos y dispositivos gracias a diversos esquemas de prompts especialmente diseñados.

Por ejemplo, en un entorno de escritorio tradicional —Windows, Linux, o macOS— se utilizan prompts que soportan una amplia gama de operaciones comunes como clics simples, dobles, clic derecho, arrastrar, atajos de teclado, introducción de texto y desplazamiento. Estos permiten automatizar desde la navegación por navegadores web hasta gestión de archivos y uso de software de oficina. Para dispositivos móviles, UI-TARS ofrece una plantilla adaptada que contempla acciones específicas como pulsación larga, apertura y cierre de aplicaciones, y navegación en la interfaz de usuario de Android. Esto facilita la automatización de tareas en teléfonos inteligentes y emuladores, permitiendo desde la simulación de interacciones hasta la automatización completa de flujos de trabajo dentro de aplicaciones móviles. En aplicaciones donde se requiere únicamente la acción sin razonamiento intermedio, se dispone de un esquema de grounding para evaluar la capacidad de respuesta directa del agente y su precisión en la generación de comandos para la interfaz gráfica.

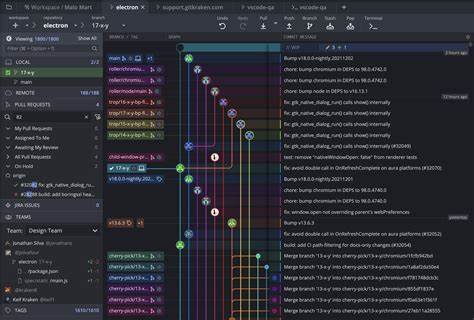

Esta flexibilidad en la interacción hace que UI-TARS sea una herramienta versátil apta para desarrollo, pruebas y evaluación de agentes multimodales. Las evaluaciones de desempeño de UI-TARS-1.5 destacan su superioridad en varios benchmarks que abarcan desde el uso tradicional en computadoras, pasando por navegadores, hasta interacción en dispositivos móviles. En escenarios de uso en sistemas de escritorio, UI-TARS supera notablemente a modelos anteriores y competidores como OpenAI CUA y Claude 3.7, alcanzando una eficiencia más alta en la ejecución de tareas automatizadas.

En el ámbito del navegador, aunque mantiene un rendimiento competitivo, el agente muestra especial fortaleza para tareas específicas de automatización computacional y gestión de interfaces complejas. La capacidad de grounding, o localización precisa de elementos en la GUI, es otro punto fuerte del sistema. UI-TARS demuestra resultados excepcionales en benchmarks como ScreenSpot-V2 y ScreenSpotPro, donde su precisión para identificar componentes gráficos y traducirlos en acciones concretas es significativamente mejor que opciones previas, reflejando el impacto de su arquitectura multimodal y del aprendizaje aplicado. En el terreno de los videojuegos, UI-TARS-1.5 se distingue por su sobresaliente desempeño en ambientes complejos y dinámicos.

Pruebas realizadas en juegos populares, como Poki o Minecraft, revelan que el agente puede no solo ejecutar movimientos y acciones básicas, sino también adaptarse a estrategias y objetivos más elaborados, incrementando con ello la eficacia y el alcance de la inteligencia aplicada. En títulos de Minecraft, por ejemplo, la integración del razonamiento en las acciones permite superar considerablemente a otros modelos como VPT o DreamerV3, progresando en la realización de tareas complejas como minería, combate y construcción. No obstante, es importante reconocer que UI-TARS-1.5 presenta ciertas limitaciones inherentes a su complejidad y campo de aplicación. Su uso indebido para automatizar accesos no autorizados o superar medidas de seguridad en sistemas protegidos se considera un riesgo potencial, por lo que ByteDance está implementando rigurosos controles internos y evaluaciones de seguridad para mitigar estos escenarios.

Adicionalmente, el requerimiento computacional sigue siendo elevado, especialmente cuando se emplean en situaciones prolongadas o con numerosos elementos gráficos simultáneos. Otra limitación se refiere al fenómeno conocido como "alucinación" en inteligencia artificial, donde el agente puede generar interpretaciones erróneas, identificar incorrectamente componentes GUI o adoptar acciones subóptimas por inferencias poco precisas, algo que puede ocurrir en contextos ambiguos o desconocidos para el modelo. Finalmente, a pesar del lanzamiento de una versión reducida (UI-TARS-1.5-7B) para facilitar el acceso y la integración, esta está orientada principalmente a tareas generales y no refleja completamente el poder completo del agente en escenarios exigentes como juegos, donde el modelo completo mantiene una ventaja considerable. En cuanto al futuro, ByteDance mantiene una visión ambiciosa para UI-TARS, incrementando su sofisticación y capacidad peractiva para gestionar acciones reales más allá de entornos virtuales.

Se espera que esto abra la puerta a aplicaciones avanzadas en automatización de plataformas, facilitando tareas complejas con una autonomía sin precedentes. Asimismo, la empresa fomenta la colaboración con la comunidad investigadora mediante acceso temprano a sus modelos y una comunicación abierta para ampliar el desarrollo y la adopción del agente. Con su arquitectura innovadora, capacidades multimodales y un enfoque riguroso en el razonamiento mediante aprendizaje reforzado, UI-TARS establece un nuevo estándar en la interacción automatizada con GUIs. Este agente representa una herramienta invaluable tanto para la investigación como para la aplicación práctica en automatización de tareas, juegos, navegación web y gestión de dispositivos móviles. Su código abierto fortalece la accesibilidad y promueve la evolución conjunta de tecnologías inteligentes orientadas a la relación fluida entre humanos, máquinas y entornos digitales.

Este avance tecnológico de ByteDance no solo impulsa la automatización sino que también marca tendencias en el diseño de agentes conversacionales y multimodales que entienden y actúan en el mundo digital con mayor precisión y eficiencia. Al ofrecer capacidades que combinan visión, lenguaje y razonamiento, UI-TARS abre camino hacia futuras soluciones cada vez más integradas y potentes para afrontar los desafíos del trabajo, el entretenimiento y la gestión tecnológica del mañana.

![Implicit UVs: Real-time semi-global parameterization of implicit surfaces [pdf]](/images/53316099-06B7-4E1F-8628-5B278003CA34)